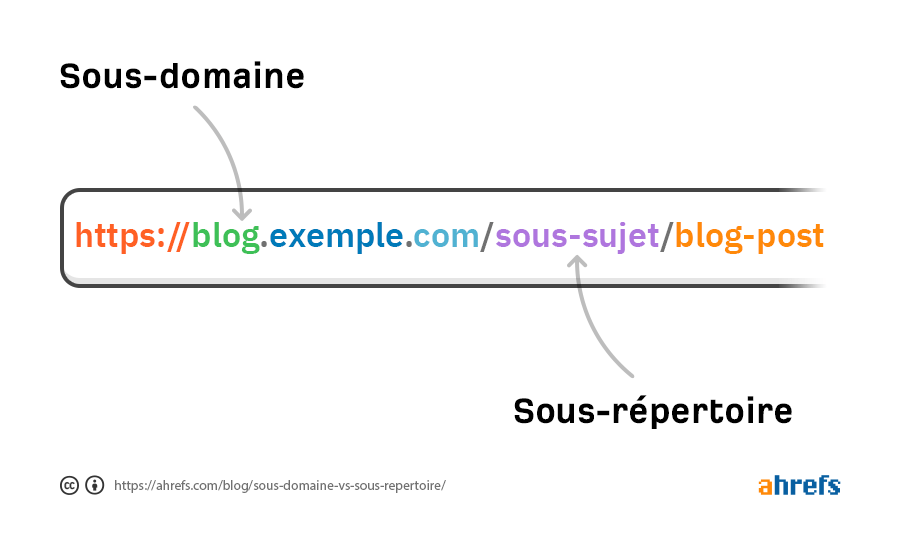

Voyons un peu pourquoi le milieu du SEO débat de ce sujet et comment cela fonctionne réellement.

Les spécialistes du SEO débattent sur le sujet depuis aussi longtemps que je me souvienne. Beaucoup disent que les sous-répertoires donnent de meilleurs résultats SEO et insistent sur leur utilisation. Mais c’est un mythe persistant basé sur de vieilles études.

Google a dit de nombreuses fois que cela n’avait pas d’importance.

En 2012, Matt Cutts disait :

C’est à peu près la même chose. Je conseille de se servir de celui qui est le plus pratique au niveau de votre configuration, de votre CMS et de tout ce genre de choses… Les deux sont finalement sur le même domaine donc c’est vraiment une question de ce qui vous semble le plus simple. Choisissez ce que vous préférez et faites comme ça.

En 2017, John Mueller écrivait :

La recherche Google fonctionne de la même manière que vous utilisiez un sous-domaine ou un sous-répertoire. Changer la structure d’URL d’un site va affecter les résultats de recherche pendant un certain temps avant un retour à la normale. Je conseille donc surtout de choisir une solution qui va persister dans la durée.

Je ne crois pas qu’on puisse faire plus clair, mais certains référenceurs continuent à contredire Google. J’adore d’ailleurs la réponse très sarcastique de John à leurs prétendus arguments.

What reason could Google possibly have to be misleading here? “We’re running low on subdirectory-servers”? I knew this would trigger some folks, so I spent time to prod folks internally about the reality, and there’s nothing to hide here.

— 🍌 John 🍌 (@JohnMu) January 24, 2018

Pour quelle raison est-ce que Google donnerait volontairement une mauvaise information sur ce sujet ? « on commence à être en rade de serveurs de sous-répertoires » ? Je me doutais que cela allait faire tiquer certaines personnes, j’ai donc passé un peu de temps avec les techniciens en interne pour bien comprendre la réalité du sujet, et il n’y a pas de mystère caché là-dessous.

Pourquoi se battre pour savoir si le chemin de droite ou de gauche est le meilleur ? Sans rentrer dans les détails techniques, ces chemins sont virtuels dans l’immense majorité des systèmes modernes, ils ne « pointent » pas vers un emplacement physique sur un serveur. Vous pouvez changer les noms, les emplacements dans les structures d’URL en quelques minutes.

Pensez-y : on peut rapidement transformer un sous-domaine pour qu’il soit présenté comme sous-répertoire sans rien modifier d’autre. Pourquoi est-ce que certaines personnes estiment que leur place dans la structure de l’URL a un réel impact ?

Beaucoup de professionnels du SEO estiment que les sous-domaines sont considérés comme des domaines à part, mais la vérité est plus complexe que cela. Tout site qui incorpore un sous-domaine comme une véritable partie du site le traitera a priori de la même manière un sous-répertoire. Cela dit, si votre sous-domaine ne fait pas partie de votre site (c’est-à-dire qu’ils ne sont pas connectés par des liens internes), là, il pourrait être traité de manière séparée.

Petite leçon d’histoire : à une époque, les sous-domaines permettaient d’obtenir des résultats supplémentaires dans les SERP (page de résultat de recherche). Comme pour beaucoup d’autres éléments, des gens en ont sérieusement abusé. Google a donc modifié ses méthodes dans l’une des vieilles mises à jour de regroupement des domaines/hôtes.

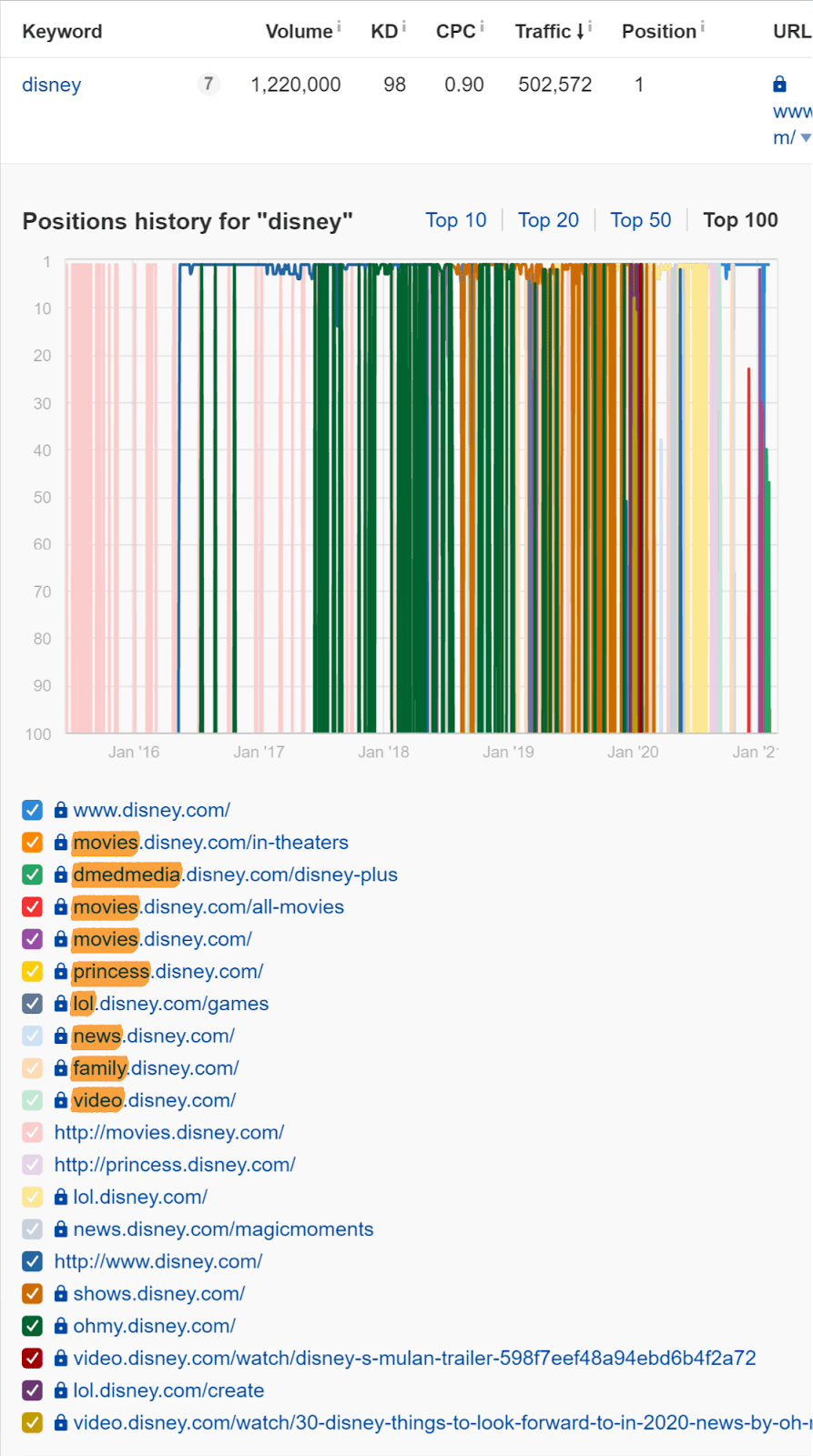

De nos jours, les sous-domaines ont toutes les chances d’être traités comme faisant partie d’un même site si cela a l’air d’être le cas. Même les sitelinks (parfois appelés liens de site) prennent en compte les liens vers les sous-domaines.

Différents sous-domaines de Disney qui se présentent comme des sitelinks. Les données sont issues de l’Explorateur de site de Ahrefs.

Je pourrais vous donner un nombre incalculable d’exemples où des sous-domaines sont présentés comme des sitelinks d’une marque : Github, LinkedIn, Google, Amazon, Microsoft, Yahoo, Netflix, etc.

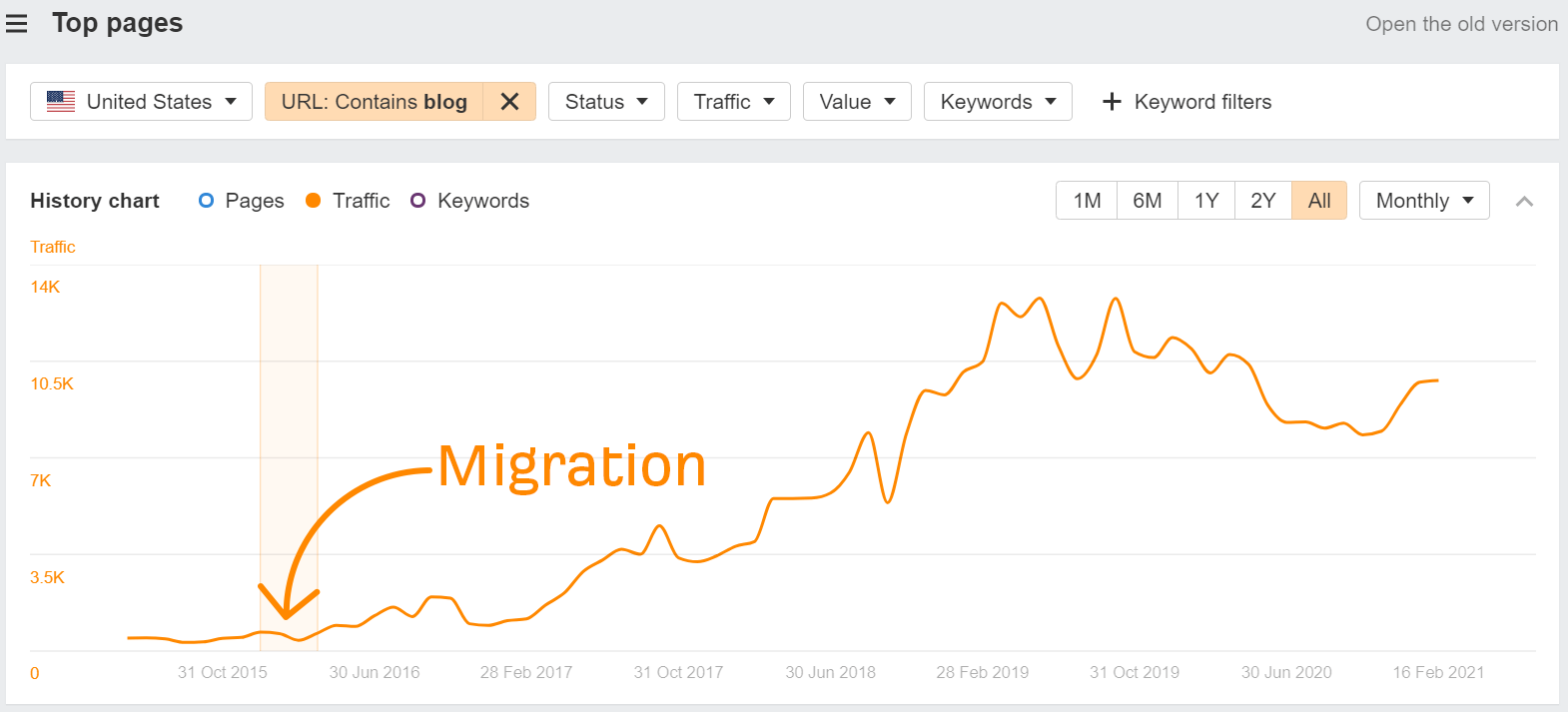

Il existe beaucoup d’études de cas qui montrent que les sous-répertoires donnent de meilleurs résultats que les sous-domaines. Mais je n’en ai pas vu une seule qui ne présentait pas de complications comme du lien interne additionnel ou la migration de plusieurs propriétés en une seule.

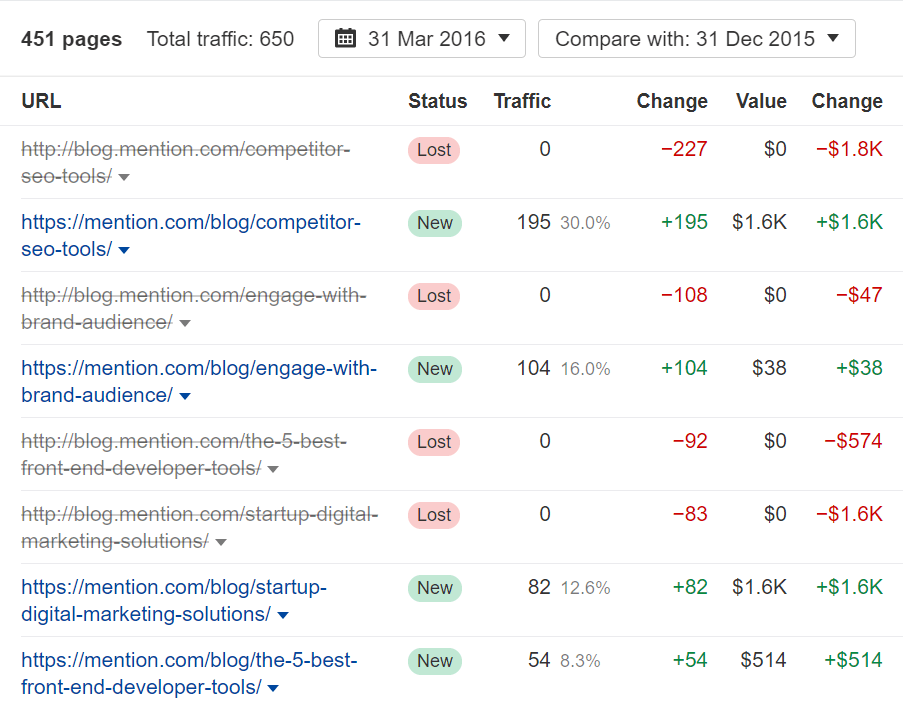

Jetons un œil à l’une d’entre elles que je vous explique mieux ce que je vois. En utilisant top pages 2.0 de l’Explorateur de site vous pouvez cliquer-glisser dans l’historique des diagrammes entre deux dates. Dans le cas de mention.com, ils ont migré d’un sous-domaine à un sous-répertoire en janvier 2016. Je ne repère aucune différence notable à ce moment-là. Ce n’est qu’après avoir fait cela qu’ils ont commencé à ajouter du contenu à leur site et ont vu leur trafic augmenter.

Remarquez de plus que pour chaque page ayant perdu du trafic, une autre équivalente en a regagné à peu près autant. Le flux a simplement changé d’endroit, mais il n’y a pas réellement eu d’augmentation.

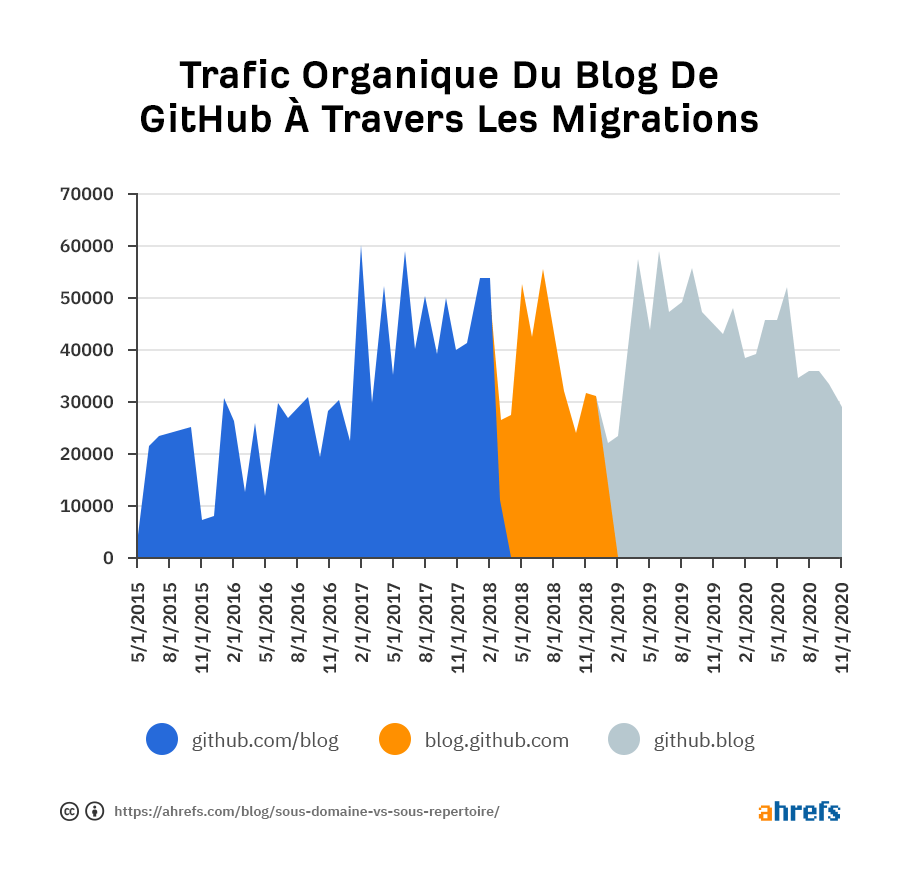

Voici un autre exemple, assez amusant. Github est passé d’un sous-répertoire (github.com/blog) à un sous-domaine (blog.github.com) puis vers un domaine différent (github.blog). Il y a eu des variations pendant les périodes de migration et d’autres changements pendant la transition. Mais il serait difficile d’affirmer que l’une de ces solutions était meilleure que l’autre simplement à cause de l’URL.

Différents problèmes peuvent laisser penser à certaines personnes qu’une migration a ou plus ou moins d’impact qu’elle en a réellement.

Changement temporaire de signaux

Lorsqu’une page est nouvelle ou a été déplacée, Google peut lui faire hériter de signaux temporaires au niveau de leur répertoire ou du site, tout simplement parce qu’il n’est pas encore sûr d’à quel point il peut crawler et comment les positionner pour le moment. Cela peut causer des fluctuations temporaires le temps que les algorithmes comprennent et compilent les changements.

Problème de suivi ou de mesure

Cela peut prendre diverses formes. Peut-être un problème de configuration de l’Analytics comme un suivi de sous-domaine qui n’a pas été fait correctement. Ce peut être un problème de timing comme la mesure d’une augmentation de trafic pendant un pic d’activité, les courses de Noël par rapport à une période normale par exemple, ou encore pendant une mise à jour de Google. L’analyse ne peut suivre que le changement de flux du nouveau répertoire. La chose importante est de s’assurer de ne pas comparer des pommes avec des oranges.

Pages bloquées ou en noindex

Si vous empêchez le crawl de certaines pages ou les placez en noindex, les informations récupérées par Google ne seront pas compilées correctement. Cela veut dire que vous pourriez voir une chute de trafic pendant la migration. Je vous recommande de lire notre guide sur les robots.txt pour mieux comprendre ce phénomène.

Changement de design ou de plateforme

Il y a tellement de choses qui vont changer lorsque vous effectuez une refonte de site ou un changement de plateforme. Les technologies utilisées, la vitesse, les headings, des changements d’URL et bien d’autres éléments vont être modifiés.

Changements de liens internes

Je vois souvent ce cas dans les études de cas de sous-domaine vs sous-répertoire : passer d’un sous-domaine séparé qui n’avait pas de liens internes à un sous-répertoire qui dispose de lien interne sur chaque page. Bien évidemment que l’on va voir une augmentation du trafic en construisant des liens internes.

Contenu retiré ou mis à jour

Modifier du contenu veut dire que le ranking et le trafic ont de grandes chances de changer. Si vous retirez du contenu qui attirait beaucoup de visiteurs, le trafic baisse.

Conclusion

Le changement appelle le risque. Vous devriez y réfléchir à deux fois si votre seule motivation pour passer d’un sous-domaine à un sous-répertoire est d’améliorer le SEO.

Si vous êtes dans le cas où, après une migration, vous avez eu une augmentation du trafic alors qu’aucun des changements cités ci-dessus n’a également eu lieu, j’adorerais étudier ça. N’hésitez pas à m’envoyer un message sur Twitter pour que je fasse une analyse, mais je suis prêt à parier que je trouverai d’autres raisons que la migration pour expliquer la différence.