更多的抓取并不意味着你的排名会更好,但如果你的页面没有被抓取和索引,它们根本就不会排名。

大多数网站不需要担心抓取预算,但在少数情况下你可能需要查看一下。让我们来看看其中的一些案例。

你通常不必担心热门页面上的抓取预算。你需要关注的是较新的页面、没有很好链接的页面、或者不经常抓取的页面。

对于较新的网站,尤其是那些页面较多的网站,抓取预算可能是一个问题。你的服务器可能能够支持更多的抓取,但由于你的网站是新网站并且可能还不是很受欢迎,因此搜索引擎可能不太想抓取你的网站。你希望 Google 对你的网页进行抓取和编入索引,但 Google 不知道是否值得将你的网页编入索引,并且可能不会像你期望那样抓取你的网页。

对于拥有数百万个页面或经常更新的大型网站,抓取预算也可能是一个问题。一般来说,如果你有很多页面没有像你希望的那样经常被抓取或更新,那么你可能需要考虑加快抓取速度。我们将在本文后面讨论如何做到这一点。

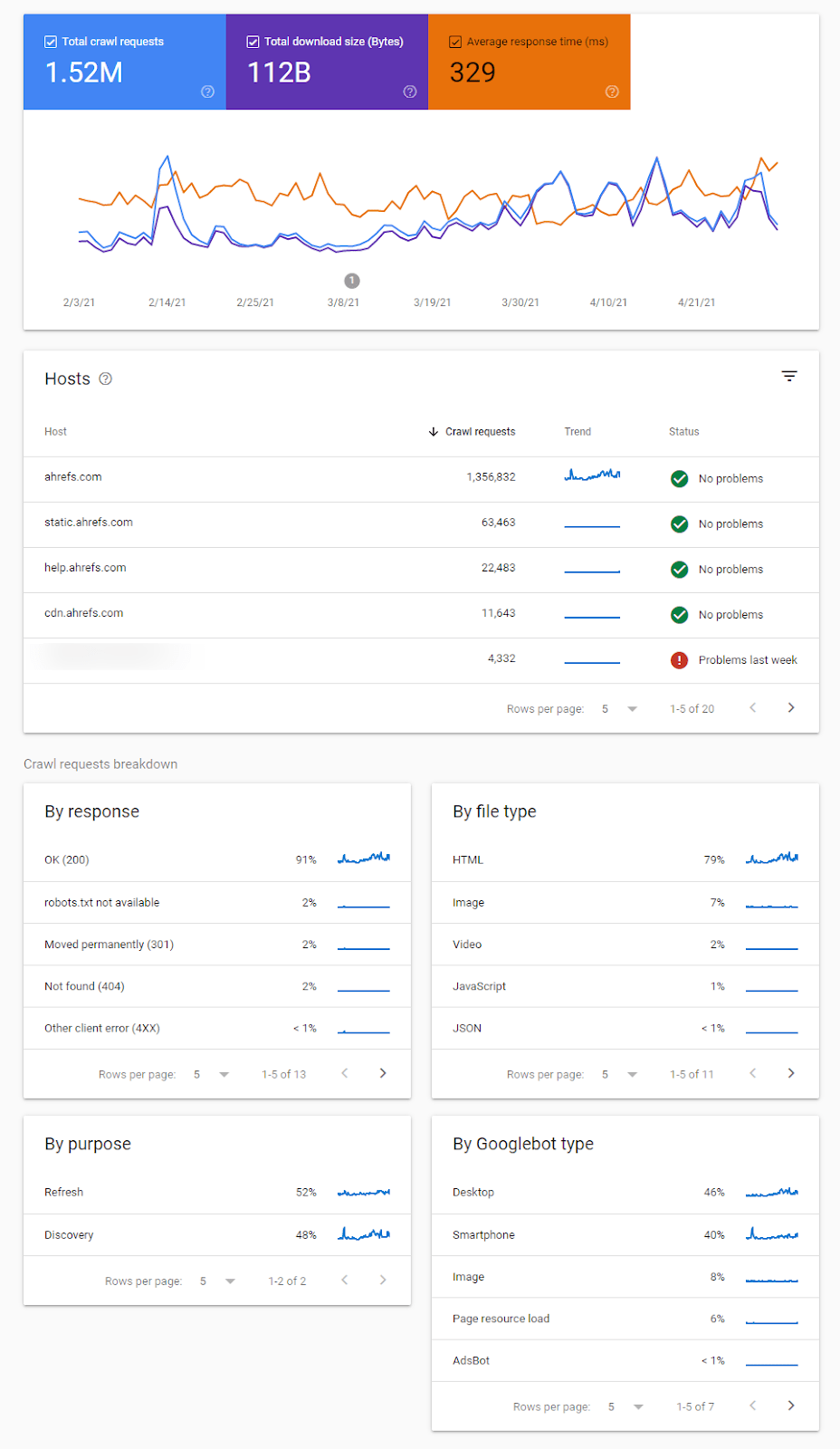

如果你想查看 Google 抓取活动的概述以及他们发现的任何问题,最好用 Google Search Console 中的抓取统计报告。

此处提供了各种报告,可帮助你识别抓取行为的变化、抓取问题,并为你提供有关 Google 如何抓取你网站的更多信息。

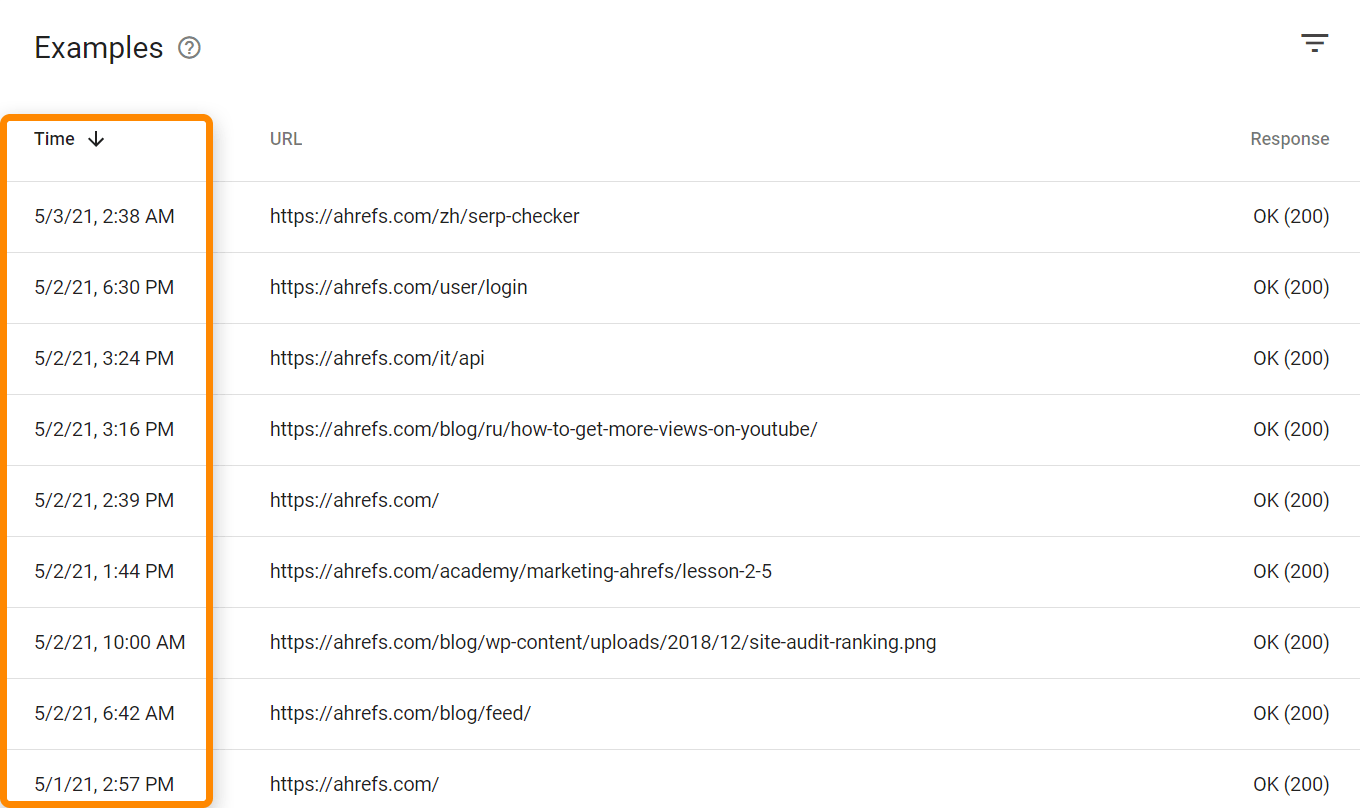

你需要查看有标记的抓取状态,例如此处显示的:

还有上次抓取页面的时间的时间戳。

如果你想查看来自所有爬虫和用户的点击,你需要访问你的日志文件。基于你的服务器环境,你可能可以通过 Awstats 和 Webalizer 等工具来查看。下方就是拥有 cPanel 的共享主机上所见的。这些工具会显示日志文件中的一些汇总数据。

对于更复杂的设置,你必须访问和存储原始日志文件中的数据,可能来自多个来源。对于大型项目,你可能还需要专门的工具,例如 ELK(elasticsearch、logstash、kibana),它允许存储、处理和可视化日志文件。还有 Splunk 等日志分析工具。

所有 URL 和请求都计入你的抓取预算。这包括备用 URL,如 AMP 或 m. 页面、hreflang、CSS 和 JavaScript,包括 XHR 请求。

这些 URL 可以通过抓取和解析页面找到,也可以从各种其他来源(包括站点地图、RSS、在 Google Search Console 中编入索引)或使用索引 API 。

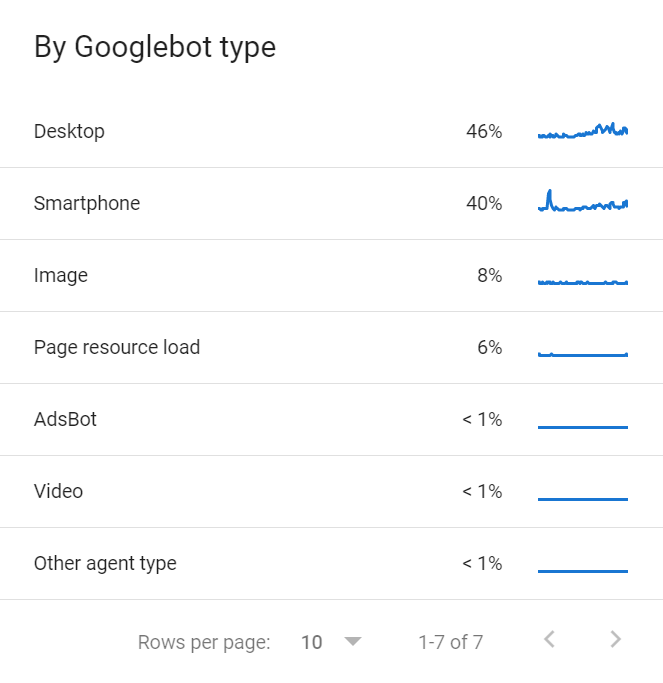

还有多个谷歌爬虫共享抓取预算。你可以在 GSC 的抓取统计报告中找到抓取你网站的各种 谷歌爬虫的列表。

每个网站都有不同的抓取预算,由几个不同的要素决定。

抓取需求

抓取需求就是 Google 想要在你的网站上抓取多少。更受欢迎的页面和变化大的页面将被抓取更多。

受欢迎的页面,或者那些有更多链接的页面,通常会比其他页面获得优先级。请记住,Google 必须以某种方式优先抓取你的网页,而链接是一种确定你网站上哪些网页更受欢迎的简单方法。不仅仅是你的网站,谷歌必须弄清楚如何对互联网上所有网站上页面进行优先级排序。

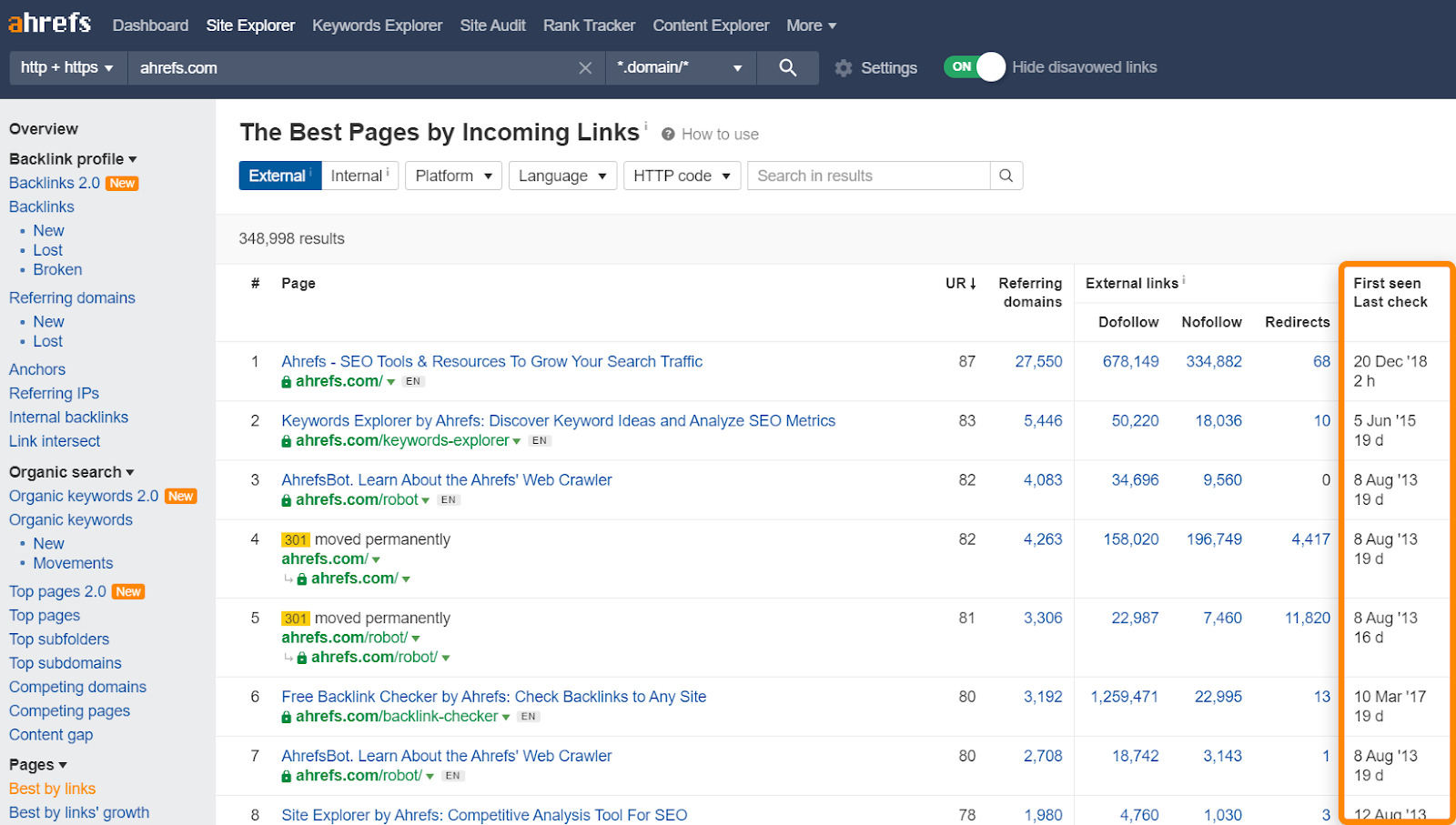

你可以使用 Site Explorer(网站分析) 中的 Best by links(按反链数量排序) 报告来查看哪些页面可能被更频繁地抓取。它还会显示 Ahrefs 上次抓取你的页面的时间。

还有一个老的概念。如果谷歌发现页面没有变化,他们就会降低抓取页面的频率。例如,如果他们抓取一个页面一天后没有看到任何变化,他们可能会等待三天再抓取、下一次 10 天、30 天、100 天等等。他们在两次抓取之间没有实际设定的等待时间,但随着时间的推移,它会变得越来越少。但是,如果 Google 看到整个网站发生了巨大变化或,他们通常会提高抓取速度。

抓取速度限制

抓取速度限制是你的网站可以支持的抓取量。在出现服务器稳定性问题(如速度减慢或错误)之前,网站可以进行一定量的抓取。如果爬虫开始看到这些问题,它们就会停止爬行,以免损害站点。

Google 会根据网站的抓取健康状况进行调整。如果该站点在爬行次数更多时正常,则限制将增加。如果网站有问题,那么谷歌会减慢他们的抓取速度。

你可以采取一些措施来确保你的网站能够支持额外的抓取,并增加你网站的抓取需求。让我们看看其中的一些选项。

加速你的服务器/增加资源

Google 抓取页面的方式基本上是下载资源,然后在它们的一端进行处理。这和用户感知的页面速度并不完全相同。影响抓取预算的是谷歌连接和下载资源的速度,这更多地与服务器和资源有关。

更多外部和内部的链接

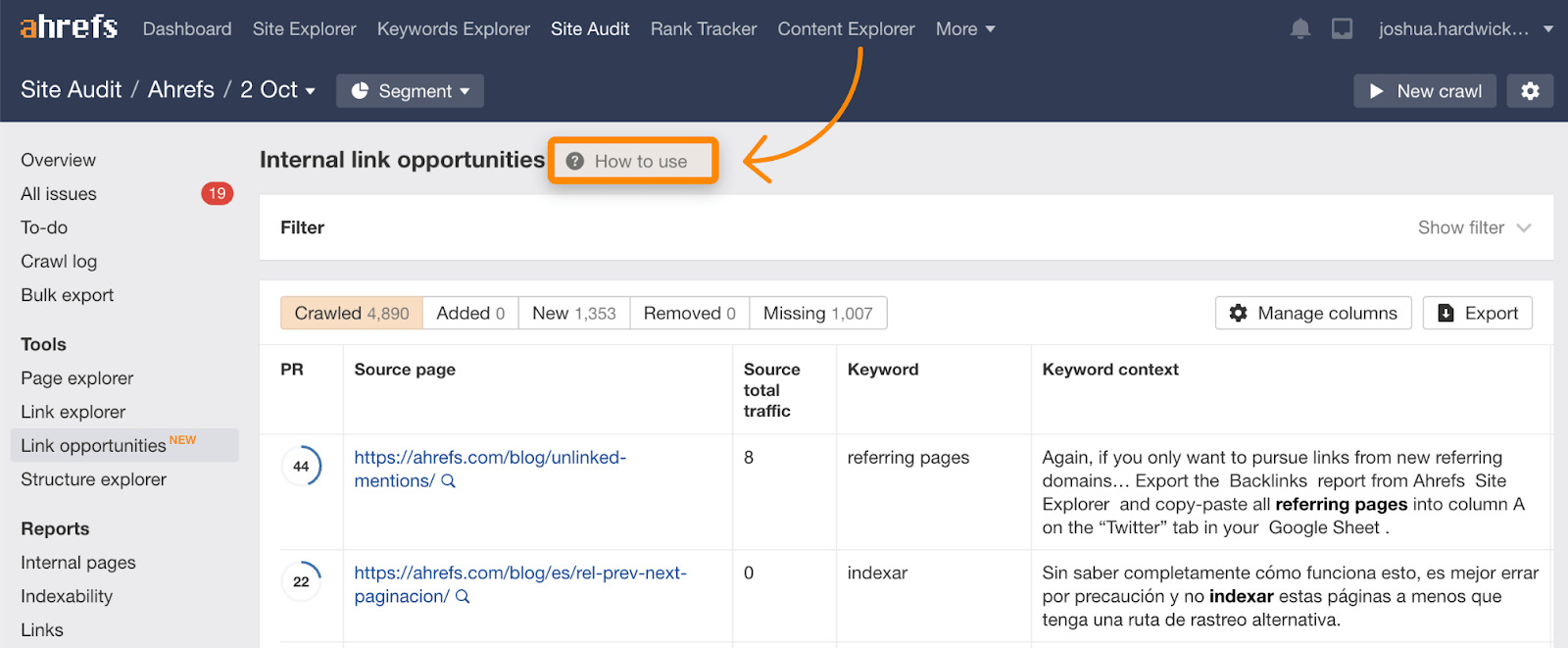

请记住,抓取需求通常基于热度或链接。你可以通过增加外链/或内链的数量来增加预算。由于你控制网站,因此内部链接更容易。你可以在 Site Audit(网站诊断) 的 Link Opportunities(链接机会)报告中找到内部链接的机会,其中还包括解释其工作原理的教程。

修复失效和重定向的链接

保持站点上失效或重定向页面的链接处于活动状态将对抓取预算产生很小的影响。通常,此处链接的页面的优先级相当低,因为它们可能已经有一段时间没有更改了,但清理任何问题通常对维护网站有益,并且会稍微帮助你的抓取预算。

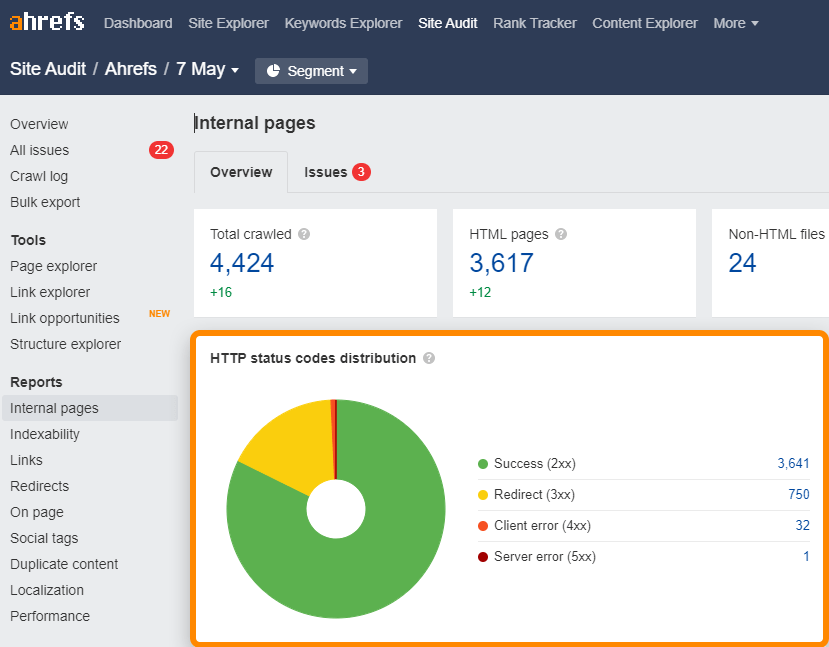

你可以在 Site Audit(网站诊断)的 Internal pages(内部页面)报告中轻松找到站点上的失效 (4xx) 和重定向 (3xx) 链接。

对于站点地图中损坏或重定向的链接,请检查 All issues(所有问题)报告中的 “站点地图中的 3XX 重定向” 和 “站点地图中的 4XX 页面” 问题。

尽可能使用 GET 而不是 POST

这个有点技术性,因为它涉及 HTTP 请求方法。不要在可以使用 GET 请求的地方使用 POST 请求。问题基本在于 GET 与 POST 之间的区别。 POST 请求不会被缓存,因此它们确实会影响抓取预算,但 GET 请求可以被缓存。

使用索引 API

如果你需要更快地抓取页面,请检查你是否有资格使用 Google 的索引 API。目前,这仅适用于少数用例。例如职位发布、或实时视频等。

必应也有一个可供所有人使用的索引 API。

什么不会引起抓取预算变化

人们有时会尝试一些实际上对你的抓取预算没有帮助的事情。

- 网站的小改动。对页面进行小的更改,例如更新日期、空格或标点符号,以希望更频繁地抓取页面。谷歌非常擅长确定变化是否显着,因此这些小的变化不太可能对抓取产生任何影响。

- 使用 Robots.txt 中的抓取延迟指令。该指令将减缓许多爬虫的速度。但是谷歌爬虫不使用它,因此不会产生影响。但 Ahrefs 会遵循这个指令,因此如果你需要减慢我们的抓取速度,你可以在你的 robots.txt 文件中添加抓取延迟。

- 移除第三方脚本。第三方脚本不计入你的抓取预算,因此移除它们无济于事。

- Nofollow。在过去,nofollow 链接不会使用抓取预算。但是,nofollow 现在被视为一种提示,因此 Google 可能会选择抓取这些链接。

有几个好方法可以让 Google 抓取速度变慢。从技术上讲,你还可以进行一些其他调整,例如降低网站速度,但我不推荐这些方法。

调整缓慢,但有保证

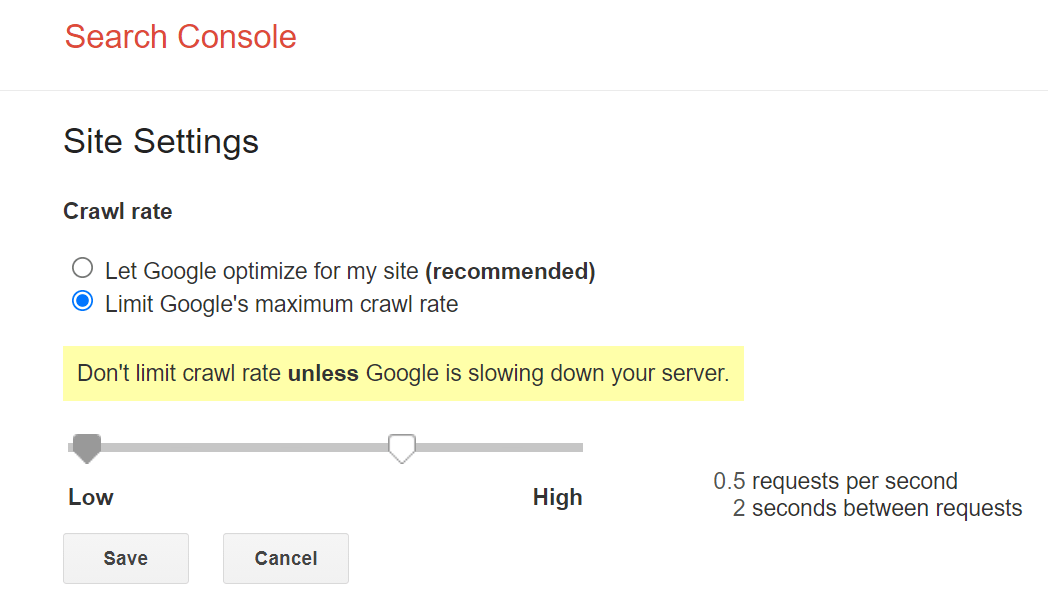

Google 给我们提供提供了限制抓取速度的方法,就是是 Google Search Console 中的速率限制器。你可以使用该工具降低抓取速度,但最多可能需要两天时间才能生效。

快速调整,但有风险

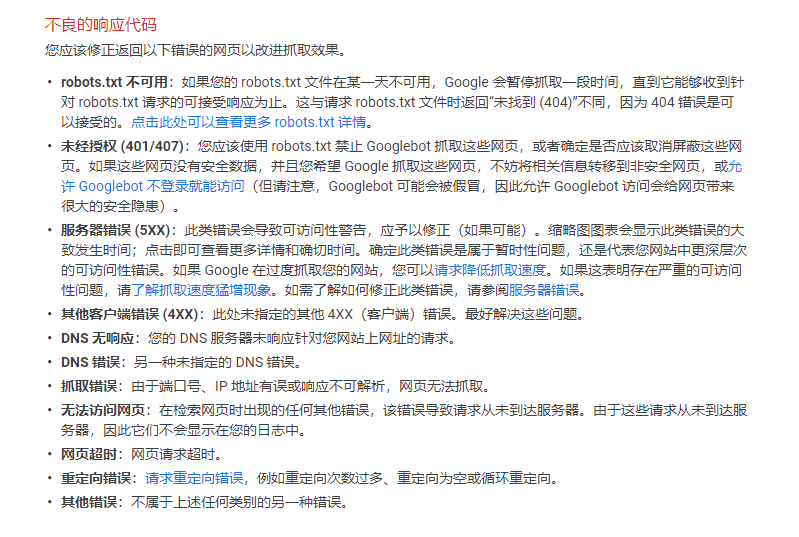

如果你需要更直接的解决方案,你可以利用服务器返回码来 Google 抓取速度调整。如果你在页面上向谷歌爬虫返回 “503 服务不可用” 或 “429 请求过多” 等状态,它们的抓取速度将开始变慢或可能会暂时停止抓取。但是,你可能不希望这种状态持续很长时间,因为有可能 Google 会开始从索引中删除页面。

最后

再次重申,抓取预算不是大多数人需要担心的。如果你确实有疑虑,我希望本指南对你有所帮助。

我通常只在出现页面未被抓取和索引的问题时,或者我碰巧在 Google Search Console 的抓取统计报告中看到了一些让我担心的东西时才会查看它。

有问题吗?在 Twitter 上找我吧。

译者,Park Cheng,魔贝课凡联合创始人。