Si vous voulez avoir la moindre chance d’être visible dans la recherche LLM, vous devez comprendre comment être cité dans les réponses générées par l’IA.

La nouvelle vague d’experts affirme connaître le « secret » de la visibilité IA, mais en réalité, nous sommes tous encore en train de l’apprendre au fur et à mesure.

Voici ce que nous savons à ce jour, sur la base de recherches et d’expérimentations en continu.

La recherche LLM désigne la manière dont les grands modèles de langage collectent et fournissent des informations aux utilisateurs. Cela peut se faire via ChatGPT, Perplexity ou encore les AI Overviews de Google.

Là où les moteurs de recherche vous proposent une liste de liens, un LLM donne directement une réponse dans un langage naturel.

- Parfois, cette réponse repose sur ce que le modèle sait déjà.

- D’autres fois, elle s’appuie sur des sources d’information externes, comme des résultats web récents.

Ce deuxième cas correspond à ce que nous appelons la recherche LLM. Le modèle va alors chercher activement de nouvelles informations, souvent à partir de pages web mises en cache ou d’index de recherche en temps réel, en utilisant un processus appelé génération augmentée par récupération (retrieval-augmented generation, RAG).

Comme la recherche traditionnelle / SEO, la recherche LLM est en train de devenir un écosystème à part entière, mais avec un objectif légèrement différent.

- La recherche SEO consistait à mieux positionner des pages dans les résultats de recherche.

- La recherche LLM vise à garantir que votre marque et votre contenu soient détectables et exploitables dans les réponses générées par l’IA.

| Caractéristique | Recherche traditionnelle | Recherche LLM |

|---|---|---|

| Objectif principal | Aider les internautes à trouver les pages web les plus pertinentes. | Fournir une réponse directe en langage naturel, appuyée par des sources pertinentes. |

| Type de réponses | Une liste de liens, d’extraits, de publicités et parfois des encarts avec des informations rapides. | Une réponse rédigée, souvent accompagnée de brèves explications ou de quelques sources citées ou mentionnées. |

| Origine des réponses | Un index du web mis à jour en continu. | Un mélange des données d’entraînement du modèle et d’informations récupérées via les moteurs de recherche. |

| Fraîcheur des informations | Très élevée. Les nouvelles pages sont crawlées et indexées en permanence. | Moins élevée. Récupère des versions mises en cache des pages web, mais reste globalement à jour. |

| Formulation des requêtes | Requêtes de mots-clés en courte traîne, souvent ambiguës en termes d’intention. | Requêtes conversationnelles, en ultra-longue traîne. |

| Impact sur le trafic | Oriente les utilisateurs vers les sites web et génère des clics. | L’intention est souvent satisfaite directement dans la réponse, ce qui entraîne moins de clics. |

| Leviers d’influence | Bonnes pratiques SEO : mots-clés, backlinks, vitesse du site, données structurées, etc. | Être une source de confiance que le modèle est susceptible de citer : mentions et liens depuis des sites à forte autorité, contenu récent, bien structuré et accessible, etc. |

Les entreprises qui créent les IA ne révèlent pas la manière dont les LLM sélectionnent leurs sources, ce qui rend difficile l’identification des leviers permettant d’influencer leurs réponses.

Voici ce que nous avons appris jusqu’à présent sur l’optimisation pour les LLM, à partir d’études de recherche LLM internes et tierces.

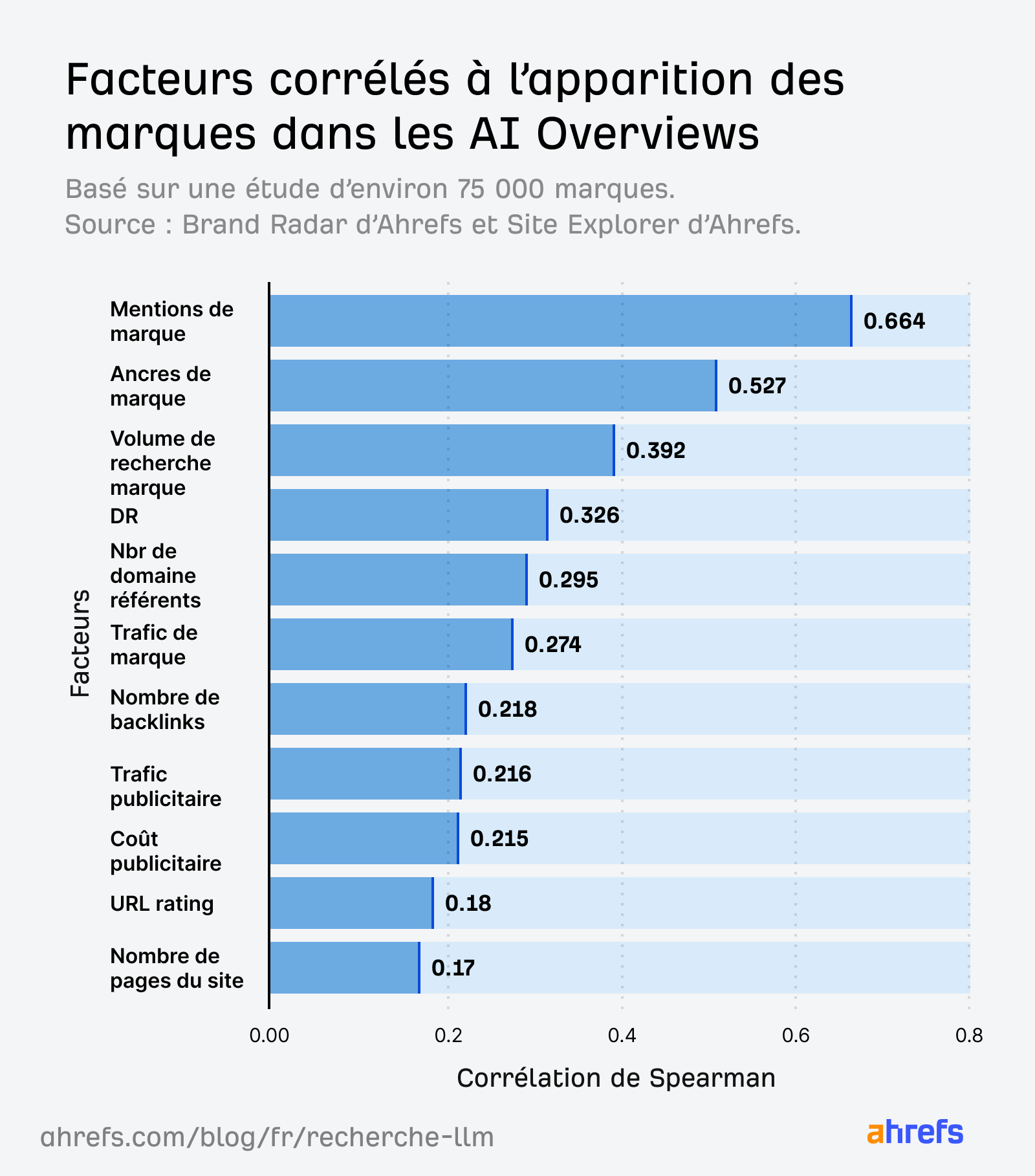

Nous avons analysé 75 000 marques à travers des millions de réponses IA et constaté que les mentions de marque sur le web étaient le facteur le plus fortement corrélé aux mentions de marque, comme dans les AI Overviews.

Davantage de mentions de marque signifie davantage d’exemples d’entraînement pour un LLM.

Le LLM « voit » alors plus souvent ces marques pendant sa phase d’entraînement et peut mieux les associer à des thématiques pertinentes.

Mais cela ne signifie pas que vous devez courir après les mentions pour le simple fait d’en accumuler. Concentrez-vous plutôt sur la construction d’une marque qui mérite d’être citée.

La qualité compte davantage que le volume.

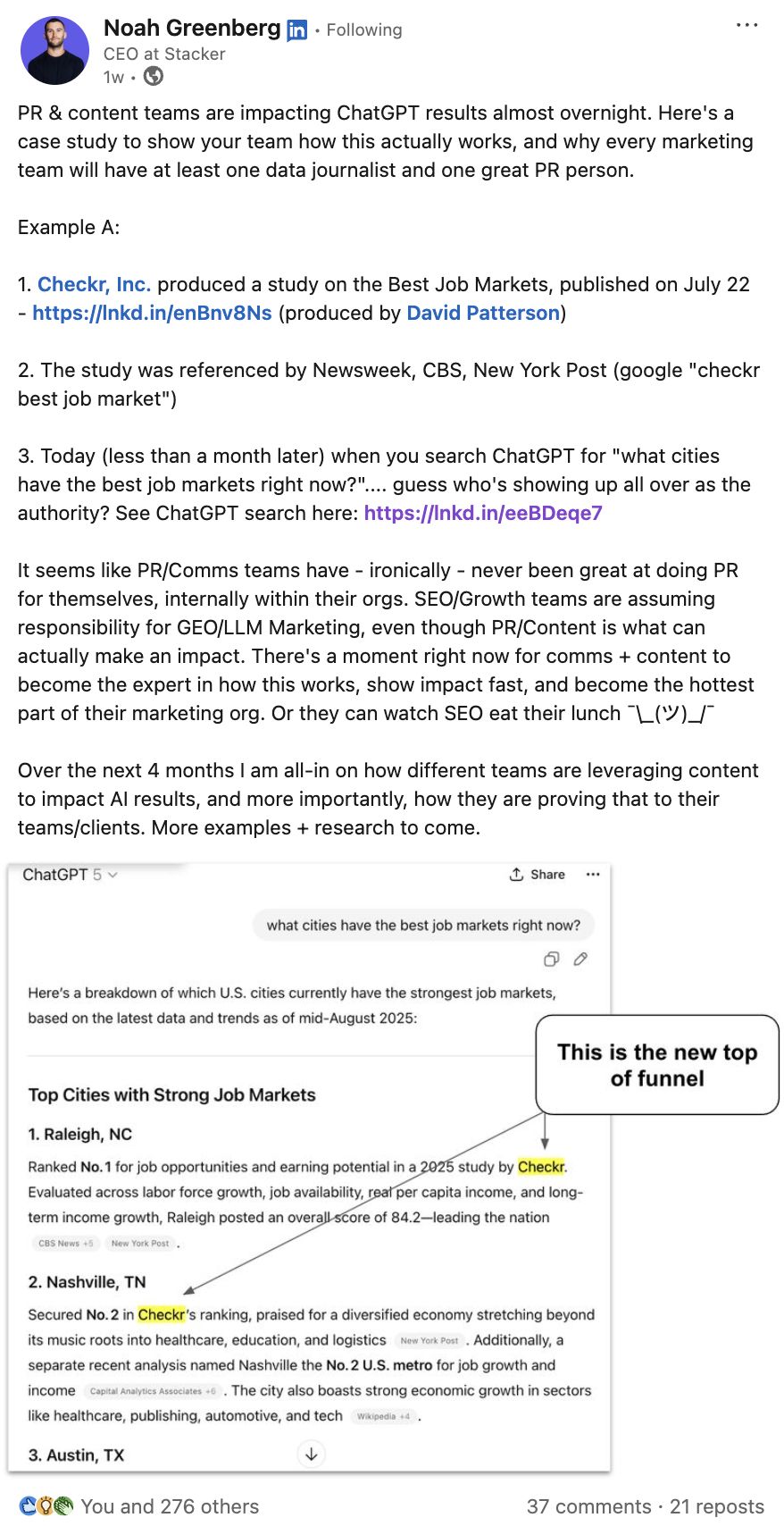

En voici la preuve. Checkr, Inc. a mené une étude sur les meilleurs marchés de l’emploi, reprise par seulement quelques publications de référence, dont Newsweek et CNBC.

Pourtant, en l’espace d’un mois, Checkr était mentionnée de manière récurrente dans des conversations IA pertinentes.

J’ai vérifié ce point sur différents profils ChatGPT afin de tenir compte des variations liées à la personnalisation, et Checkr était mentionnée à chaque fois.

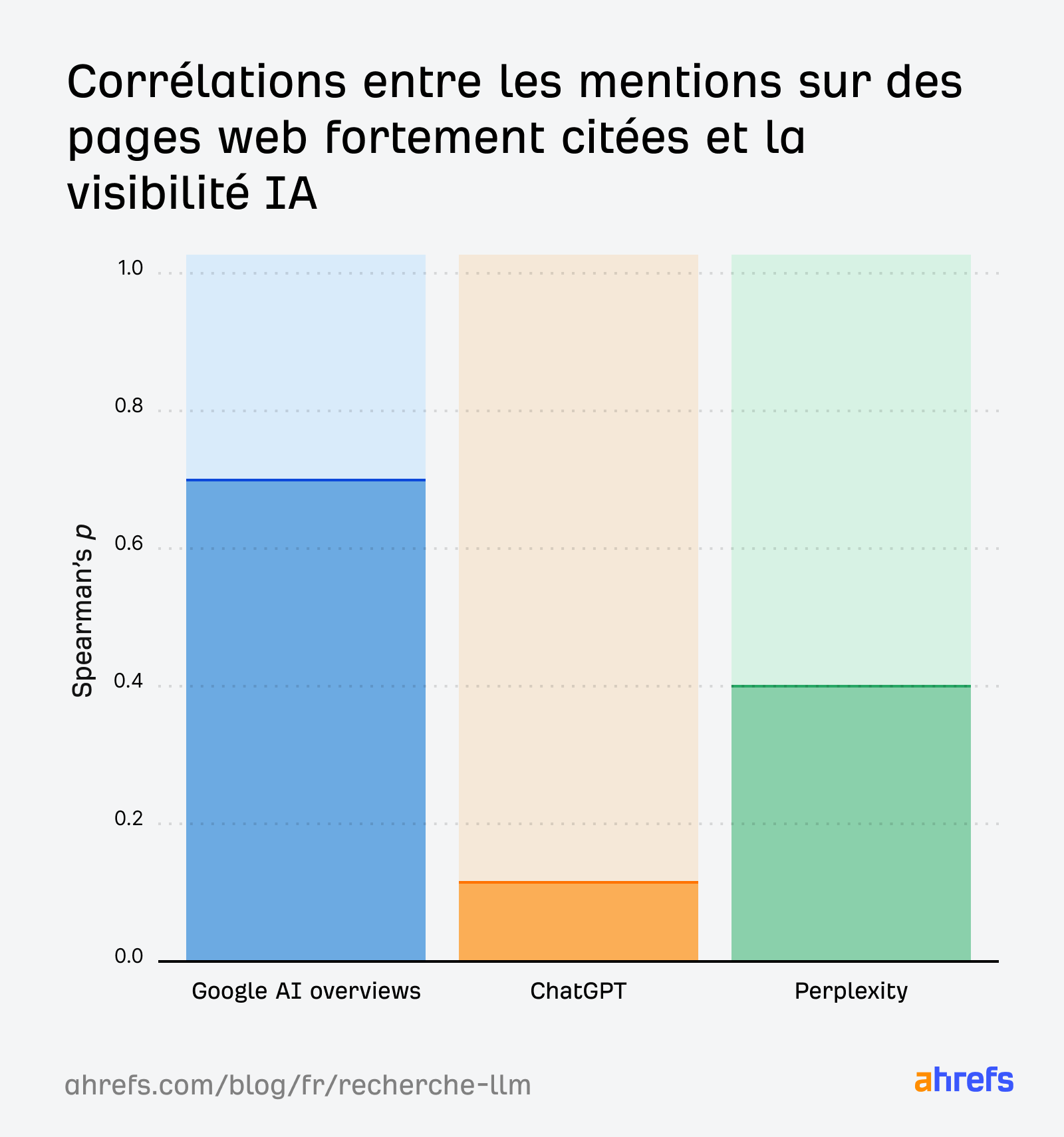

Selon une étude menée par le Product Advisor d’Ahrefs, Patrick Stox, obtenir des placements sur des pages à forte autorité ou à fort trafic permet d’amplifier votre visibilité IA dans le temps.

Les mentions dans les AI Overviews de Google sont fortement corrélées aux mentions de marque sur des pages disposant d’un grand nombre de liens. Le coefficient de corrélation est d’environ 0,70. Nous observons un effet similaire pour les marques présentes sur des pages à fort trafic, avec un coefficient d’environ 0,55.

Lorsque cela se produit, les associations positives et une autorité durable deviennent les véritables facteurs différenciants dans la recherche LLM.

Concentrez-vous sur le développement d’une notoriété de qualité à travers :

PR et partenariats de contenu

Pour une visibilité IA durable, collaborez avec des sources et des marques de confiance. Cela vous aidera à construire des associations de qualité.

Chez Ahrefs, ce n’est un secret pour personne que nous cherchons, comme beaucoup d’autres, à renforcer notre autorité sur les thématiques liées à l’IA.

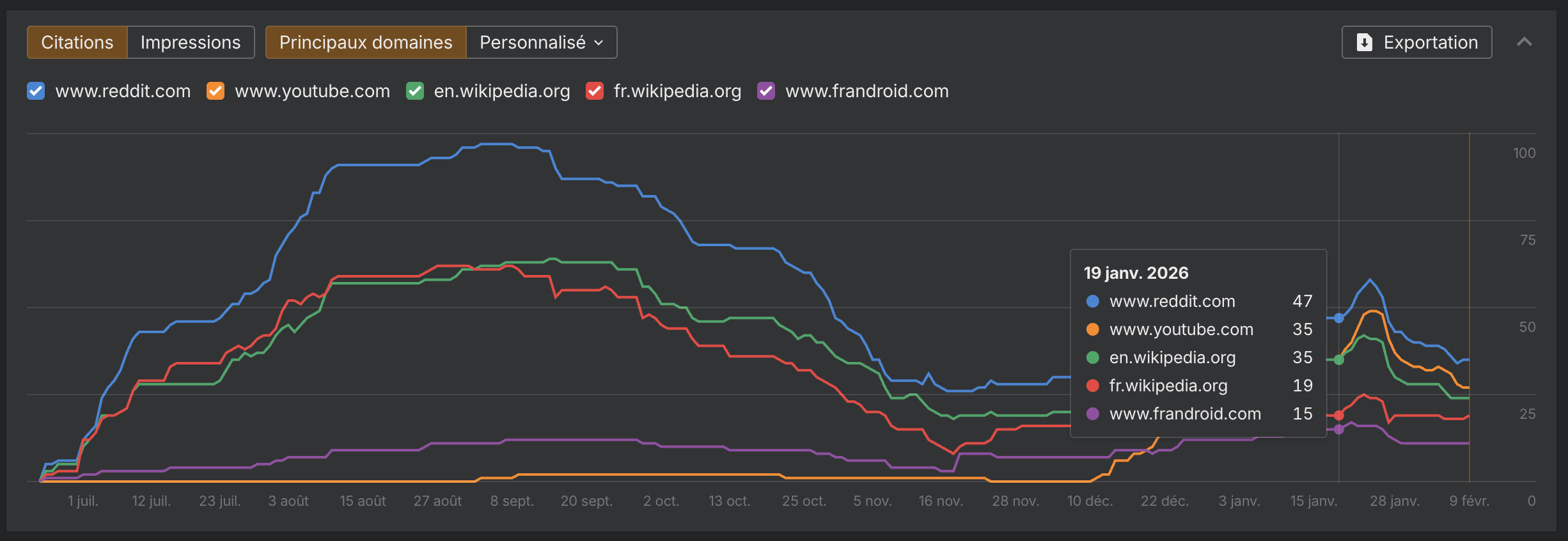

Pour identifier des opportunités de collaboration, on utilise Brand Radar d’Ahrefs et utiliser le rapport Domaines cités.

Dans cet exemple, j’ai défini ma niche sur « GEO » et j’ai analysé les domaines les plus cités par ChatGPT en France.

Une marque faisant autorité semble susceptible de montrer l’importance d’une approche RP : Frandroïd.

Vous pouvez reproduire cette analyse pour votre propre marché. Identifiez les sites qui apparaissent de manière cohérente sur plusieurs niches et développez des collaborations durables avec les plus visibles.

Avis et création de communauté

Pour générer des mentions positives, encouragez des discussions authentiques et le bouche-à-oreille des utilisateurs.

Chez Ahrefs, nous le faisons en permanence. Notre CMO, Tim Soulo, sollicite régulièrement des retours sur les réseaux sociaux. Notre Product Advisor, Patrick Stox, participe fréquemment à des discussions sur Reddit. Et nous orientons l’ensemble de nos utilisateurs vers notre plateforme de feedback client, où ils peuvent échanger, proposer et voter pour des fonctionnalités.

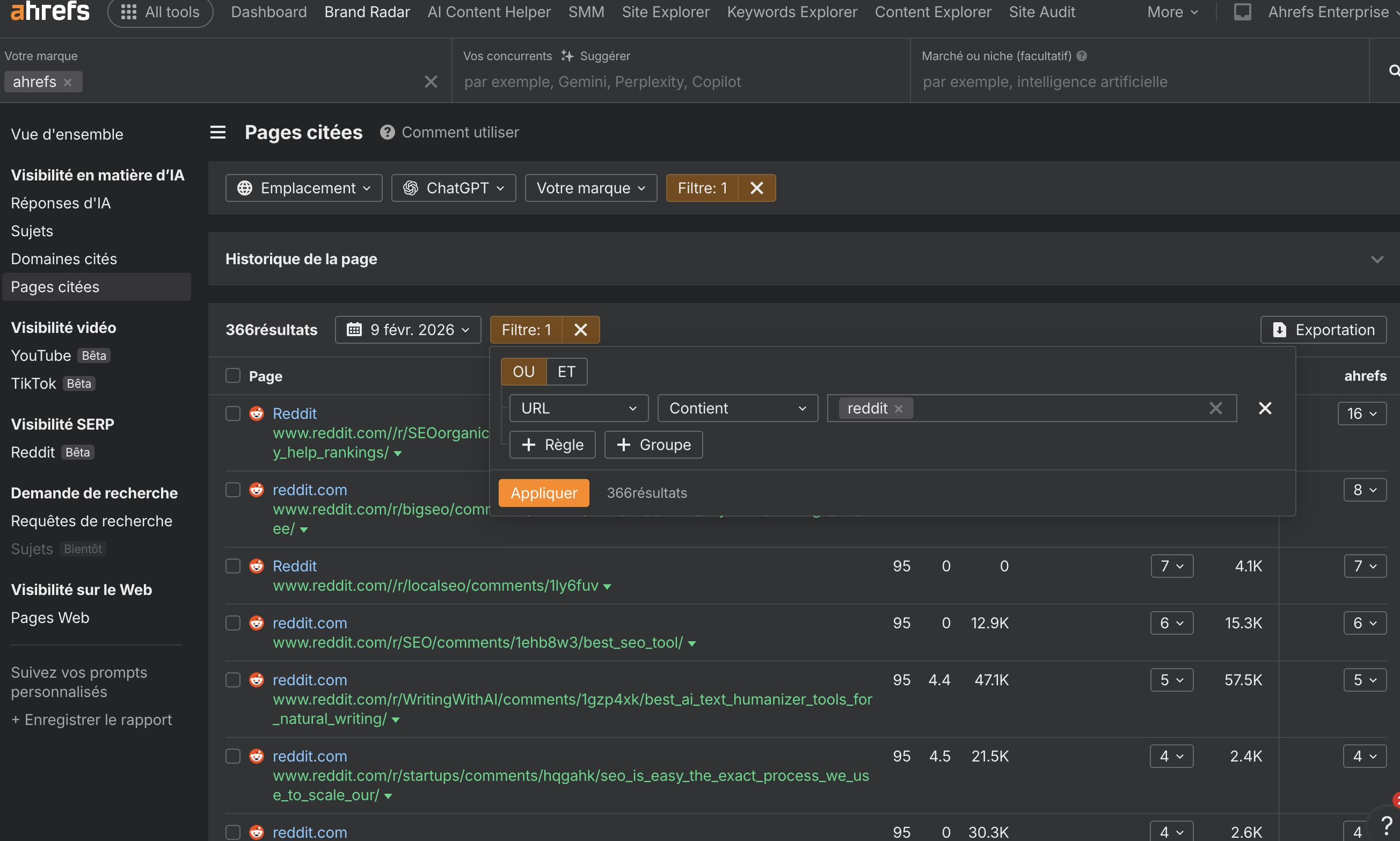

Vous pouvez utiliser Brand Radar d’Ahrefs pour amorcer votre propre stratégie communautaire.

- Rendez-vous dans le rapport Pages citées,

- saisissez votre marque

- Filtrez en ajoutant reddit pour l’URL

- analysez quelles discussions issues de contenus générés par les utilisateurs apparaissent dans les réponses IA associées à votre marque.

Dans cet exemple, j’ai relevé les subreddits qui mentionnent régulièrement Ahrefs.

L’une des approches possibles consiste à renforcer notre présence au sein de ces communautés.

Mon collègue SQ a rédigé un excellent guide qui explique comment être présent de manière authentique sur Reddit en tant que marque. Il date de 2023, mais ses recommandations restent vraiment d’actualité. Je vous conseille vivement de le lire.

Positionner sa marque

Lorsque votre message de marque est clair et maîtrisé, vous donnez aux audiences le bon vocabulaire pour décrire votre marque, ce qui renforce sa notoriété.

Plus ce message est répété, plus il occupe d’espace dans l’esprit des utilisateurs, et dans la recherche LLM.

Cela vous permet de gagner une plus grande « part de mémoire ».

Vous pouvez évaluer l’impact de votre message de marque en suivant vos co-mentions.

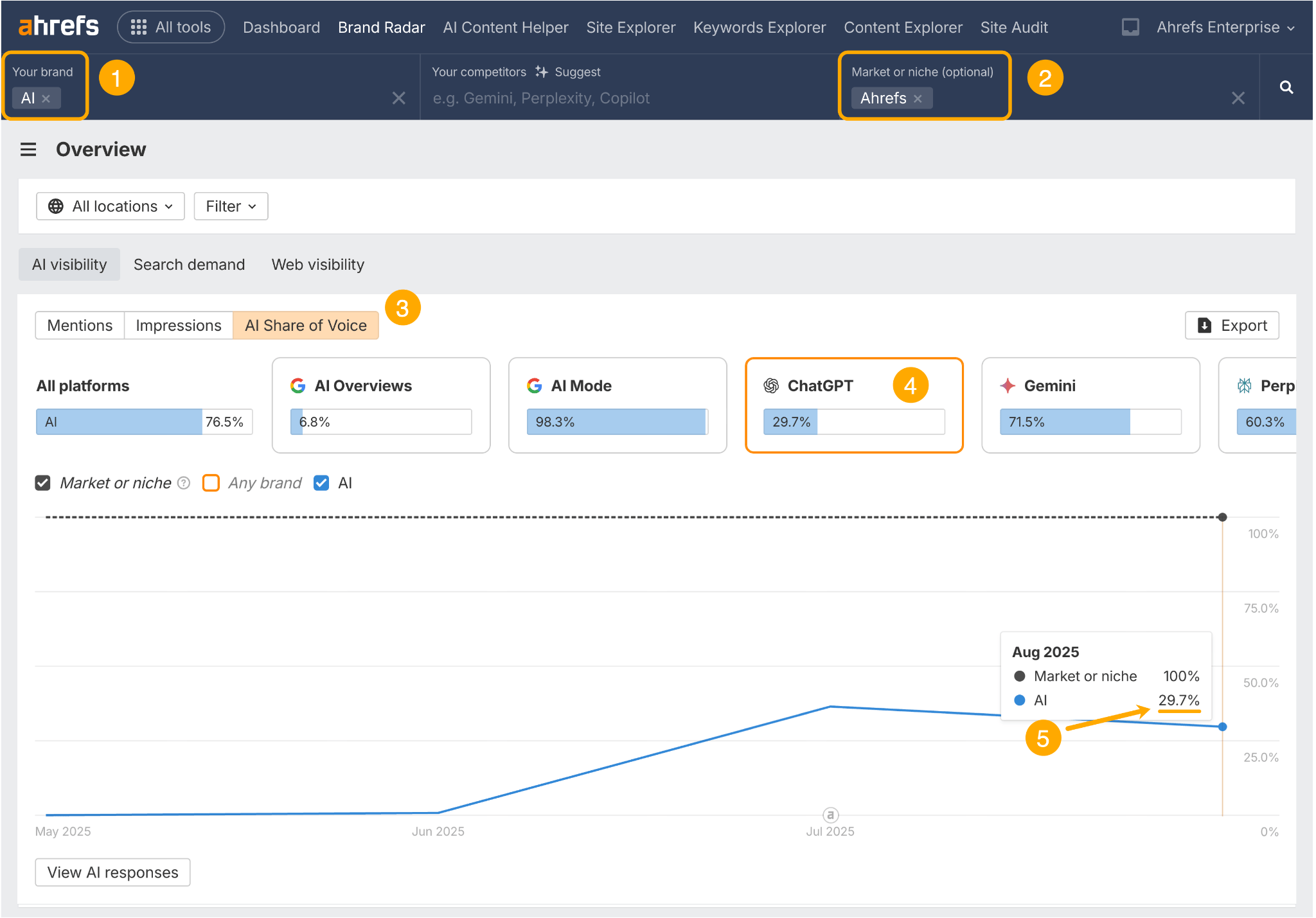

Rendez-vous sur le tableau de bord principal de Brand Radar d’Ahrefs, puis :

- Ajoutez votre thématique de co-mention dans le champ « brand »

- Ajoutez le nom de votre marque dans le champ « market or niche »

- Accédez au rapport Part de voix IA

- Sélectionnez la plateforme IA que vous souhaitez analyser

- Suivez l’évolution de votre pourcentage de co-mentions dans le temps

Je vois que 29,7 % des mentions d’« Ahrefs » dans ChatGPT mentionnent également le sujet de l’IA.

Si nous voulons dominer les conversations autour de l’IA dans la recherche LLM, ce qui est d’ailleurs clairement notre objectif, nous pouvons suivre ce pourcentage dans le temps afin d’évaluer l’alignement de la marque et d’identifier les leviers qui font réellement la différence.

*

Lorsqu’il s’agit d’accroître la notoriété de la marque, la pertinence est essentielle.

Votre contenu off-site doit être aligné avec votre produit et votre discours de marque.

Plus les mentions sont pertinentes par rapport à votre marque, plus il est probable que les utilisateurs continuent à la mentionner, à la rechercher et à la citer.

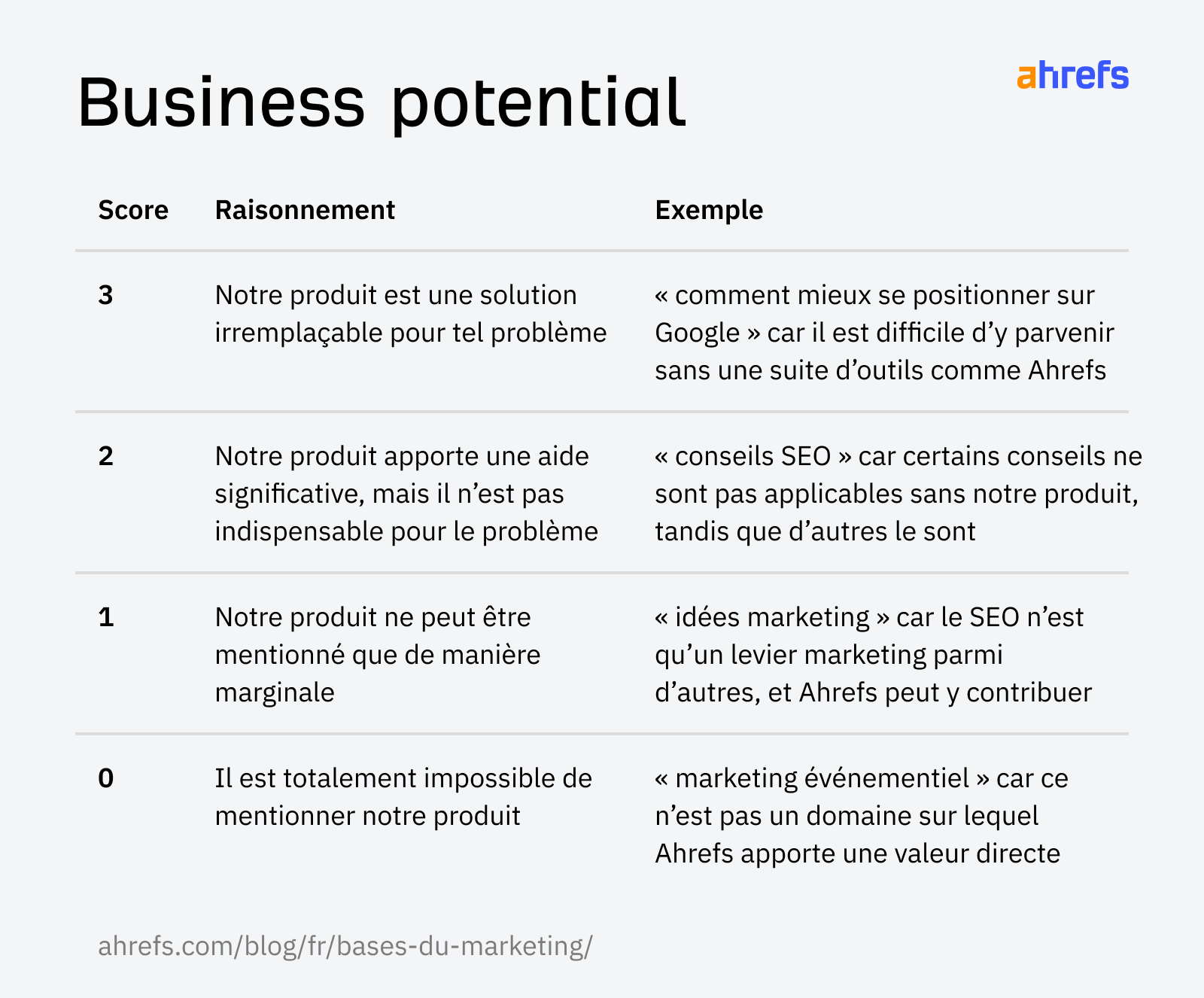

Je raisonne cela à travers notre matrice de Business Potential. Nous cherchons à produire du contenu sur des sujets qui obtiennent un score de « 3 » sur l’échelle du Business Potential. Ce sont des thématiques qui ne peuvent tout simplement pas être abordées sans mentionner Ahrefs.

Quand on veut apparaître dans la recherche LLM, vous devez penser à couvrir des thématiques à fort Business Potential afin de créer une boucle vertueuse entre mentions sur le web et visibilité IA.

De nombreux conseils circulent sur la manière de structurer le contenu pour l’IA et la recherche LLM, mais tous ne sont pas étayés par des données solides.

De mon côté, j’ai été prudente avant de formuler des recommandations sur ce sujet, pour éviter de propager des fausses informations.

C’est précisément pour cette raison que l’article de Dan Petrovic, consacré à la façon dont Chrome et l’IA de Google gèrent les embeddings, a constitué une contribution particulièrement bienvenue au débat.

Voici ce que j’en ai retenu.

Rédiger du contenu de type « BLUF ». Commencez par l’essentiel

Chrome ne prend en compte que les 30 premiers passages d’une page pour les embeddings.

- Cela signifie que votre contenu le plus important doit apparaître très tôt. Ne gaspillez pas ces passages précieux avec du texte générique, du remplissage ou des introductions faibles.

- Par ailleurs, un article très long ne génère pas une infinité de passages. Il existe une limite.

- Si vous souhaitez couvrir plusieurs sous-thématiques, il est préférable de créer des articles distincts et ciblés, plutôt qu’un contenu massif qui risque d’être tronqué en cours de route.

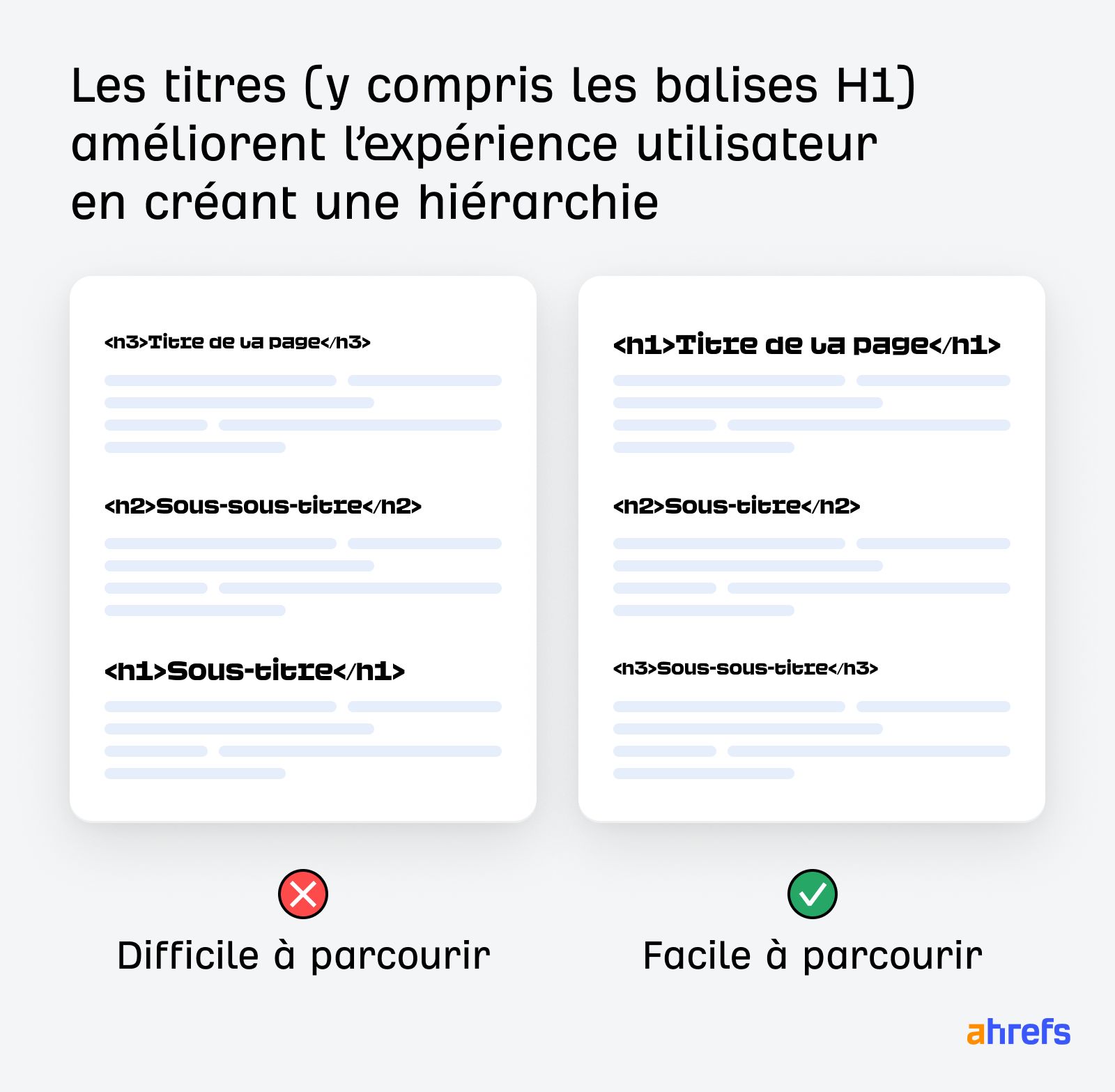

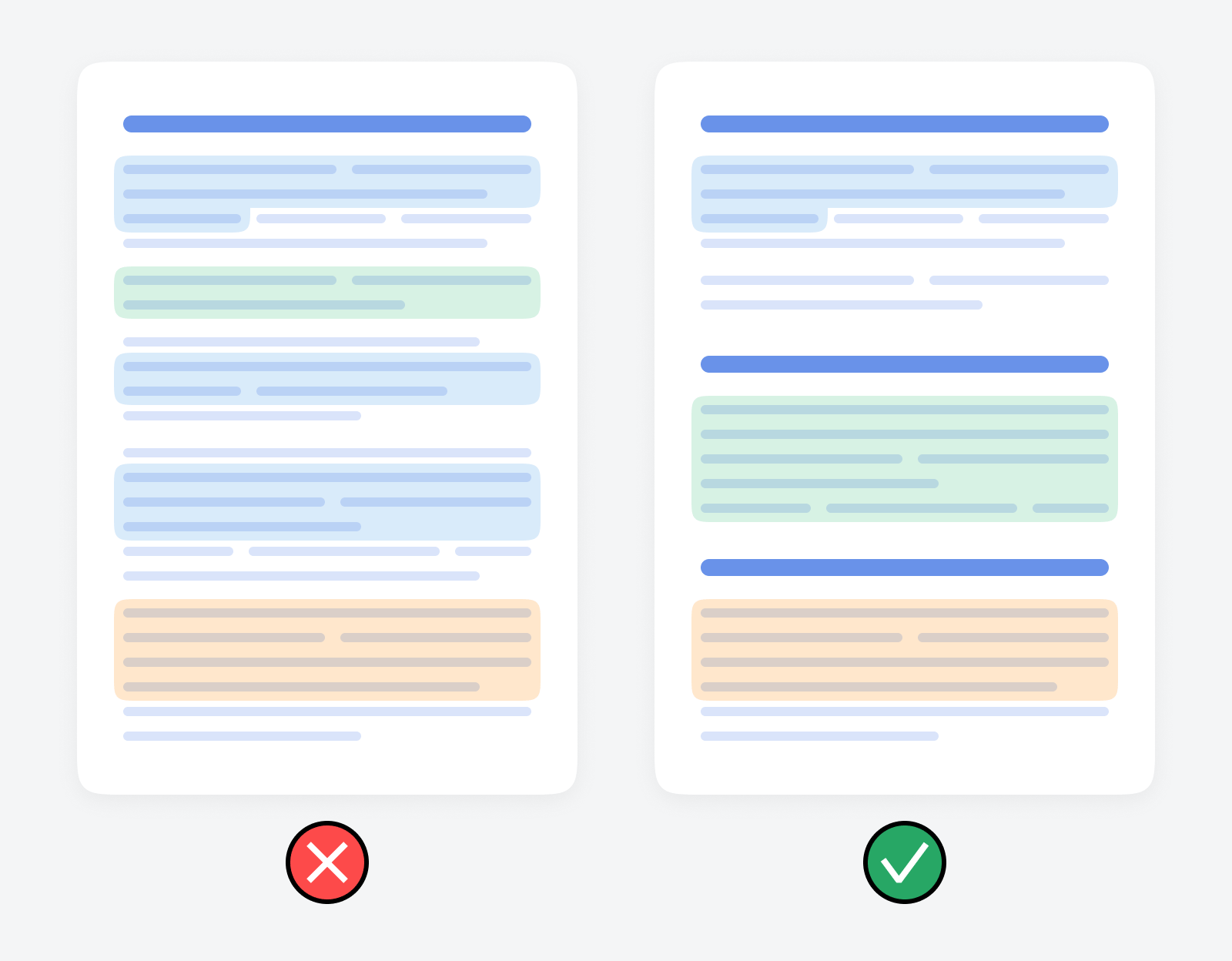

Organiser le contenu de manière logique

L’IA de Google utilise un algorithme de type « tree-walking ». Elle suit strictement la structure HTML sémantique d’une page web de haut en bas. C’est pour cette raison qu’un contenu bien formaté et bien structuré est plus facile à traiter.

Organisez votre contenu de manière logique, avec des titres clairs, des sous-titres explicites et des listes à puces.

Je suis certain que vous le faites déjà de toute façon !

Gardez un contenu concis. Inutile de le « découper » artificiellement.

Les LLM segmentent le contenu en « passages » plus petits pour les embeddings.

Selon les travaux de Dan Petrovic, Chrome utilise un « DocumentChunker Algorithm » qui n’analyse que des passages de 200 mots.

- La structure est déterminante. Chaque section a de fortes chances d’être récupérée de manière isolée.

- Le « chunking » n’est pas forcément la solution.

Vous n’avez pas besoin de faire en sorte que chaque section de votre contenu fonctionne comme une idée totalement autonome au cas où elle serait citée.

Et vous n’avez certainement pas besoin de rédiger vos articles comme une succession de mises à jour de statut. Ce n’est pas une expérience de lecture souhaitable pour un utilisateur.

À la place, regroupez les paragraphes de manière logique et développez vos idées de façon claire, afin qu’elles restent compréhensibles même si elles sont extraites ou réassemblées.

- Évitez les sections longues et décousues, qui risquent d’être tronquées ou segmentées de manière inefficace.

- Évitez également de forcer les répétitions dans votre rédaction. Les systèmes d’IA gèrent très bien les chevauchements de contenu.

Par exemple, Chrome utilise le paramètre overlap_passages afin de s’assurer que le contexte principal n’est pas perdu aux frontières entre les passages.

Concentrez-vous donc sur une lecture fluide et naturelle, plutôt que de vous répéter artificiellement pour « relier » les sections. Le chevauchement est déjà pris en charge nativement.

La création de clusters de contenus et le ciblage de questions utilisateurs de niche peuvent augmenter vos chances d’apparaître dans une réponse générée par l’IA.

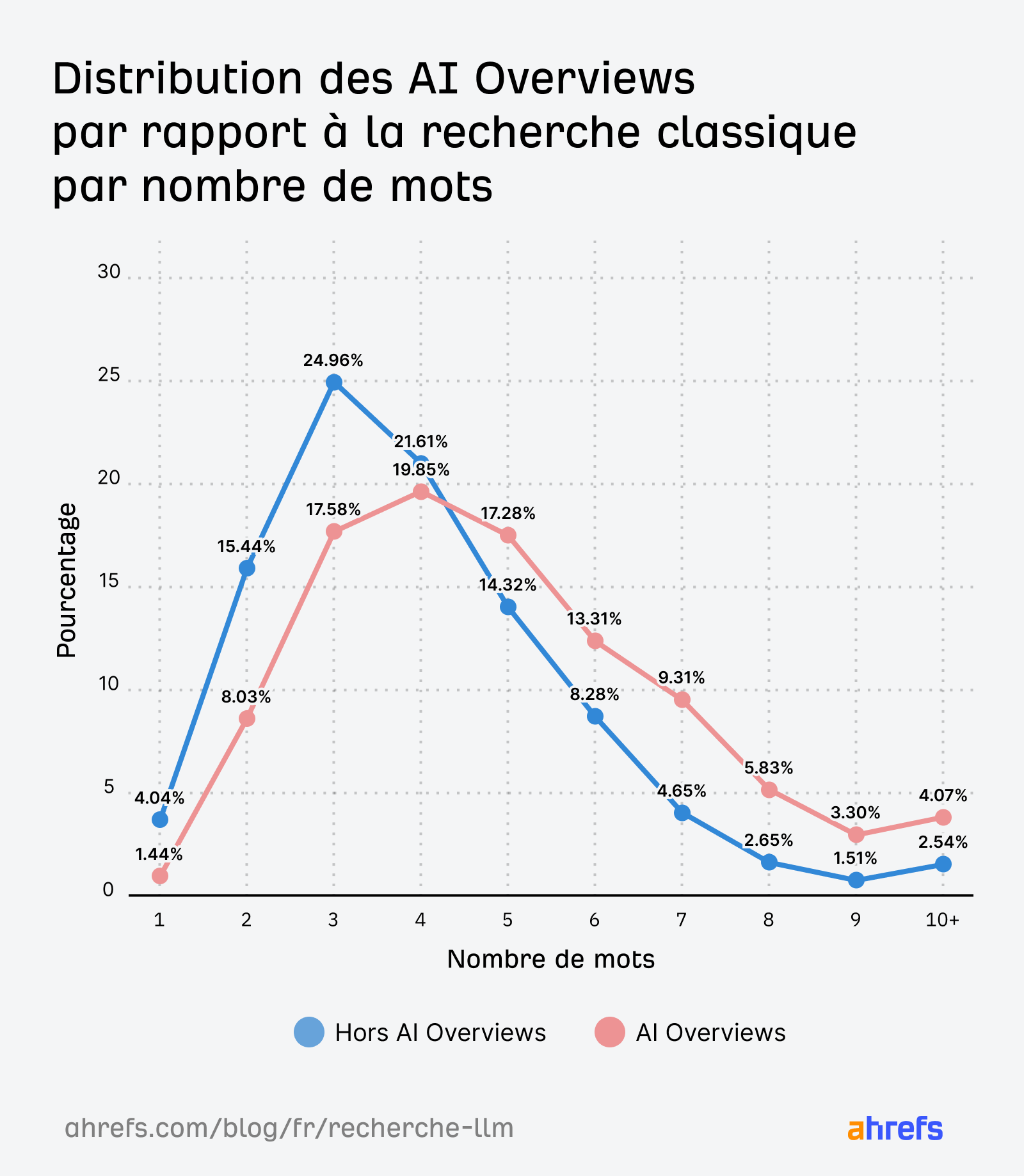

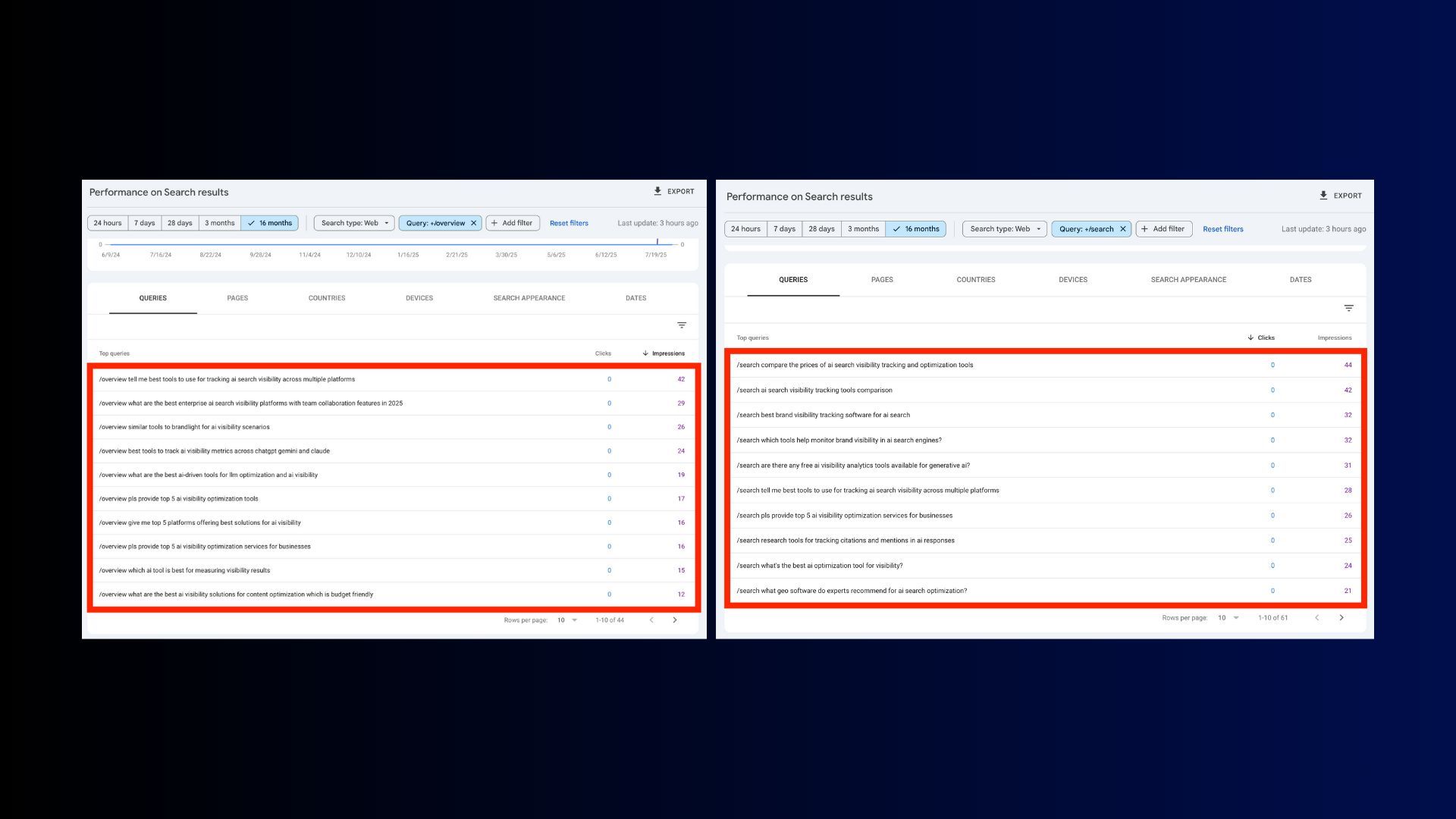

Nos recherches sur les AI Overviews montrent que les requêtes des utilisateurs dans les interfaces IA sont plus longues et plus complexes que celles issues de la recherche traditionnelle.

Dans les assistants IA comme ChatGPT et Gemini, les requêtes sont majoritairement orientées vers de la longue traîne très spécifique.

Le Growth Marketing Manager d’AppSamurai, Metehan Yeşilyurt, a analysé environ 1 800 conversations réelles sur ChatGPT et a constaté que la longueur moyenne d’un prompt atteignait 42 mots.

Et la multiplication des requêtes de longue traîne ne fait que s’accélérer.

Comment fonctionne la recherche LLM :

- Les assistants IA « déploient » les prompts en de nombreuses sous-requêtes de longue traîne.

- Ils font ensuite passer ces sous-requêtes par des moteurs de recherche afin d’identifier les meilleures sources à citer.

Cibler des mots-clés de longue traîne peut donc augmenter vos chances de correspondre à l’intention utilisateur et d’obtenir des citations.

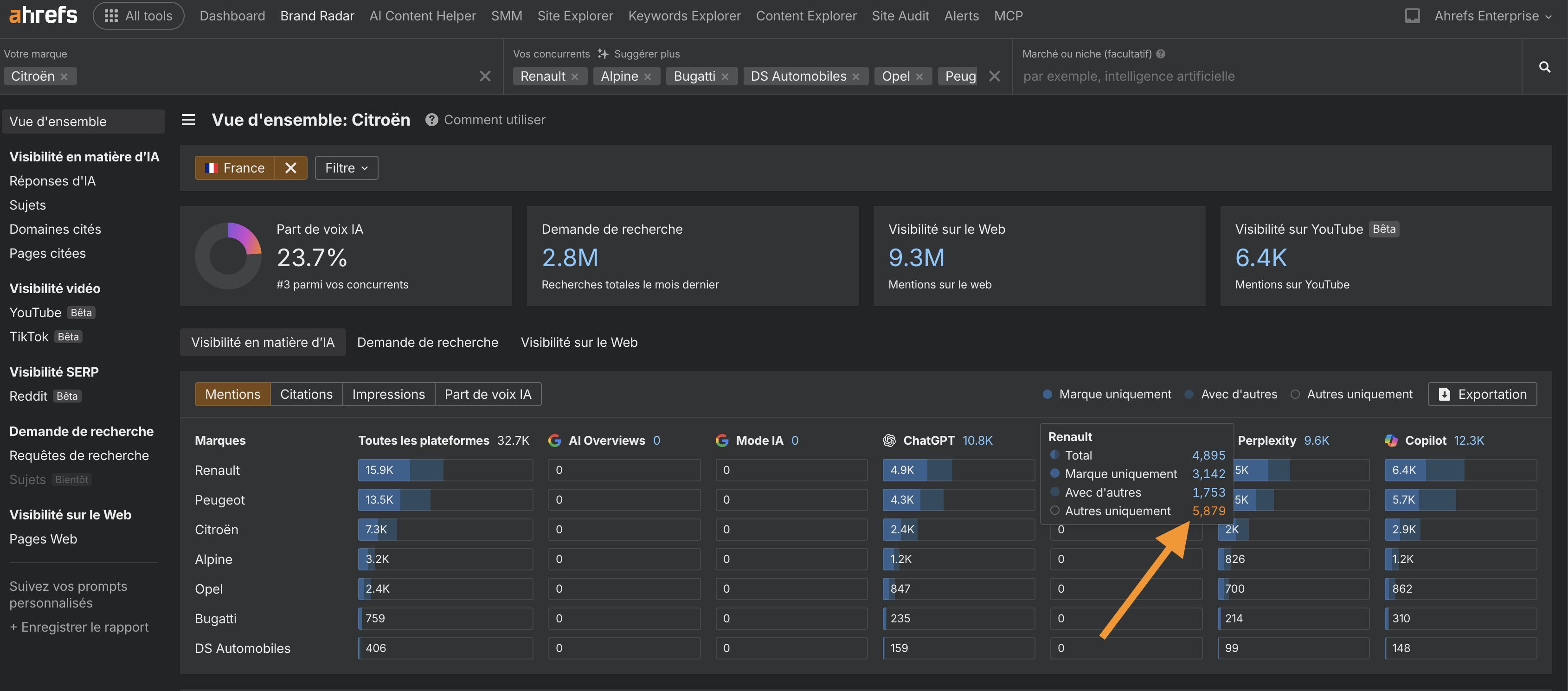

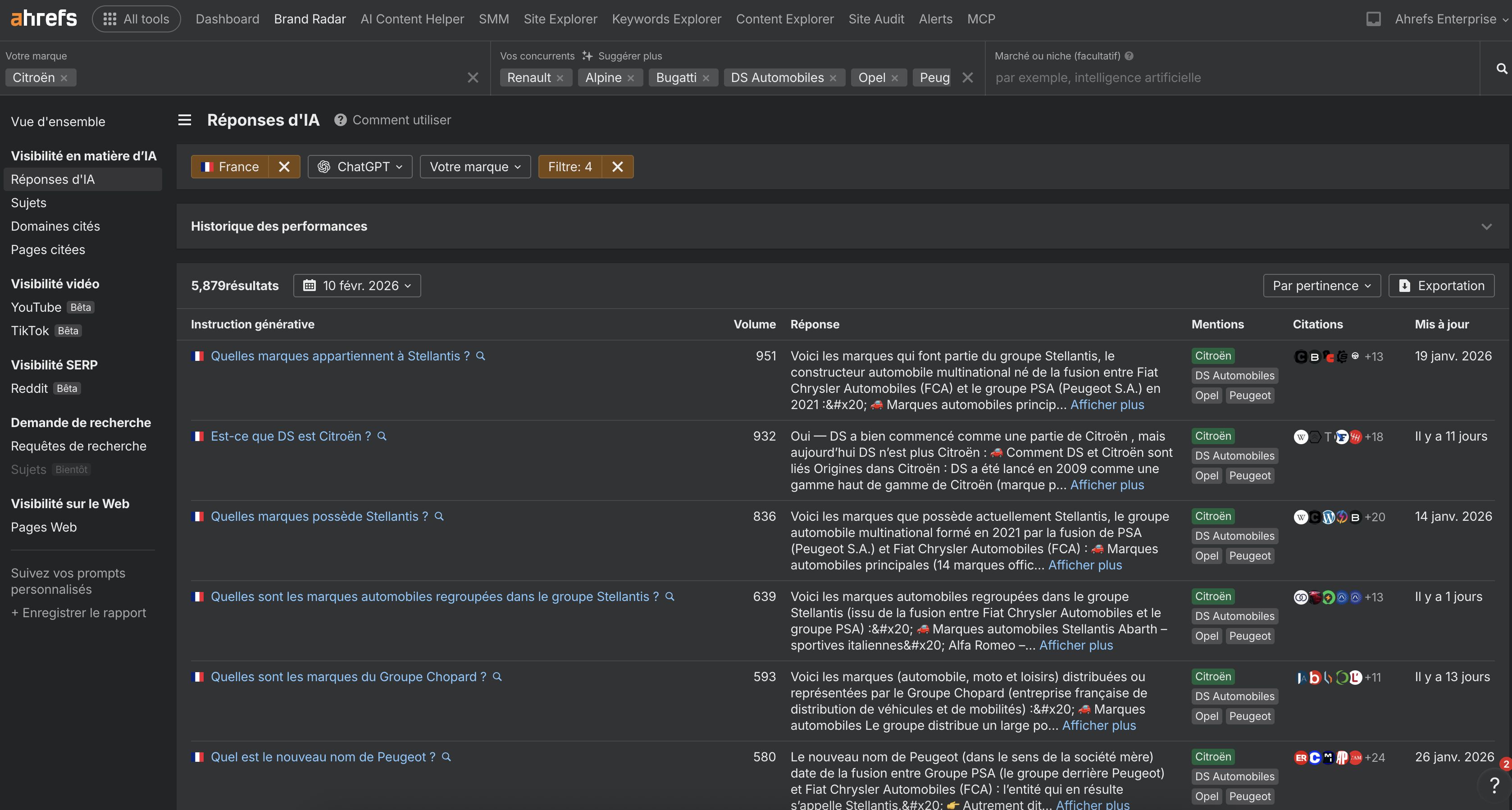

Vous pouvez identifier des idées de mots-clés de longue traîne en réalisant une analyse de gap concurrentiel dans Brand Radar d’Ahrefs.

Vous avez ainsi accès aux prompts pour lesquels vos concurrents sont visibles, mais pas vous. Autrement dit, votre « AI prompt gap ».

Ajoutez votre marque et celles de vos concurrents, survolez un assistant IA comme ChatGPT, puis cliquez sur « Autres uniquement ».

Analysez ensuite les prompts qui remontent afin d’identifier des idées de contenus de longue traîne.

Selon une hypothèse formulée par Nathan Gotch, les filtres de requêtes dans la Google Search Console contenant /overview ou /search permettent d’identifier des mots-clés de longue traîne utilisés par les internautes en mode IA. Il s’agit donc d’une autre source potentielle d’idées de contenus de longue traîne.

Créer du contenu pour répondre à des mots-clés de longue traîne est une approche pertinente. Mais ce qui est encore plus important, c’est de construire des clusters de contenus qui couvrent toutes les facettes d’un sujet, et pas uniquement des requêtes isolées.

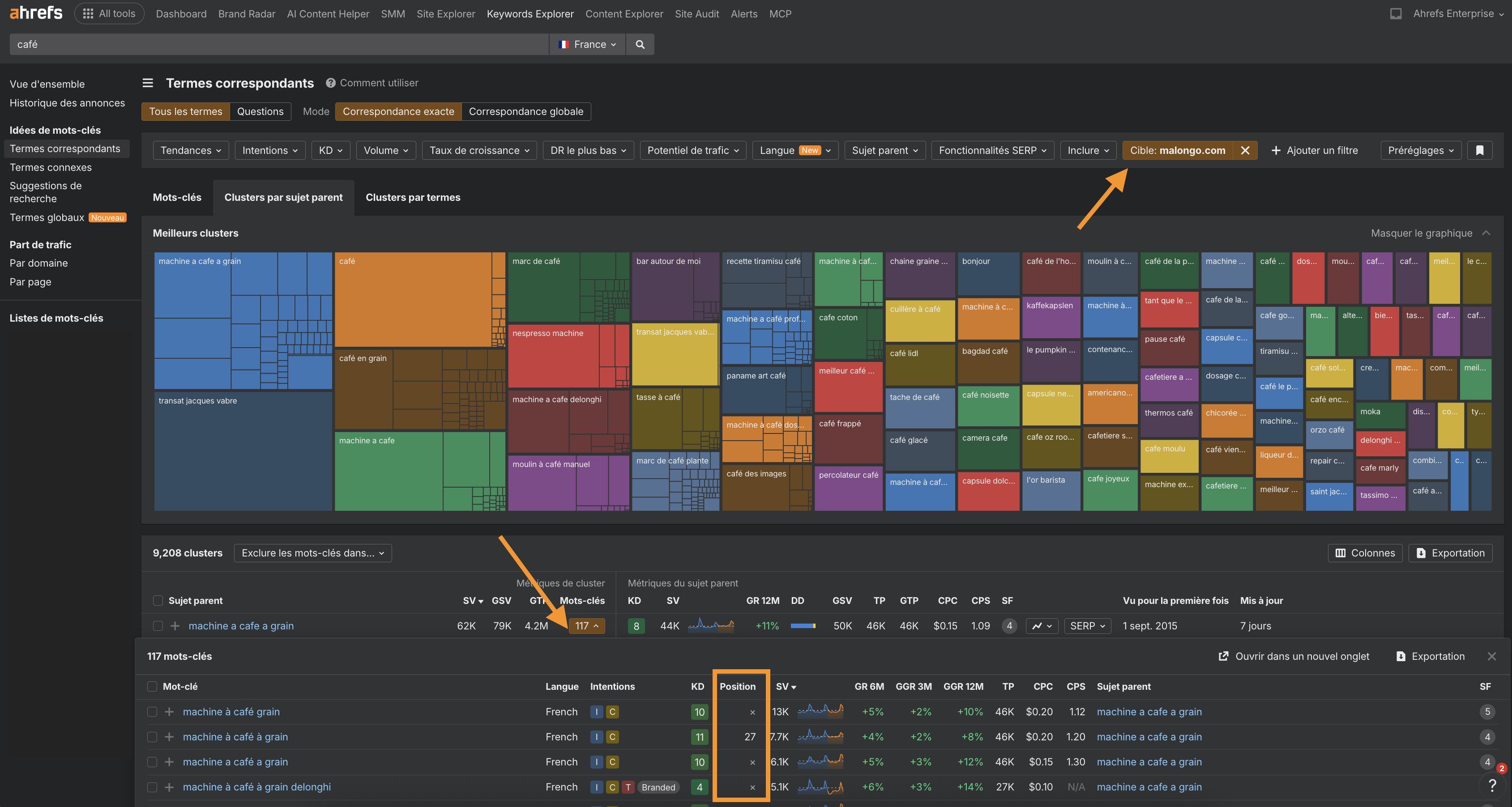

Pour cela, vous pouvez utiliser des outils comme Also Asked ou les Parent Topics dans Keywords Explorer d’Ahrefs.

Il vous suffit de rechercher un mot-clé, puis d’accéder au rapport Termes Correspondants et de consulter l’onglet Clusters par sujets parents.

Ensuite, rendez-vous dans l’onglet Questions pour identifier des requêtes de longue traîne déjà regroupées en clusters, à cibler dans vos contenus…

Pour évaluer le niveau de couverture que vous avez déjà sur les différentes variations de requêtes de longue traîne existantes, ajoutez un filtre Cible correspondant à votre domaine.

Les cocons de contenus ne sont pas nouveaux. Mais les données indiquent qu’ils jouent un rôle encore plus important dans la recherche LLM.

Tous les problèmes que Google n’a pas su résoudre sont désormais confiés à l’IA.

La recherche LLM est capable de gérer des tâches en plusieurs étapes, des contenus multimodaux et du raisonnement, ce qui en fait un outil particulièrement puissant pour l’assistance à l’exécution de tâches.

En revenant à l’étude sur ChatGPT mentionnée précédemment, Metehan Yeşilyurt a constaté que 75% of AI prompts sont des commandes, et non des questions.

Cela indique qu’un nombre important d’utilisateurs se tournent vers l’IA pour accomplir des tâches concrètes.

En réponse, vous pouvez commencer à travailler sur une cartographie des actions. Il s’agit d’identifier l’ensemble des tâches que vos clients souhaitent accomplir et qui peuvent, d’une manière ou d’une autre, impliquer votre marque ou vos produits.

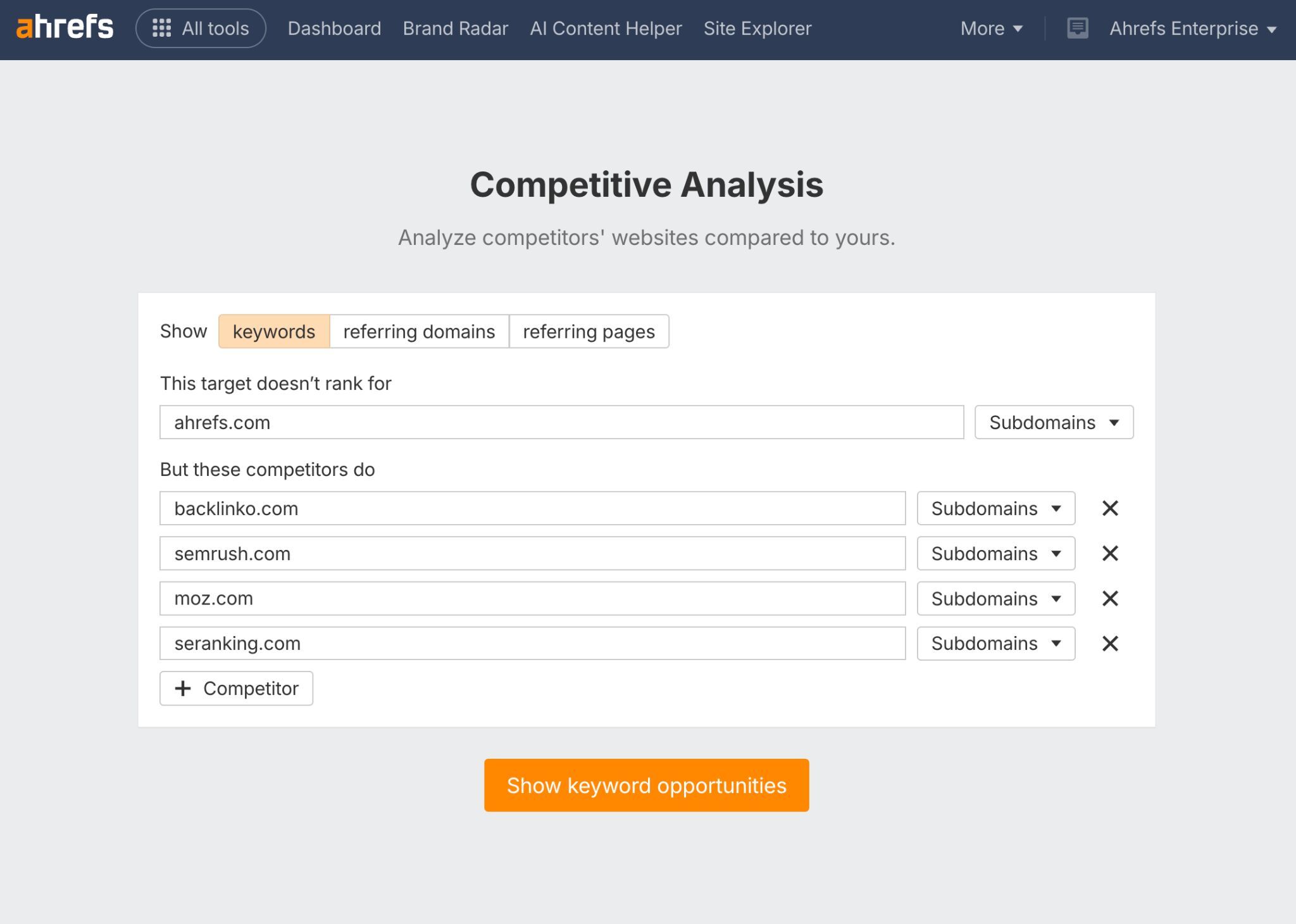

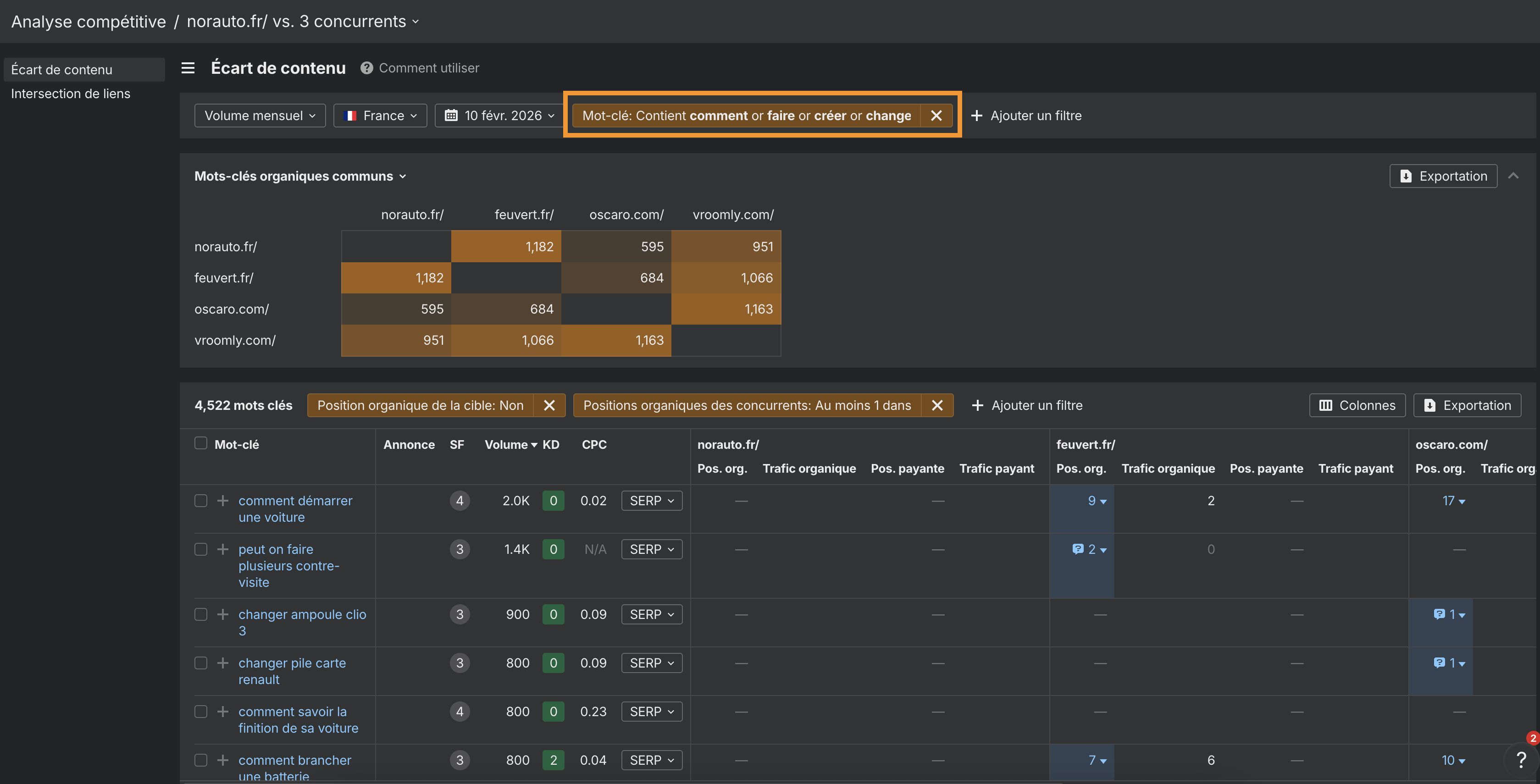

Pour cartographier ces tâches clients, rendez-vous dans l’Analyse compétitive d’Ahrefs et configurez une analyse afin d’identifier les zones où vos concurrents sont visibles, mais pas vous.

Puis filtrez par des verbes d’action logiques pour votre marché (ex. “faire”, “suivre”, “créer”, “générer”) et des pronoms relatifs interrogatifs et des verbes d’action (on fait appel à de vieux souvenirs là!) (ex. “Comment faire” ou “Comment créer” ).

Une fois que vous avez identifié les actions clés que votre audience souhaite réaliser, créez du contenu pour accompagner ces jobs-to-be-done.

Nous avons analysé 17 millions de citations sur 7 plateformes de recherche IA et constaté que les assistants IA privilégient les contenus plus récents.

Les contenus cités par l’IA sont en moyenne 25,7 % plus récents que ceux présents dans les SERP organiques, et les assistants IA affichent une préférence de 13,1 % pour les contenus mis à jour plus récemment.

ChatGPT et Perplexity, en particulier, priorisent les pages récentes et ont tendance à classer leurs citations de la plus récente à la plus ancienne.

Pourquoi la fraîcheur est-elle si importante ? Parce que la RAG, ou génération augmentée par récupération, s’active généralement lorsqu’une requête nécessite des informations récentes.

Si le modèle « connaît » déjà la réponse à partir de ses données d’entraînement, il n’a pas besoin de rechercher.

En revanche, lorsqu’il ne la connaît pas, il va chercher les informations les plus récentes disponibles, en particulier sur des sujets émergents.

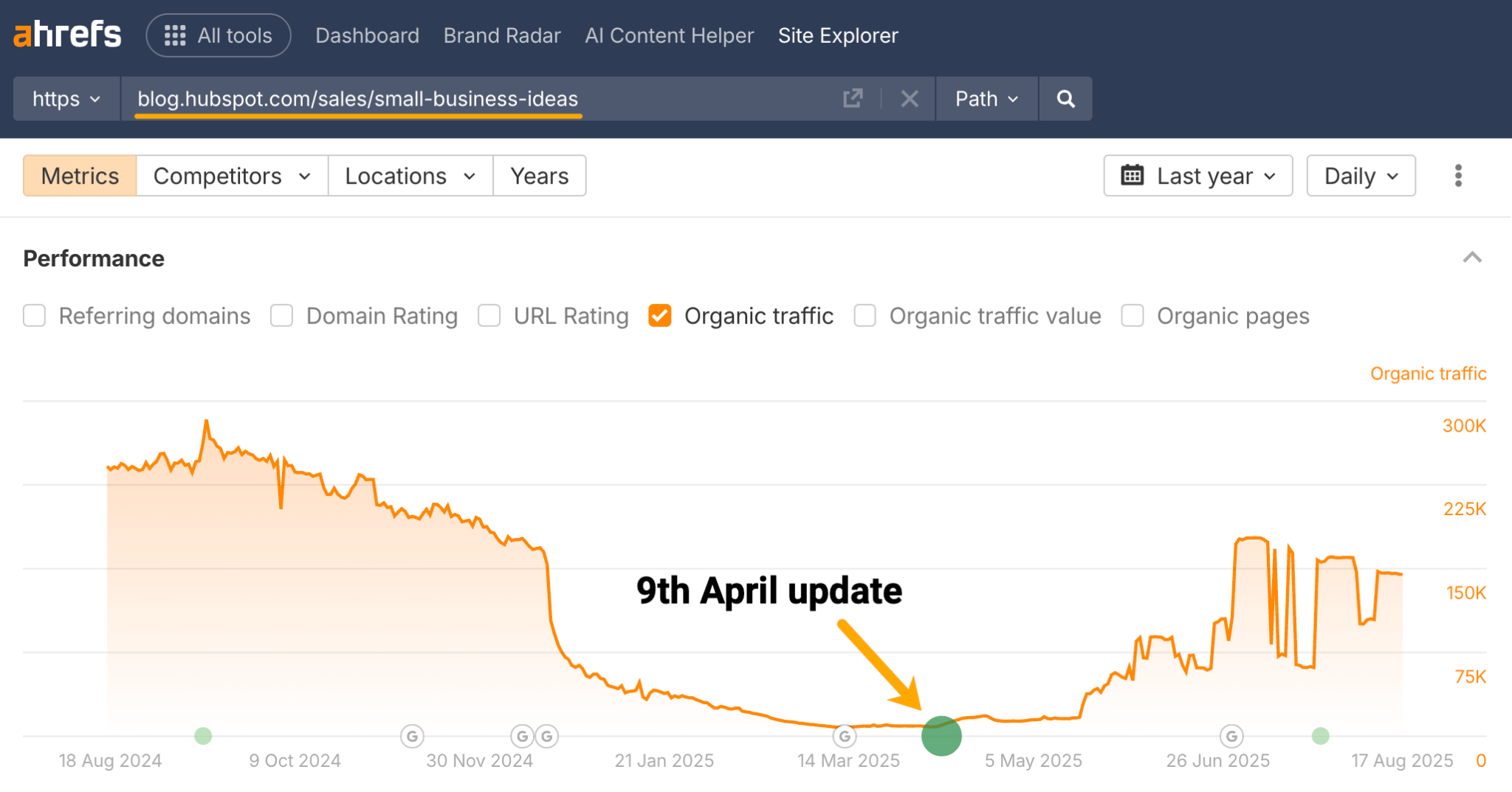

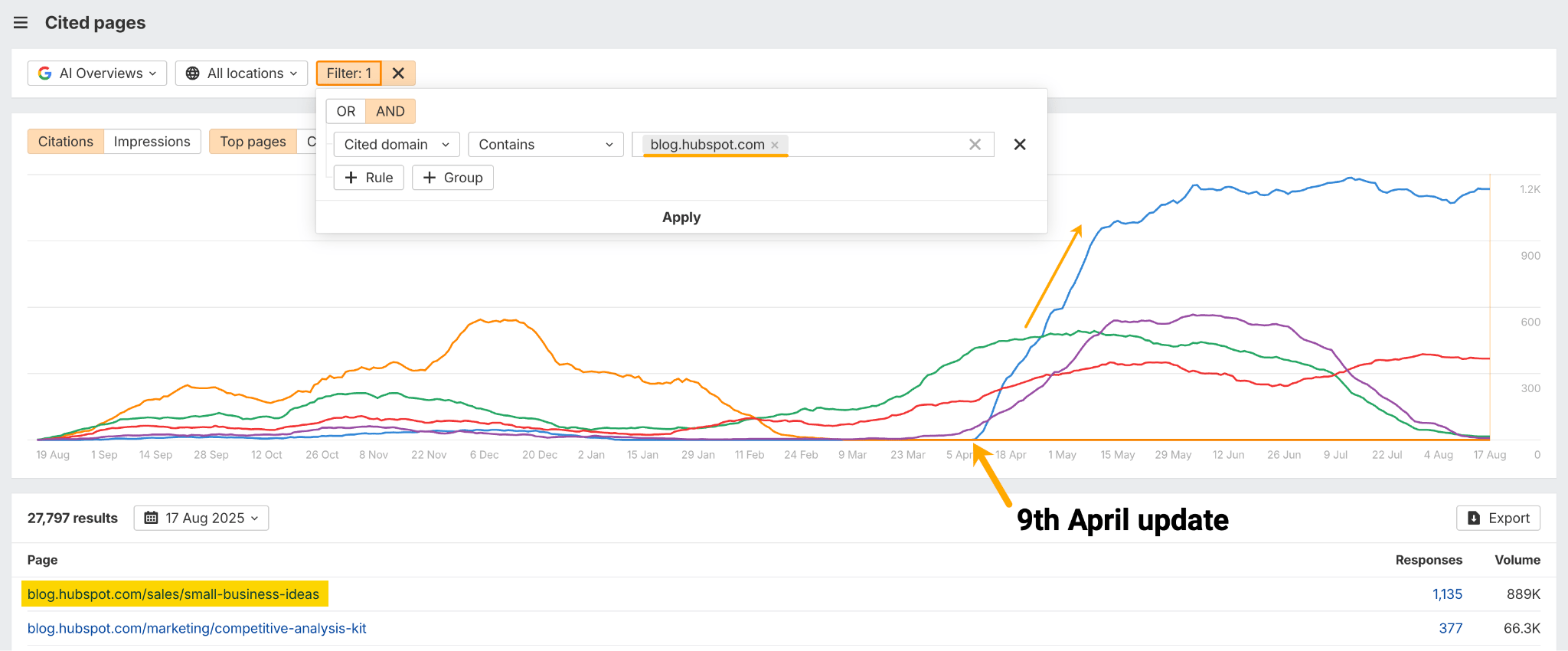

Dans l’exemple ci-dessous, HubSpot a mis à jour un article de blog sur les « small business ideas » le 9 avril, d’après les données Content Changes dans Site Explorer d’Ahrefs.

Selon Brand Radar d’Ahrefs, cet article est désormais leur article de blog le plus cité dans les AI Overviews.

Cette seule mise à jour de contenu a généré 1 135 nouvelles mentions dans les AI Overviews.

Nos recherches indiquent que maintenir votre contenu à jour peut renforcer son attractivité auprès des moteurs d’IA qui cherchent des informations récentes.

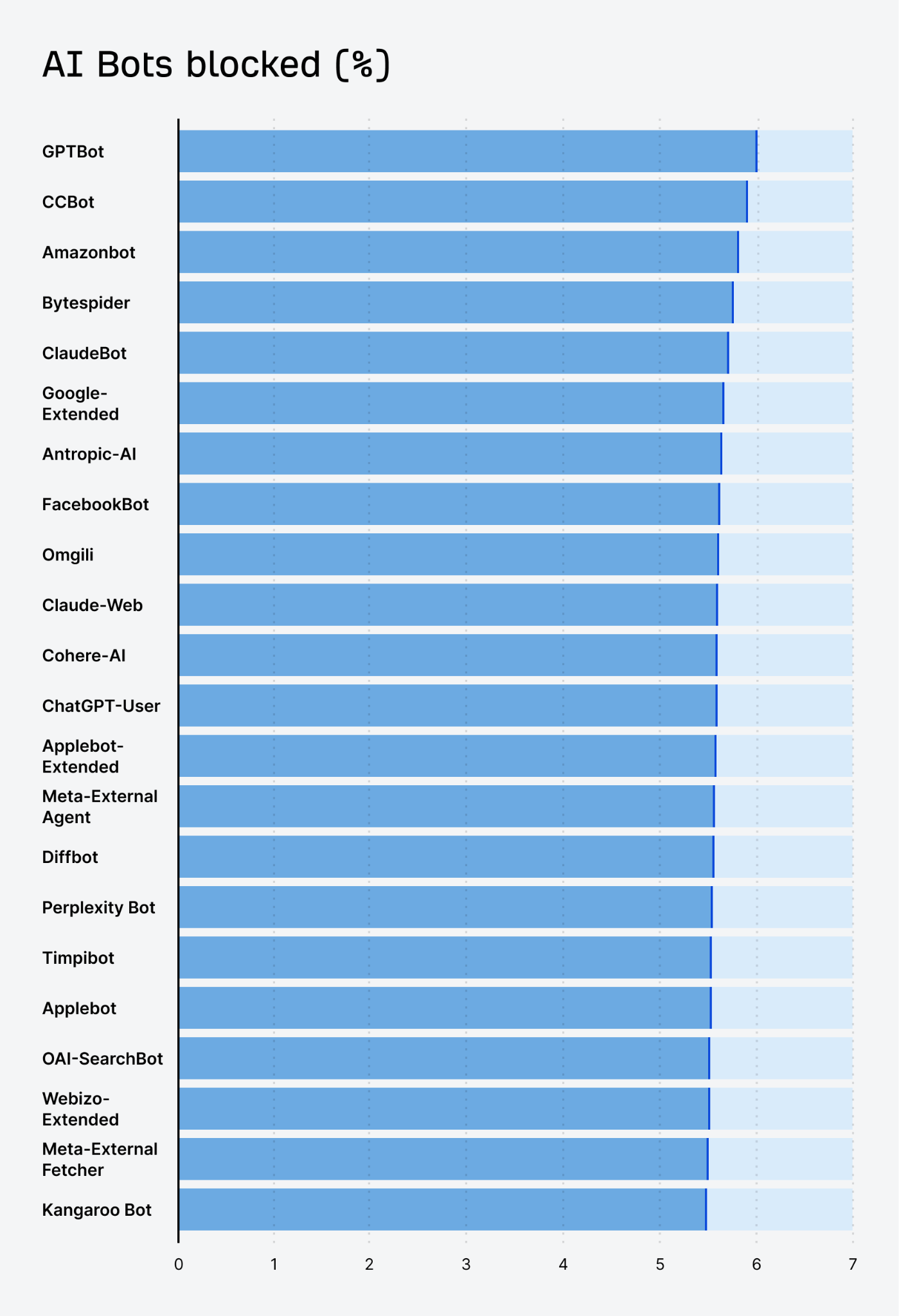

Pour que votre contenu puisse être cité dans des réponses générées par l’IA, vous devez autoriser les bots IA à le crawler.

Un nombre croissant de sites ont commencé à bloquer les scrapers IA.

D’après nos propres recherches, environ 5,9 % de l’ensemble des sites web interdisent l’accès au GPTBot d’OpenAI, en raison de préoccupations liées à l’utilisation des données ou à la consommation de ressources.

Même si cette décision peut se comprendre, le blocage peut également signifier renoncer à une visibilité IA future.

Si votre objectif est que ChatGPT, Perplexity, Gemini et d’autres assistants IA mentionnent votre marque, vérifiez attentivement vos règles robots.txt et votre pare-feu afin de vous assurer que vous ne bloquez pas involontairement les principaux crawlers IA.

Assurez-vous d’autoriser les bots légitimes à indexer vos pages.

De cette manière, votre contenu pourra être intégré aux données d’entraînement ou de navigation en temps réel sur lesquelles s’appuient les assistants IA, vous donnant ainsi une chance d’être cité lorsque des requêtes pertinentes apparaissent.

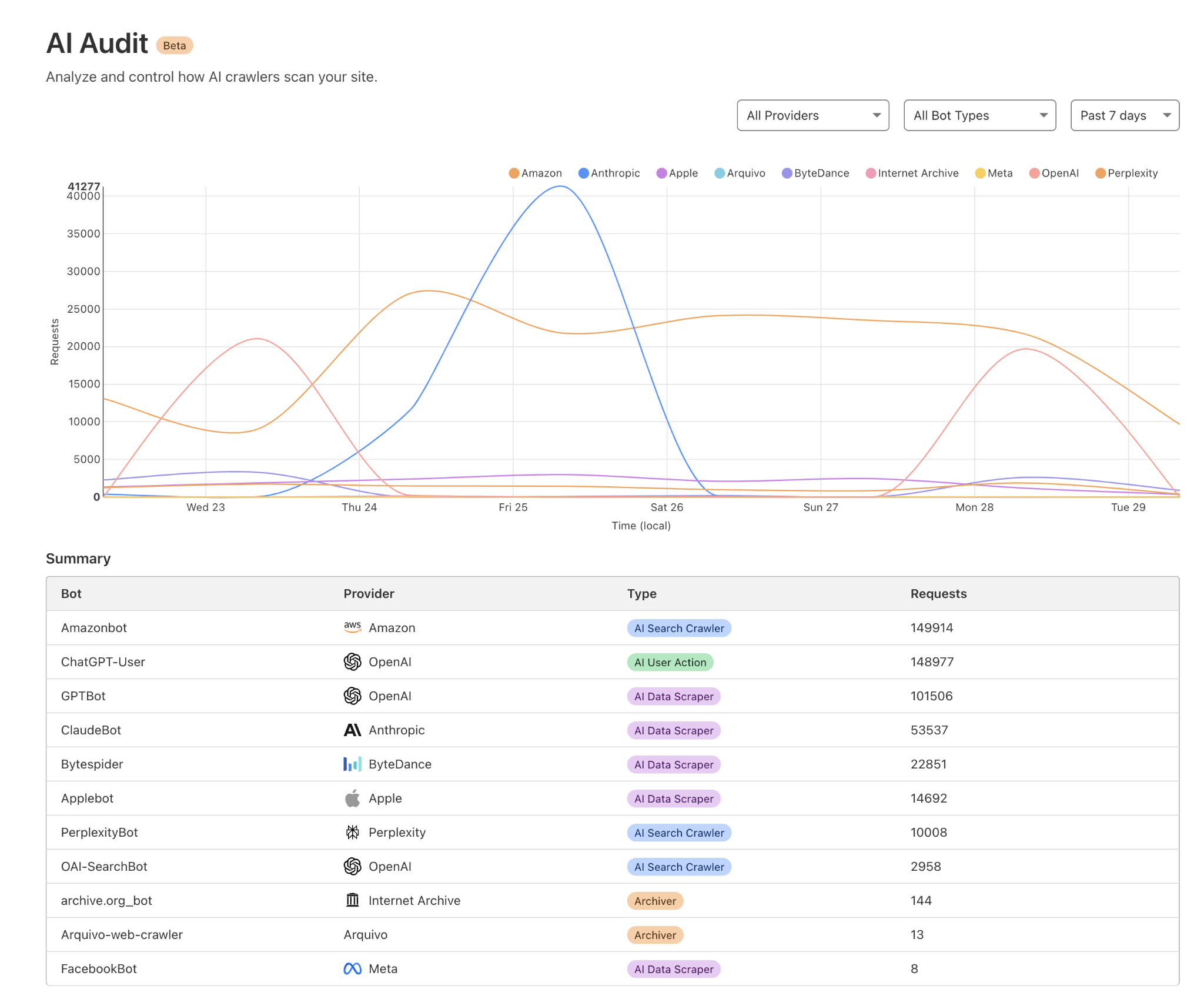

Vous pouvez vérifier quels bots IA accèdent à votre site en analysant vos logs serveur ou en utilisant un outil comme Cloudflare AI audit.

Les domaines les plus cités varient fortement d’une interface de recherche LLM à l’autre. Être très visible sur l’une d’entre elles ne garantit en rien une présence sur les autres.

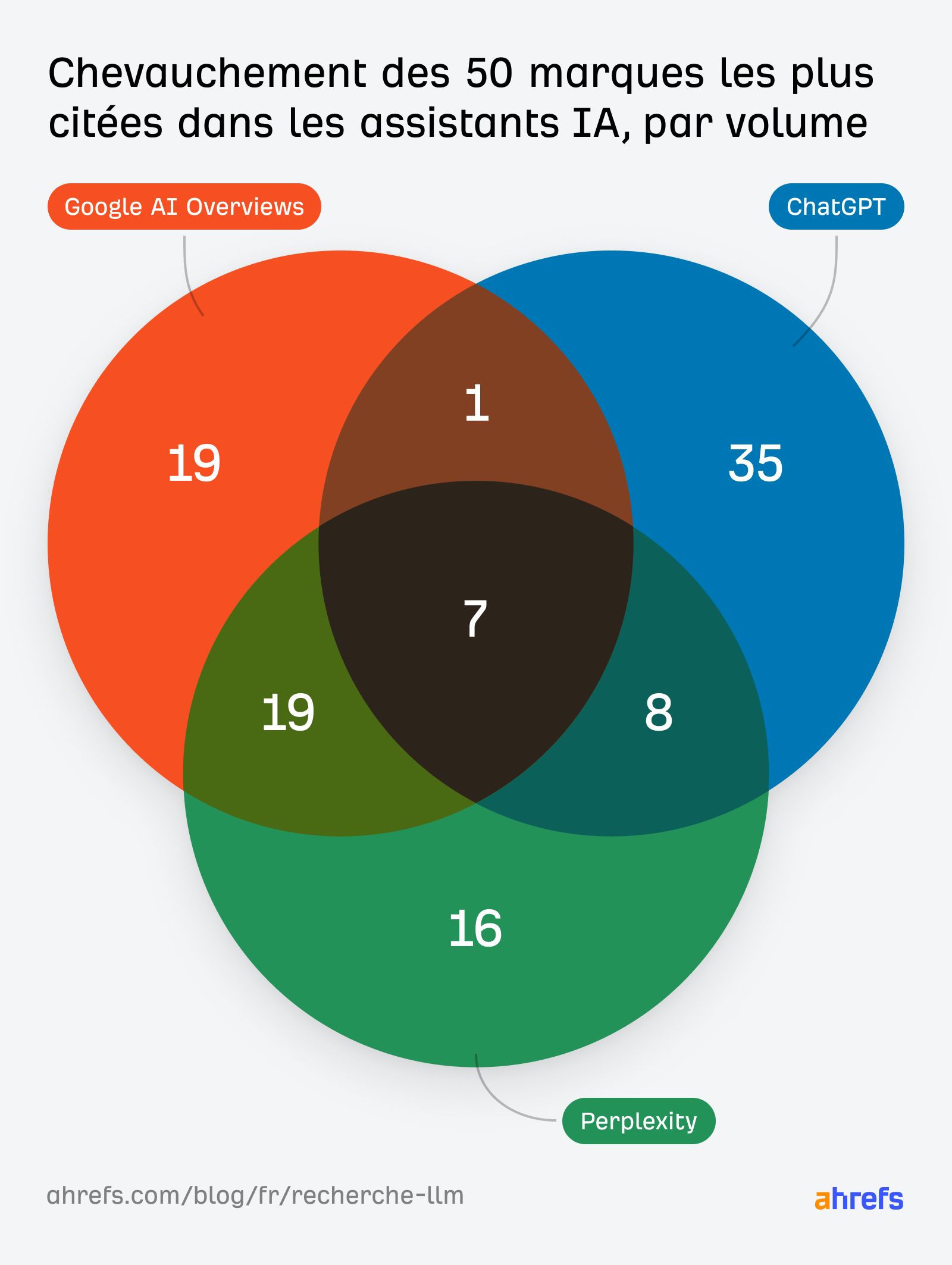

En réalité, parmi les 50 domaines les plus mentionnés dans ChatGPT et Perplexity, nous avons constaté que seuls 7 domaines apparaissent dans les deux listes.

Cela signifie que pas moins de 86 % des sources étaient propres à chaque assistant.

- Google s’appuie fortement sur son propre écosystème, comme YouTube, ainsi que sur les contenus générés par les utilisateurs, en particulier les communautés telles que Reddit et Quora.

- ChatGPT privilégie les éditeurs et les partenariats médias, notamment les médias d’actualité comme Reuters et l’AP, plutôt que Reddit ou Quora.

- Perplexity met en avant une grande diversité de sources, en particulier des sites globaux ou de niche, par exemple des sites spécialisés dans la santé ou spécifiques à certaines régions, comme tuasaude ou alodokter.

Il n’existe pas de stratégie de citation universelle. Chaque assistant IA met en avant des contenus issus de sites différents.

Si vous optimisez uniquement pour les classements Google, vous pouvez très bien dominer les AI Overviews tout en ayant une visibilité plus limitée dans ChatGPT.

À l’inverse, si votre marque est reprise par des médias ou des sites d’actualité, elle peut apparaître dans les réponses de ChatGPT, même si ses positions sur Google sont moins performantes.

Autrement dit, il est pertinent de tester des stratégies distinctes selon les LLM.

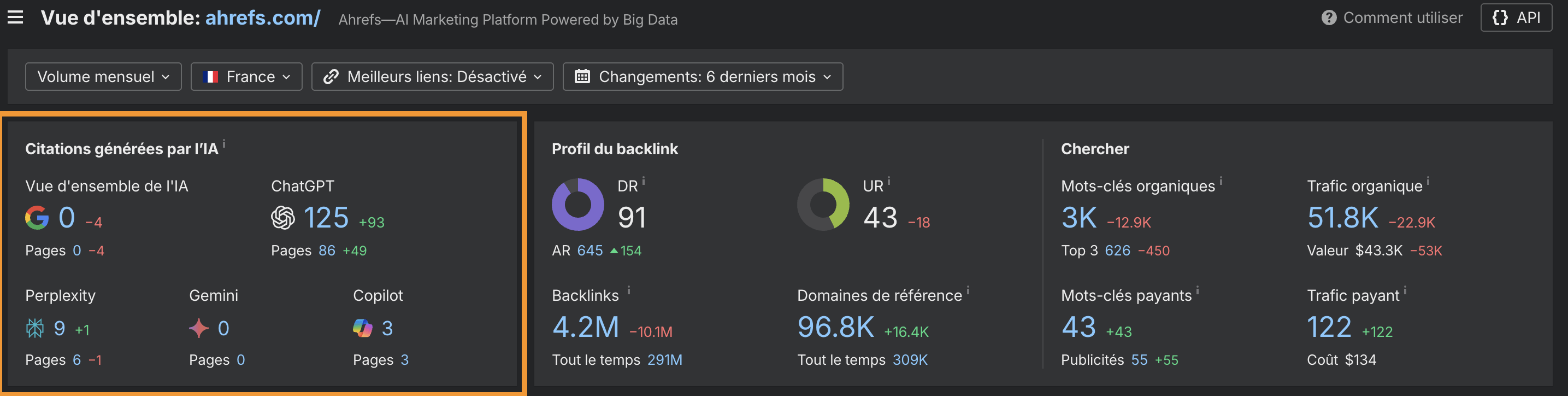

Vous pouvez utiliser Ahrefs pour analyser la visibilité de votre marque sur Perplexity, ChatGPT, Gemini et les fonctionnalités de recherche IA de Google.

Il vous suffit de saisir votre domaine dans Site Explorer et de consulter le nombre total de citations IA dans le rapport Vue d’ensemble.

Si vous n’avez pas une licence payante à Ahrefs, vous pouvez également le voir de manière gratuite ici :

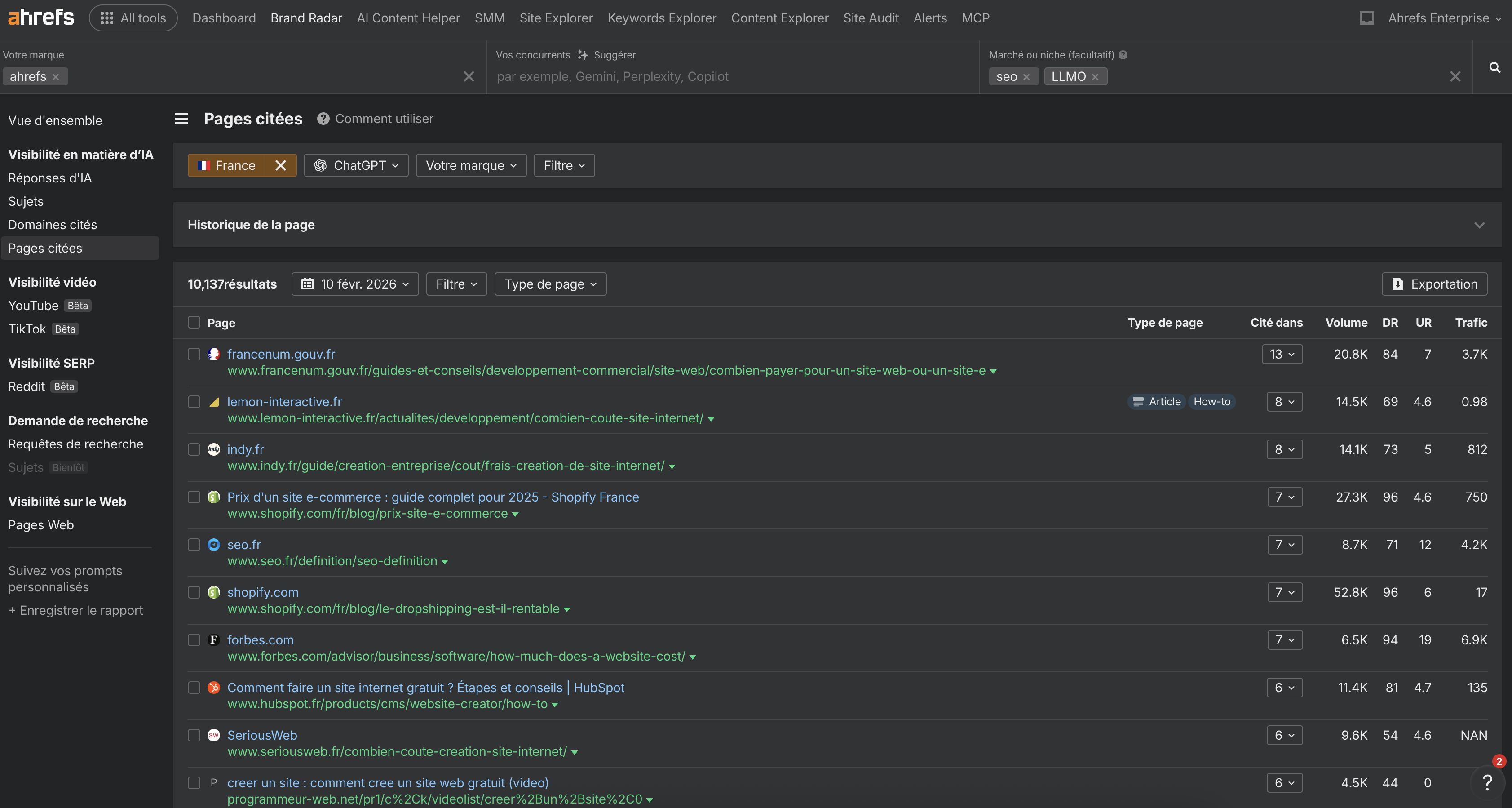

Ensuite, approfondissez l’analyse dans le rapport Pages Citées de Brand Radar.

Vous pouvez étudier les différents sites et formats de contenu privilégiés par chaque assistant IA.

Par exemple, les mentions d’Ahrefs de ChatGPT proviennent de site autour de la création de sites web.

Dernières réflexions

Une grande partie de ces recommandations peut vous sembler familière, et c’est normal. Il s’agit en grande partie de SEO et de marketing de marque.

Les mêmes facteurs qui influencent le SEO, à savoir l’autorité, la pertinence, la fraîcheur et l’accessibilité, sont aussi ceux qui rendent les marques visibles pour les assistants IA.

De nombreux développements récents le confirment. ChatGPT a récemment été épinglé pour avoir scrappé les résultats de recherche de Google. GPT-5 s’appuie fortement sur la recherche plutôt que sur des connaissances stockées. Et les LLM achètent des données issues du graphe de liens des moteurs de recherche afin de pondérer et de prioriser leurs réponses.

À ce titre, le SEO est loin d’être mort.

Au contraire, il assume une part essentielle du travail. La leçon à retenir est donc la suivante :

- Redoublez d’efforts sur les pratiques éprouvées de SEO et de construction de marque si vous souhaitez également gagner en visibilité IA.

- Générez des mentions de marque de qualité

- créez des contenus structurés et pertinents

- maintenez-les à jour

- assurez-vous qu’ils puissent être crawlés.

À mesure que la recherche LLM arrive à maturité, nous sommes convaincus que ces principes fondamentaux continueront de vous assurer une visibilité durable.