Si quieres tener alguna posibilidad de visibilidad en la búsqueda con LLM, necesitas entender cómo hacer que tu marca sea visible en las respuestas de la IA.

La última oleada de expertos afirma conocer el “secreto” de la visibilidad en la IA, pero la realidad es que todos seguimos descifrándolo sobre la marcha.

Esto es lo que sabemos hasta ahora, basándonos en la investigación y experimentación continuas.

Si lo prefieres, aquí te dejamos la versión en vídeo sobre cómo optimizar tu contenido para LLMs.

La búsqueda con LLM se refiere a cómo los modelos grandes de lenguaje recopilan y entregan información a los usuarios, ya sea a través de los AI Overviews de Google, ChatGPT o Perplexity.

Mientras que los motores de búsqueda te ofrecen una lista de opciones, un LLM va directamente a producir una respuesta en lenguaje natural.

A veces esa respuesta se basa en lo que el modelo ya sabe, otras veces se apoya en fuentes externas de información como resultados web actualizados.

Ese segundo caso es lo que llamamos búsqueda con LLM: cuando el modelo busca activamente nueva información, a menudo de páginas web cacheadas o índices de búsqueda en tiempo real, utilizando un proceso conocido como generación aumentada por recuperación (retrieval-augmented generation o RAG, por sus siglas en inglés).

Al igual que la búsqueda tradicional, la búsqueda con LLM se está convirtiendo en un ecosistema por derecho propio, solo que el objetivo final es un poco diferente.

La búsqueda tradicional consistía en posicionar páginas web más alto en los resultados de búsqueda.

La búsqueda con LLM consiste en asegurar que tu marca y contenido sean descubribes y extraíbles en las respuestas generadas por IA.

| Característica | Búsqueda tradicional | Búsqueda con LLM |

|---|---|---|

| Objetivo principal | Ayudar a la gente a encontrar las páginas web más relevantes. | Dar a la gente una respuesta directa en lenguaje natural, respaldada por fuentes relevantes. |

| Respuestas que obtienes | Una lista de enlaces, fragmentos, anuncios y, a veces, paneles con datos rápidos. | Una respuesta escrita, a menudo con explicaciones breves o algunas fuentes citadas/mencionadas. |

| De dónde vienen las respuestas | Un índice de la web constantemente actualizado. | Una mezcla de los datos de entrenamiento del modelo e información recuperada de los motores de búsqueda. |

| Cuán actualizada está | Muy actualizada: se rastrean e indexan nuevas páginas todo el tiempo. | No tan actualizada: recupera versiones cacheadas de páginas web, pero mayormente actuales. |

| Composición de la consulta | Consultas de palabras clave de cola corta y con intención ambigua. | Consultas conversacionales de cola ultra larga. |

| Qué pasa con el tráfico | Dirige a los usuarios hacia los sitios web, generando clics. | La intención a menudo se satisface dentro de la respuesta, lo que significa menos clics. |

| Formas de influir | Mejores prácticas de SEO: palabras clave, backlinks, velocidad del sitio, datos estructurados, etc. | Ser una fuente de confianza que el modelo podría citar: menciones y enlaces de sitios de autoridad, contenido actualizado, bien estructurado y accesible, etc. |

Las compañías de IA no revelan cómo los LLM seleccionan las fuentes, por lo que es difícil saber cómo influir en sus resultados.

Esto es lo que hemos aprendido sobre la optimización para LLM hasta ahora, basándonos en estudios de búsqueda con LLM propios y de terceros.

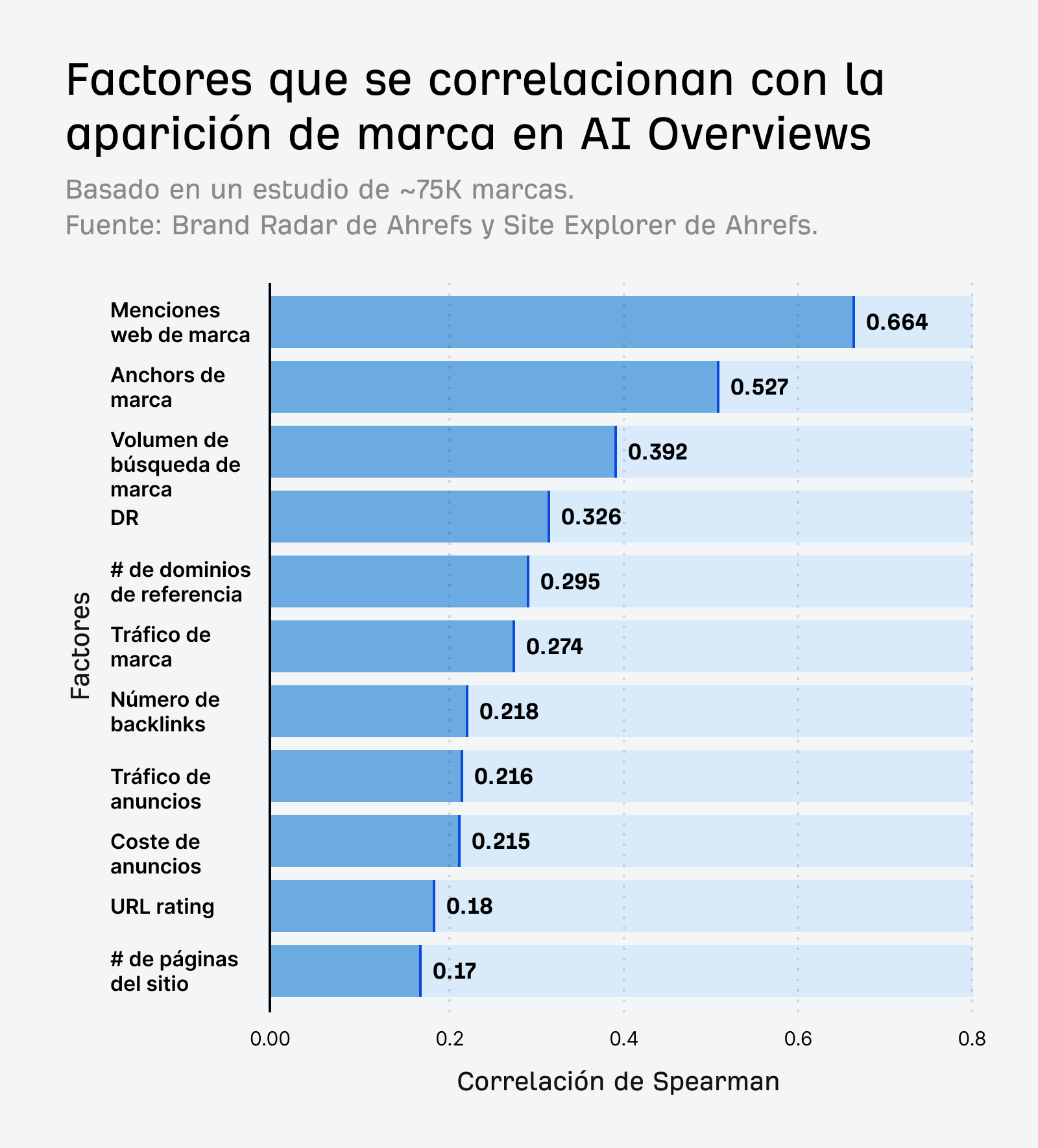

Estudiamos 75.000 marcas a través de millones de AI Overviews y descubrimos que las menciones de marca en la web tenían la correlación más fuerte con las menciones de marca en los AI Overviews.

Más menciones de marca significan más ejemplos de entrenamiento para que un LLM aprenda.

El LLM “ve” eficazmente esas marcas más veces durante el entrenamiento y puede asociarlas mejor con temas relevantes.

Pero eso no significa que debas ir persiguiendo menciones por el simple hecho de tenerlas. En lugar de eso, céntrate en construir una marca que merezca ser mencionada.

La calidad importa más que la cantidad.

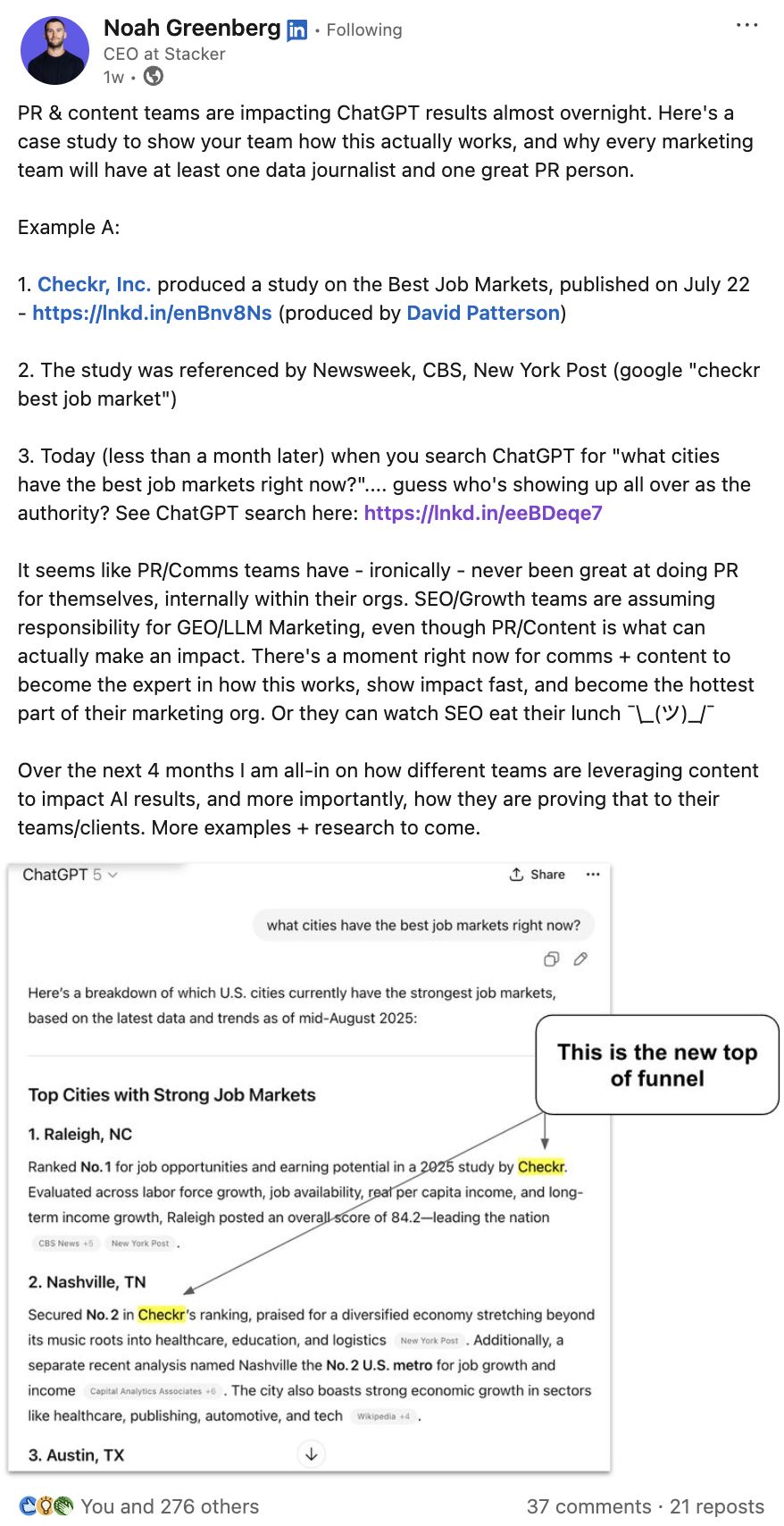

Aquí tienes una prueba. Checkr, Inc hizo un estudio sobre los mejores mercados laborales, que fue recogido por no más de un puñado de publicaciones con autoridad, incluyendo Newsweek y CNBC.

Sin embargo, en menos de un mes, Checkr estaba siendo mencionada de forma consistente en conversaciones de IA relevantes.

Verifiqué esto en diferentes perfiles de ChatGPT para tener en cuenta la variación por personalización, y Checkr fue mencionada todas las veces.

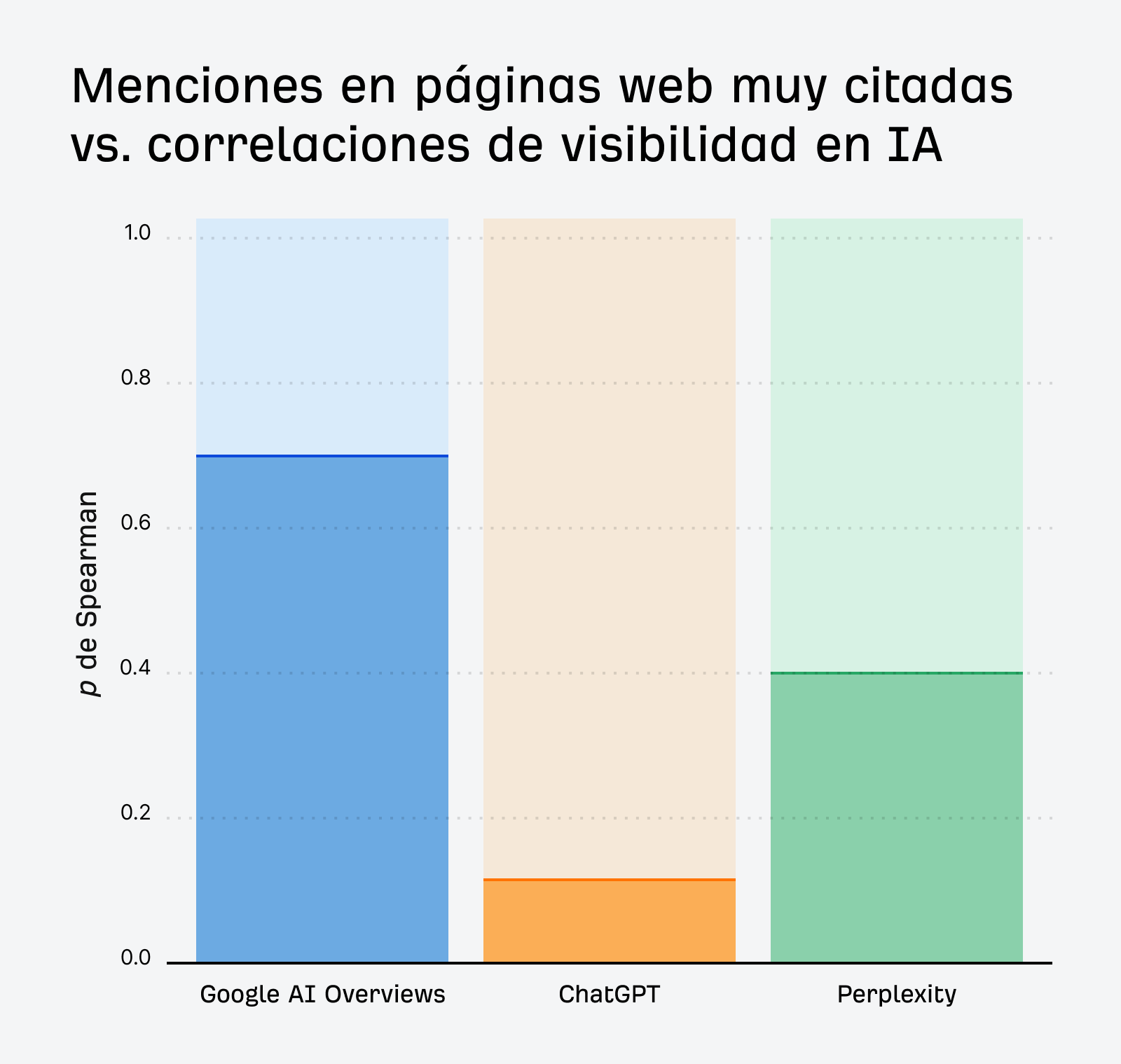

Según la investigación del Asesor de Producto de Ahrefs, Patrick Stox, conseguir apariciones en páginas con alta autoridad o alto tráfico potenciará tu visibilidad en la IA.

Las menciones en los AI Overviews de Google se correlacionan fuertemente con las menciones de marca en páginas muy enlazadas (ρ ~0,70), y vemos un efecto similar para las marcas que aparecen en páginas de alto tráfico (ρ ~0,55).

Es solo cuestión de tiempo que los asistentes de IA comiencen a evaluar dimensiones cualitativas como el sentimiento.

Cuando eso suceda, las asociaciones positivas y la autoridad duradera se convertirán en los verdaderos diferenciadores en la búsqueda con LLM.

Céntrate en construir notoriedad de calidad a través de:

Relaciones públicas y colaboraciones de contenido

Para una visibilidad sostenida en la IA, colabora con fuentes y marcas de confianza. Esto te ayudará a construir esas asociaciones de calidad.

En Ahrefs no es ningún secreto que nosotros, como muchos, estamos tratando de potenciar nuestra autoridad en temas de IA.

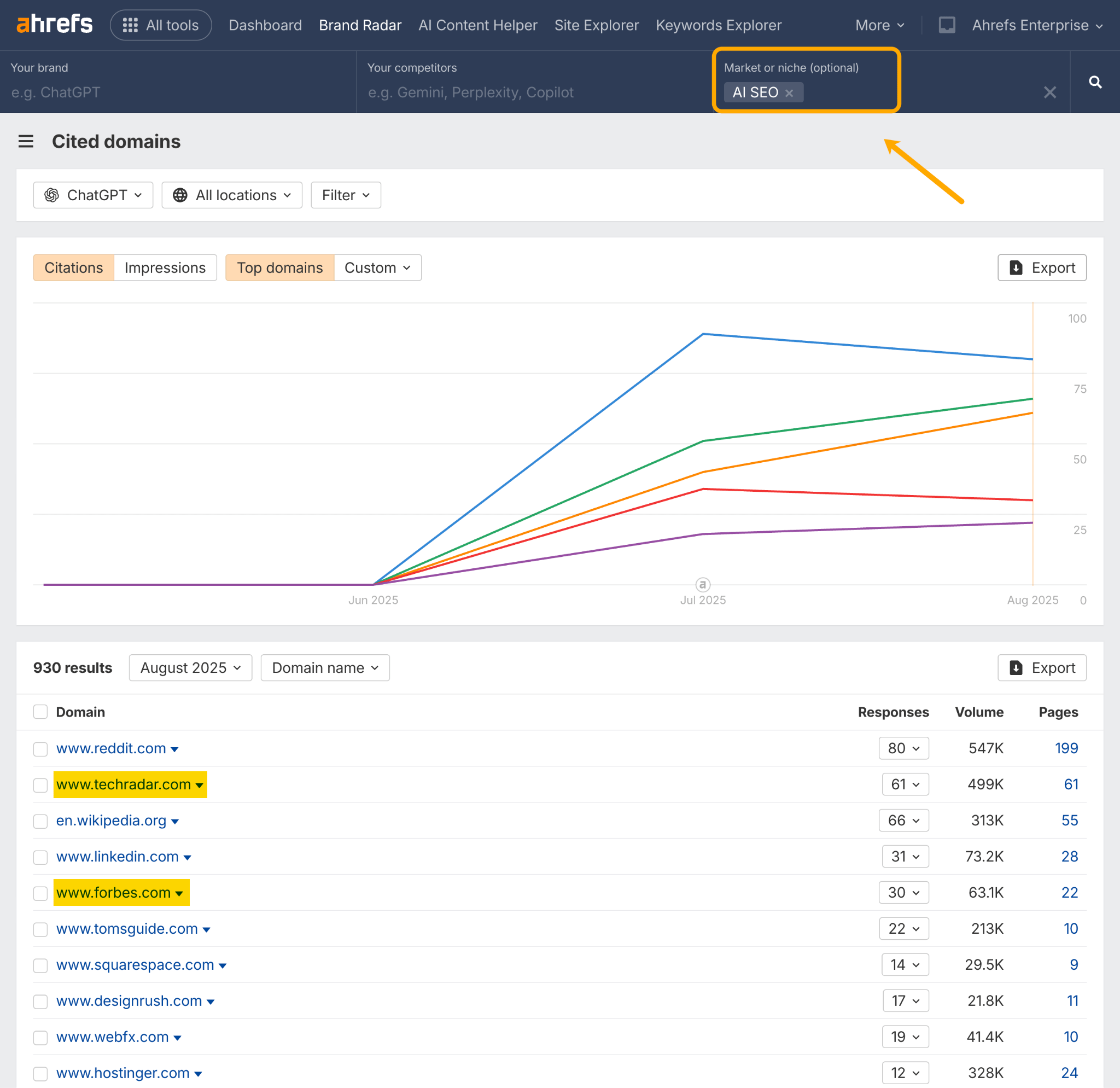

Para encontrar oportunidades de colaboración, podemos ir a Brand Radar de Ahrefs y usar el informe de Dominios Citados.

En este ejemplo, he establecido mi nicho en “SEO con IA” y estoy mirando los dominios más citados en ChatGPT.

Hay dos publicaciones con autoridad que podrían estar abiertas a una propuesta de relaciones públicas: Tech Radar y Forbes.

Puedes repetir este análisis para tu propio mercado. Mira qué sitios aparecen consistentemente en múltiples nichos y desarrolla colaboraciones continuas con los más visibles.

Reseñas y creación de comunidad

Para generar menciones positivas, fomenta la discusión genuina y el boca a boca de los usuarios.

Hacemos esto constantemente en Ahrefs. Nuestro CMO, Tim Soulo, publica contenido para recibir feedback en redes sociales. Nuestro Asesor de Producto, Patrick Stox, contribuye regularmente a discusiones en Reddit. Y dirigimos a todos nuestros usuarios a nuestro sitio de feedback de clientes donde pueden discutir, solicitar y votar por nuevas funcionalidades.

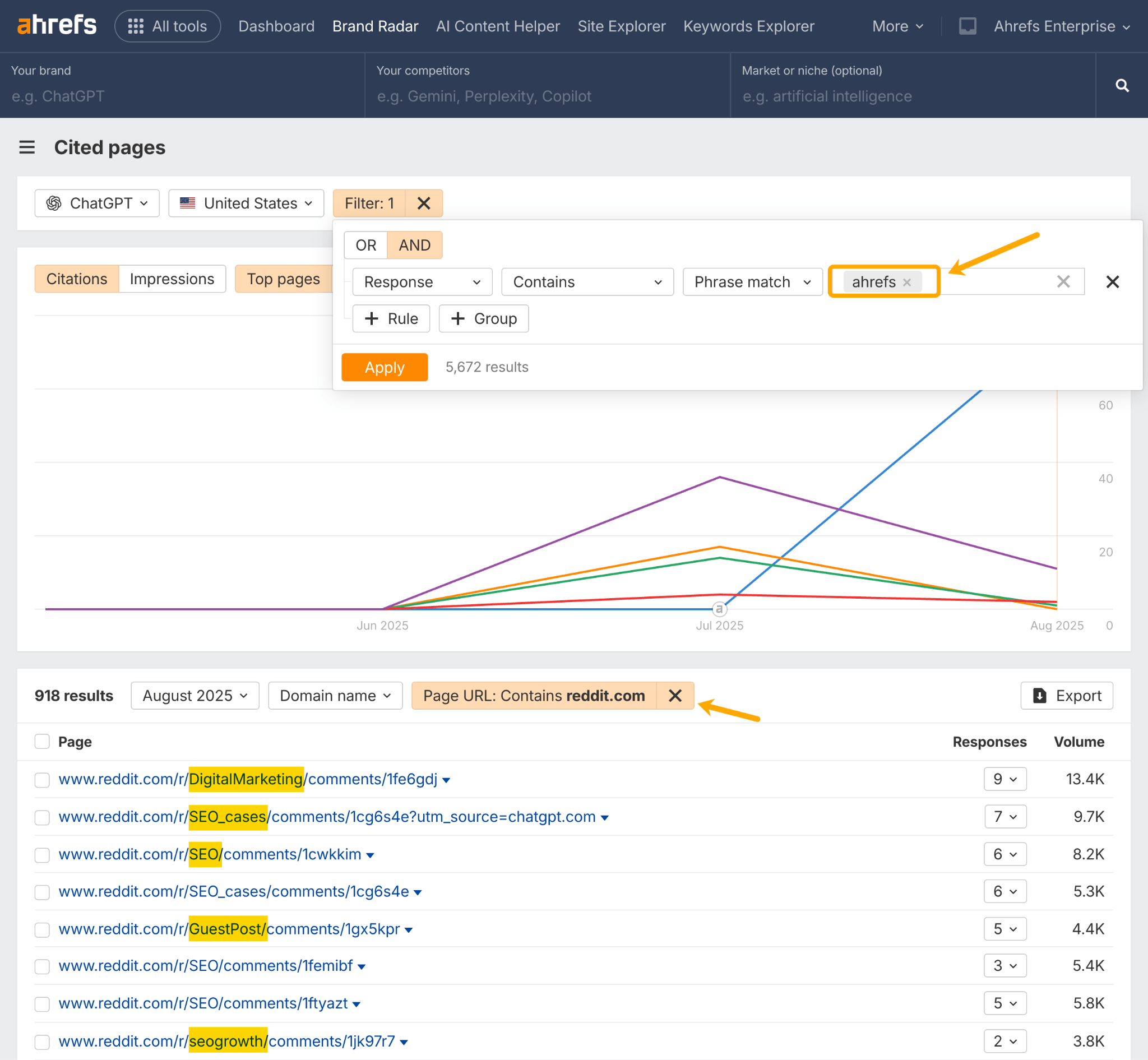

Puedes usar Brand Radar de Ahrefs para empezar con tu propia estrategia de comunidad. Ve al informe de Páginas citadas, introduce tu dominio y comprueba qué discusiones de contenido generado por usuarios (UGC) están apareciendo en la IA relacionadas con tu marca.

En este ejemplo, he tomado nota de los subreddits que mencionan regularmente a Ahrefs.

Una táctica que podríamos adoptar aquí es construir una mayor presencia en esas comunidades.

Mi compañero, SQ, escribió una gran guía sobre cómo aparecer de forma auténtica en Reddit como marca. Tiene un par de años, pero todos los consejos siguen siendo válidos. ¡Te recomiendo leerla!

Mensajes de marca

Cuando aciertas con tus mensajes, le das a la gente el lenguaje adecuado para describir tu marca, lo que crea más notoriedad.

Cuanto más se repite el mensaje, más espacio ocupa en la mente del cliente y en la búsqueda con LLM.

Esto te da una mayor “cuota de memoria”.

Puedes medir el impacto de tus mensajes de marca rastreando tus co-menciones.

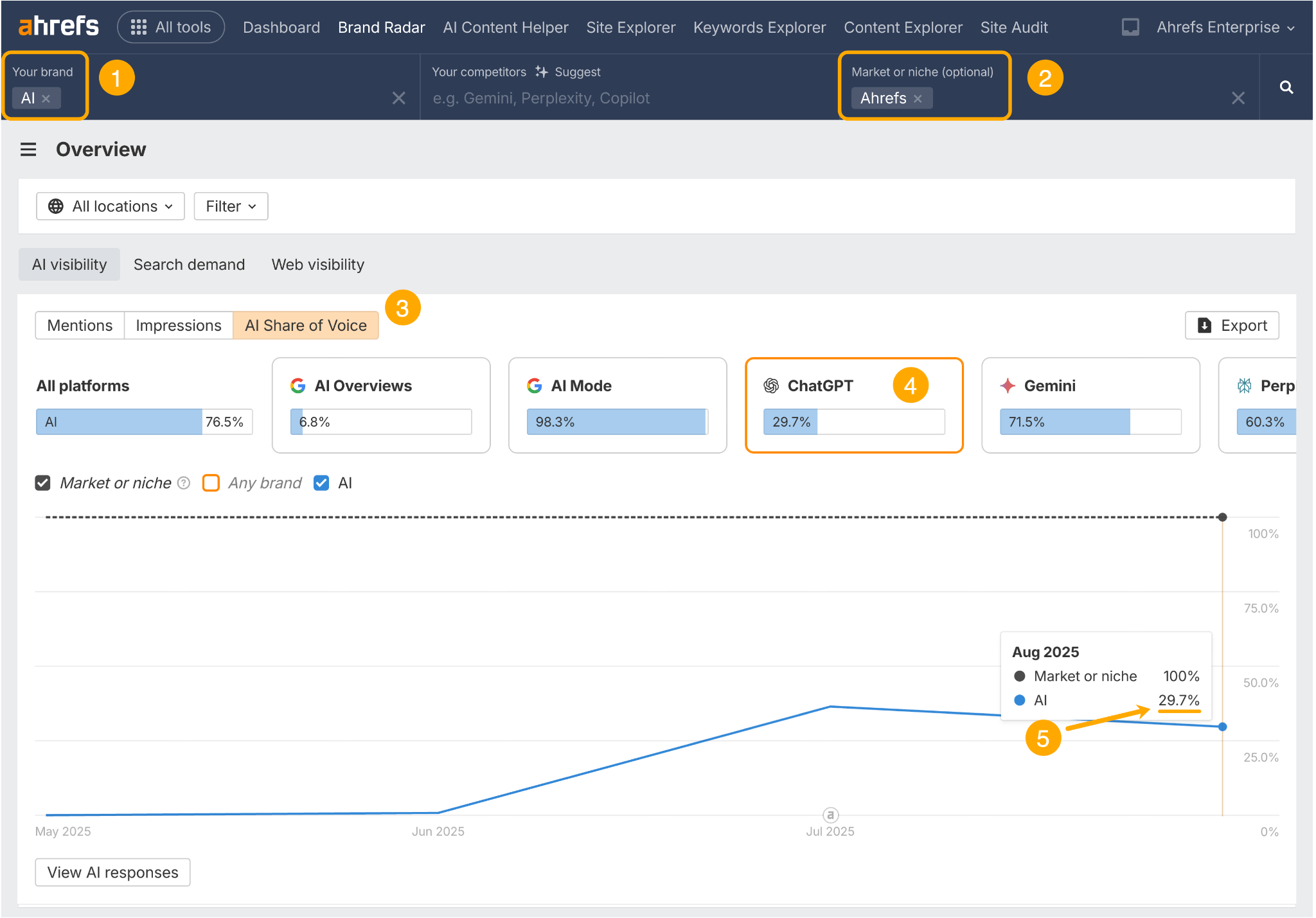

Ve al panel principal de Brand Radar de Ahrefs. Luego:

- Añade el tema de tu co-mención en el campo “marca”.

- Añade el nombre de tu marca en el campo “mercado o nicho”.

- Ve al informe de Cuota de Voz en IA.

- Selecciona la plataforma de IA que quieres analizar.

- Sigue el porcentaje de tu co-mención a lo largo del tiempo.

Esto me muestra que el 29,7% de las menciones de “Ahrefs” en ChatGPT también mencionan el tema de la IA.

Si queremos dominar las conversaciones sobre IA en la búsqueda con LLM (lo cual, por cierto, queremos), podemos rastrear este porcentaje a lo largo del tiempo para entender la alineación de la marca y ver qué tácticas marcan la diferencia.

*

Cuando se trata de potenciar la notoriedad de la marca, la relevancia es clave.

Quieres que tu contenido off-site se alinee con tu producto e historia.

Cuanto más relevantes sean las menciones para tu marca, más probable será que la gente continúe mencionándola, buscándola y citándola.

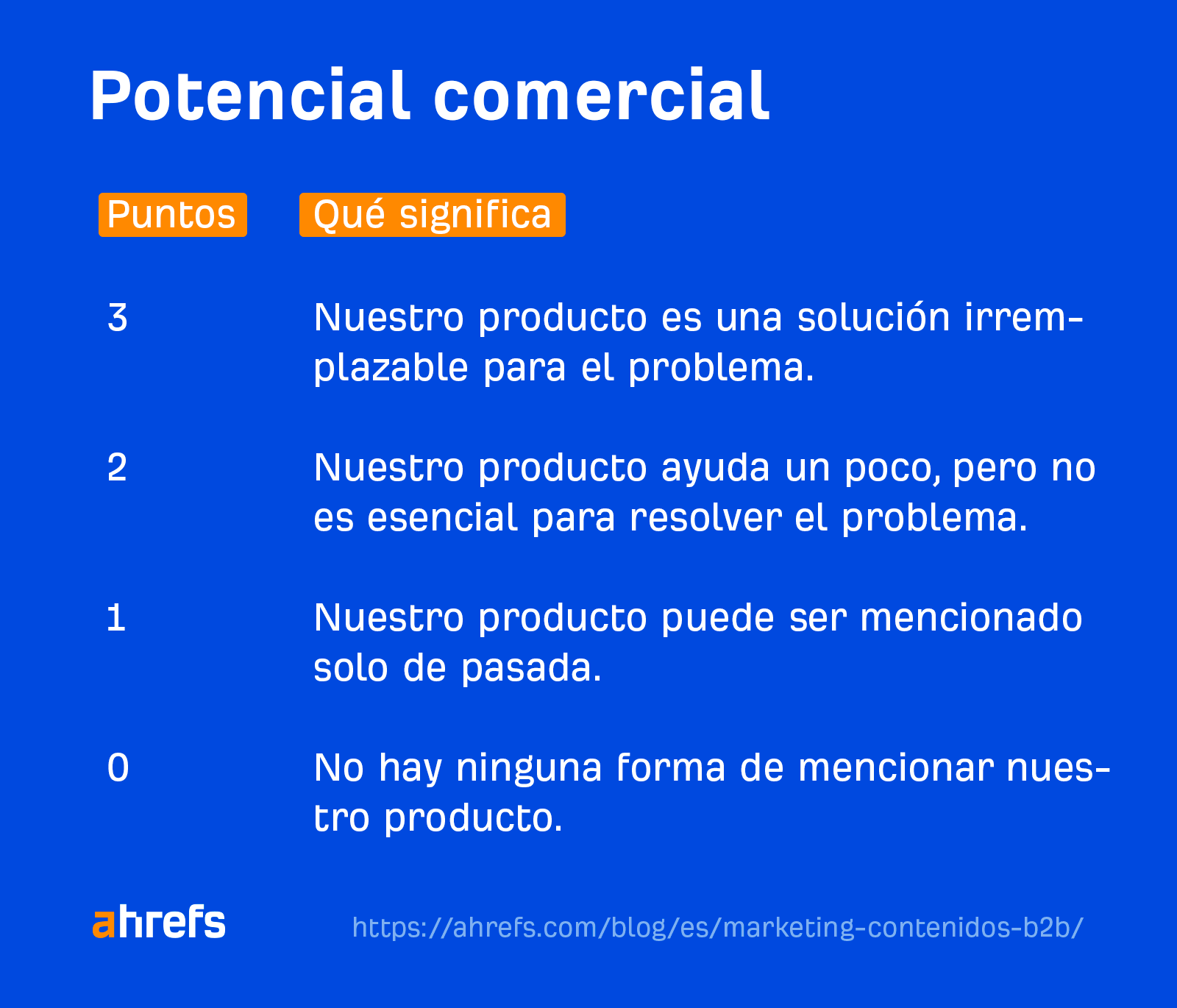

Lo pienso en términos de nuestra matriz de Potencial comercial o de negocio. Nuestro objetivo es escribir sobre temas que obtengan una puntuación de “3” en la escala de Potencial de negocio; estos son los que no se pueden discutir sin mencionar a Ahrefs.

Cuando se trata de la búsqueda con LLM, tu modus operandi debería ser cubrir temas de alto Potencial comercial para crear un ciclo de retroalimentación de menciones web y visibilidad en la IA.

Ha habido muchos consejos sobre cómo estructurar el contenido para la IA y la búsqueda con LLM, no todos fundamentados.

Personalmente, he sido cauto al dar consejos sobre este tema, porque no es algo que hayamos tenido la oportunidad de estudiar todavía.

Por eso, el reciente artículo de Dan Petrovic sobre cómo Chrome y la IA de Google manejan la inserción (embedding) fue una adición muy bienvenida a la conversación.

Esto es lo que sacamos de ello.

Escribe contenido “BLUF” (Bottom Line Up Front)

Chrome solo considera los primeros 30 pasajes de una página para la inserción.

Eso significa que necesitas asegurarte de que tu contenido más importante aparezca al principio. No malgastes valiosos espacios de pasajes en texto repetitivo, relleno o introducciones débiles.

Además, un artículo muy largo no seguirá generando pasajes interminables, hay un límite.

Si quieres cobertura en múltiples subtemas, crea artículos enfocados por separado en lugar de una pieza masiva que corre el riesgo de ser cortada a mitad.

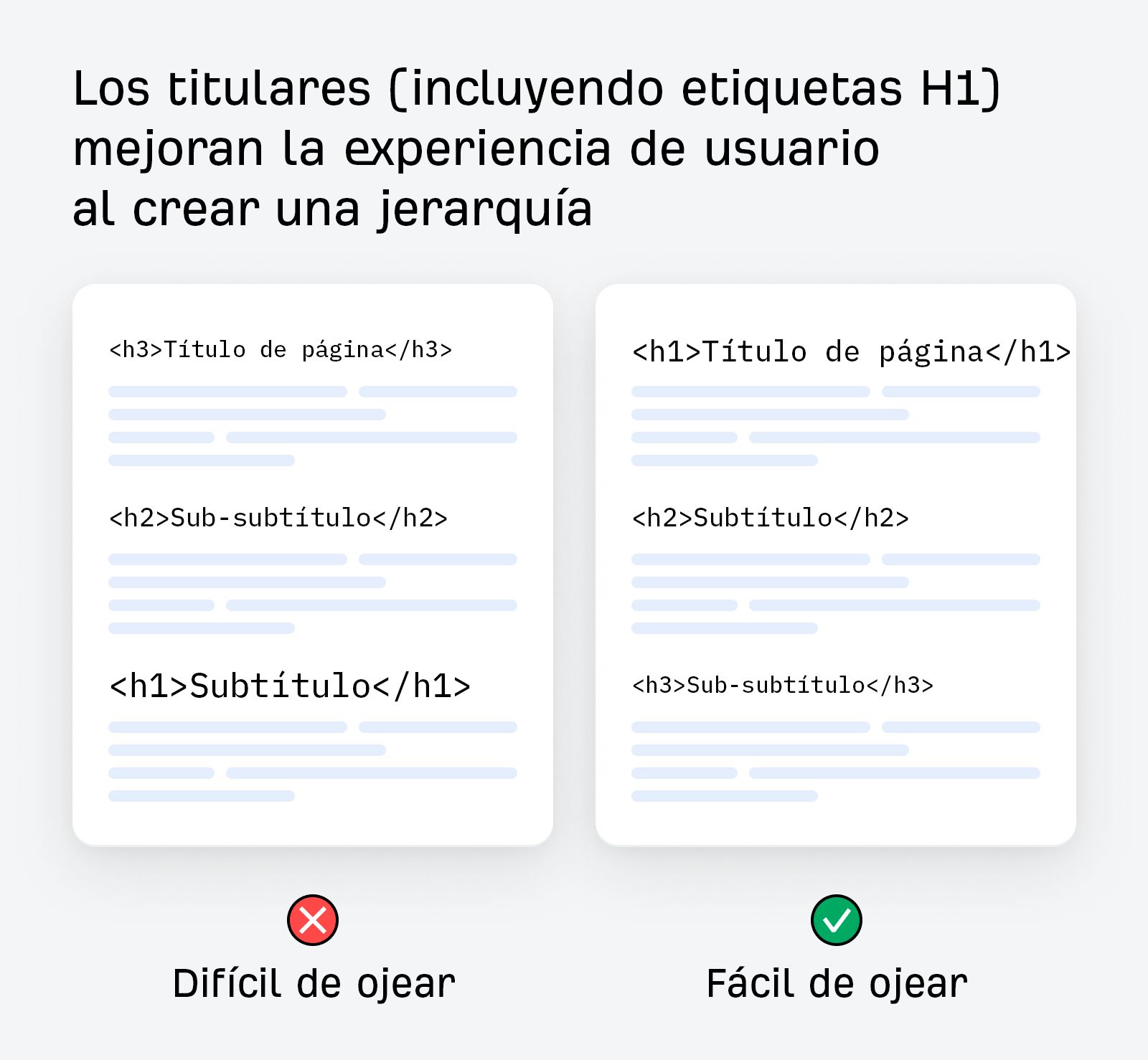

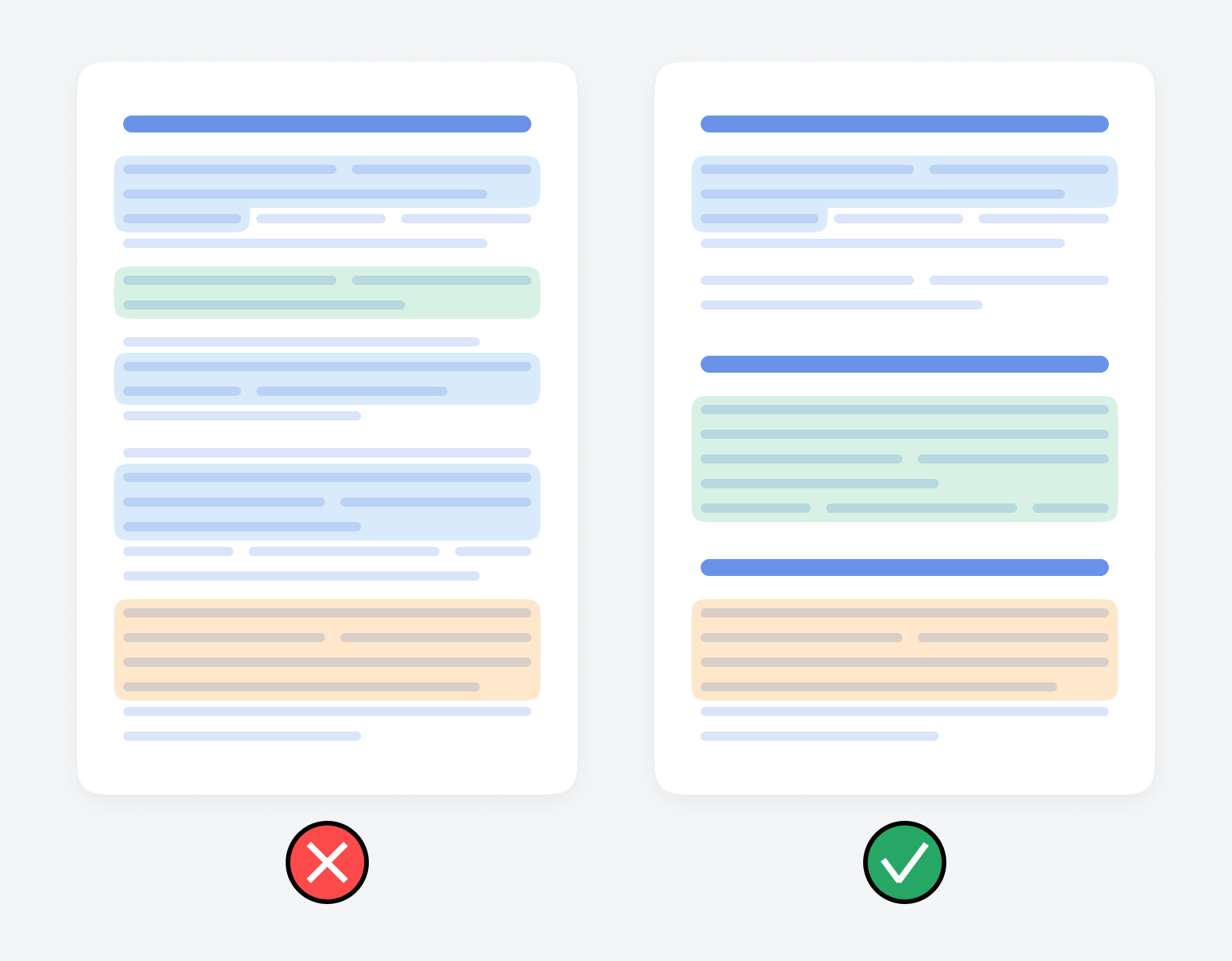

Organiza tu contenido lógicamente

La IA de Google utiliza un “algoritmo de recorrido de árbol”, lo que significa que sigue la estructura semántica HTML exacta de una página web de arriba a abajo, por eso el contenido bien formateado y estructurado es más fácil de procesar para ella.

Organiza tu contenido lógicamente, con encabezados claros, subencabezados y listas con viñetas.

¡Estoy seguro que ya lo estabas haciendo!

Mantén el contenido conciso, no hay necesidad de hacer “chunking”

Los LLM dividen el contenido en “pasajes” (fragmentos o chunks) más pequeños para la inserción.

Según los hallazgos de Dan Petrovic, Chrome utiliza un “algoritmo DocumentChunker”, que solo analiza pasajes de 200 palabras.

Lo que esto significa: la estructura importa; es probable que cada sección se recupere de forma aislada.

Lo que esto no significa: que el “chunking” sea la respuesta.

No necesitas asegurarte de que cada sección de tu contenido funcione como una idea independiente por si acaso es citada.

Y definitivamente no necesitas escribir artículos como si fueran una serie de actualizaciones de estado; eso no es algo que un usuario quiera leer.

En su lugar, agrupa lógicamente los párrafos y desarrolla las ideas de forma clara, para que tengan sentido incluso si se dividen.

Evita las secciones largas y divagantes que podrían cortarse o dividirse de manera ineficiente.

Además, no fuerces la redundancia en tu escritura; los sistemas de IA pueden manejar la superposición.

Por ejemplo, Chrome utiliza el parámetro overlap_passages para asegurarse de que no se pierda contexto importante entre los límites de los chunks.

Así que, céntrate en un flujo natural en lugar de repetirte para “unir” secciones; la superposición ya está incorporada.

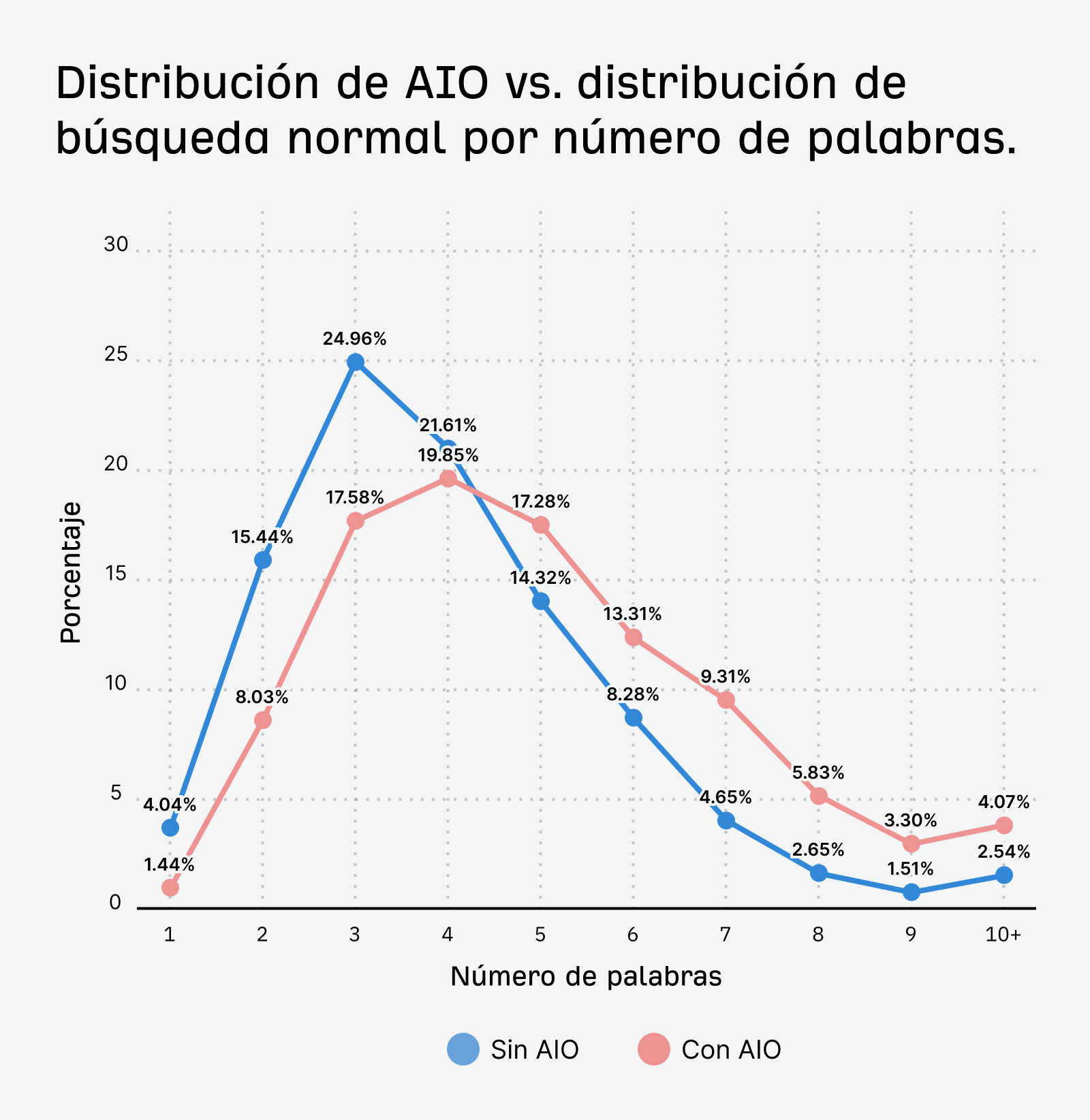

Construir clústeres de contenido y apuntar a preguntas de nicho de los usuarios puede aumentar tus probabilidades de aparecer en una respuesta de IA.

Nuestra investigación sobre AI Overviews muestra que los prompts de los usuarios en la IA son más largos y complejos que en la búsqueda tradicional.

En asistentes de IA como ChatGPT y Gemini, los prompts tienden a ser de cola ultra larga.

Metehan Yeşilyurt, Growth Marketing Manager en AppSamurai, estudió ~1.800 conversaciones reales de ChatGPT y descubrió que la longitud promedio de los prompts era de 42 palabras (!).

Y los prompts de cola larga no hacen más que multiplicarse.

Los asistentes de IA esencialmente “despliegan” los prompts en numerosas subconsultas de cola larga. Luego, ejecutan esas subconsultas a través de los motores de búsqueda para encontrar las mejores fuentes para citar.

Por lo tanto, apuntar a palabras clave de cola larga puede aumentar tus probabilidades de coincidir con la intención y ganar citas.

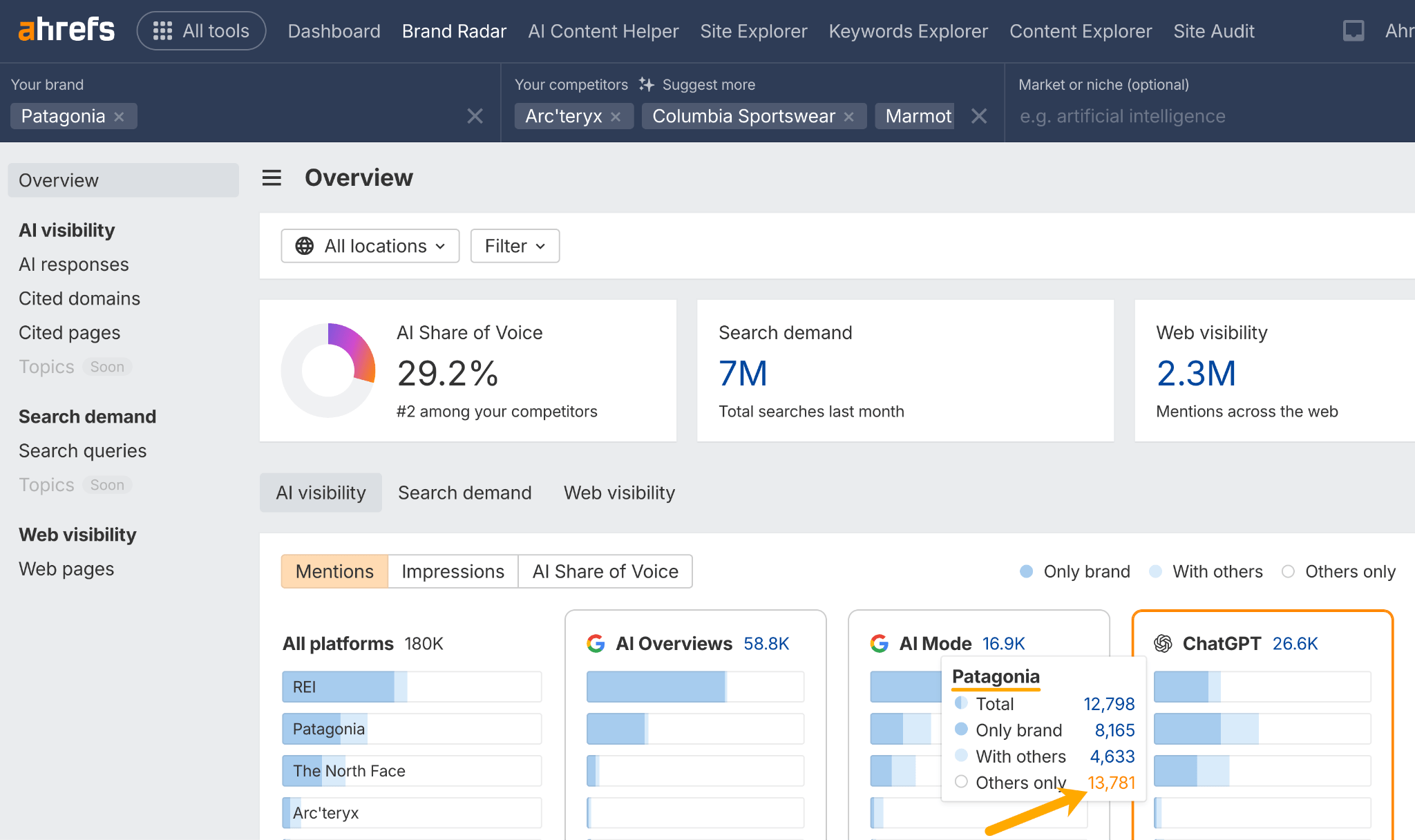

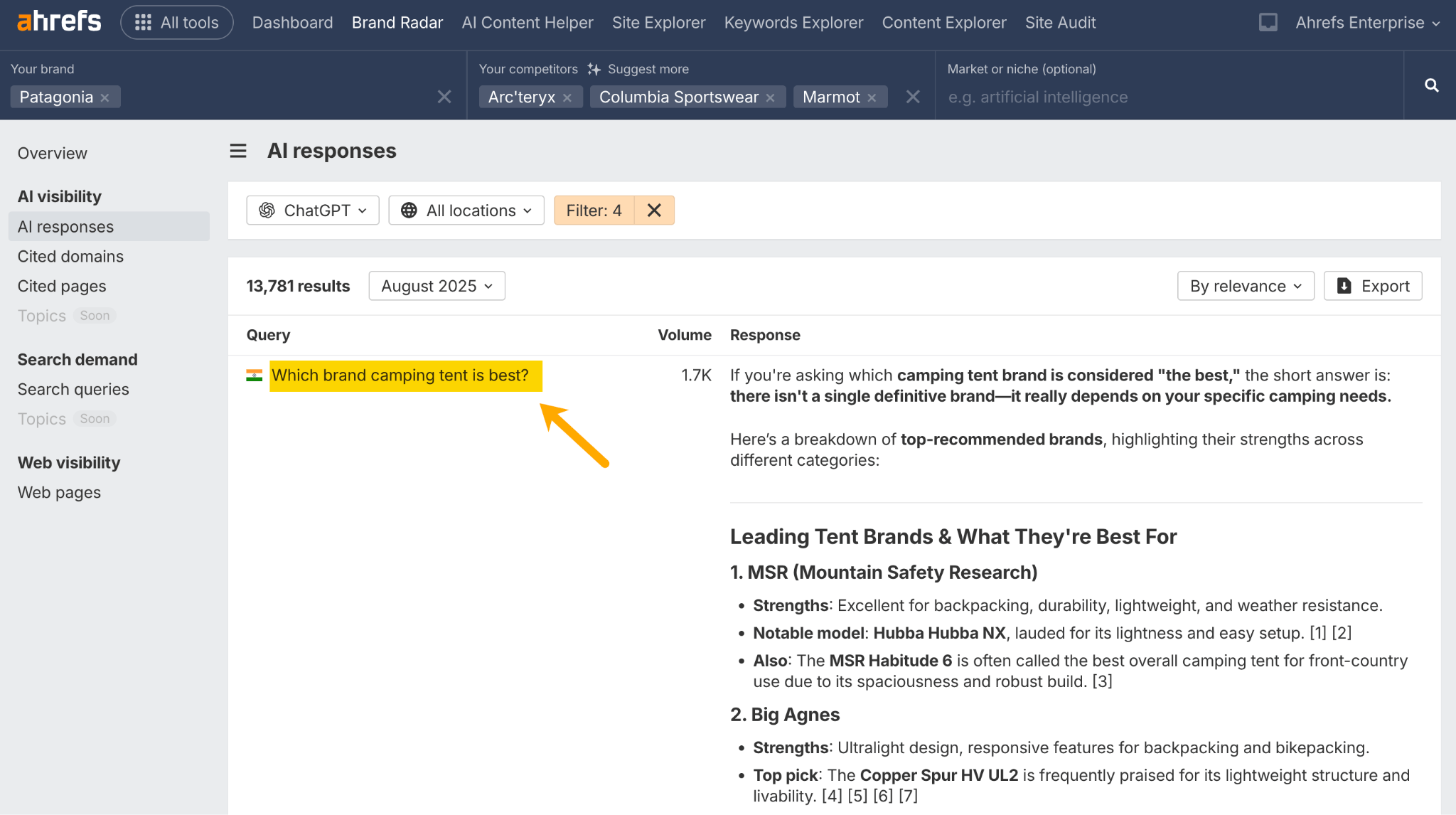

Puedes obtener ideas de palabras clave de cola larga realizando un análisis de brecha de competidores en Brand Radar de Ahrefs.

Esto te muestra los prompts para los que tus competidores son visibles y tú no; tu brecha de prompts de IA, por así decirlo.

Introduce tu marca y tus competidores, pasa el ratón sobre un asistente de IA como ChatGPT y haz clic en “Solo otros”.

Luego, estudia los prompts resultantes para obtener ideas de contenido de cola larga.

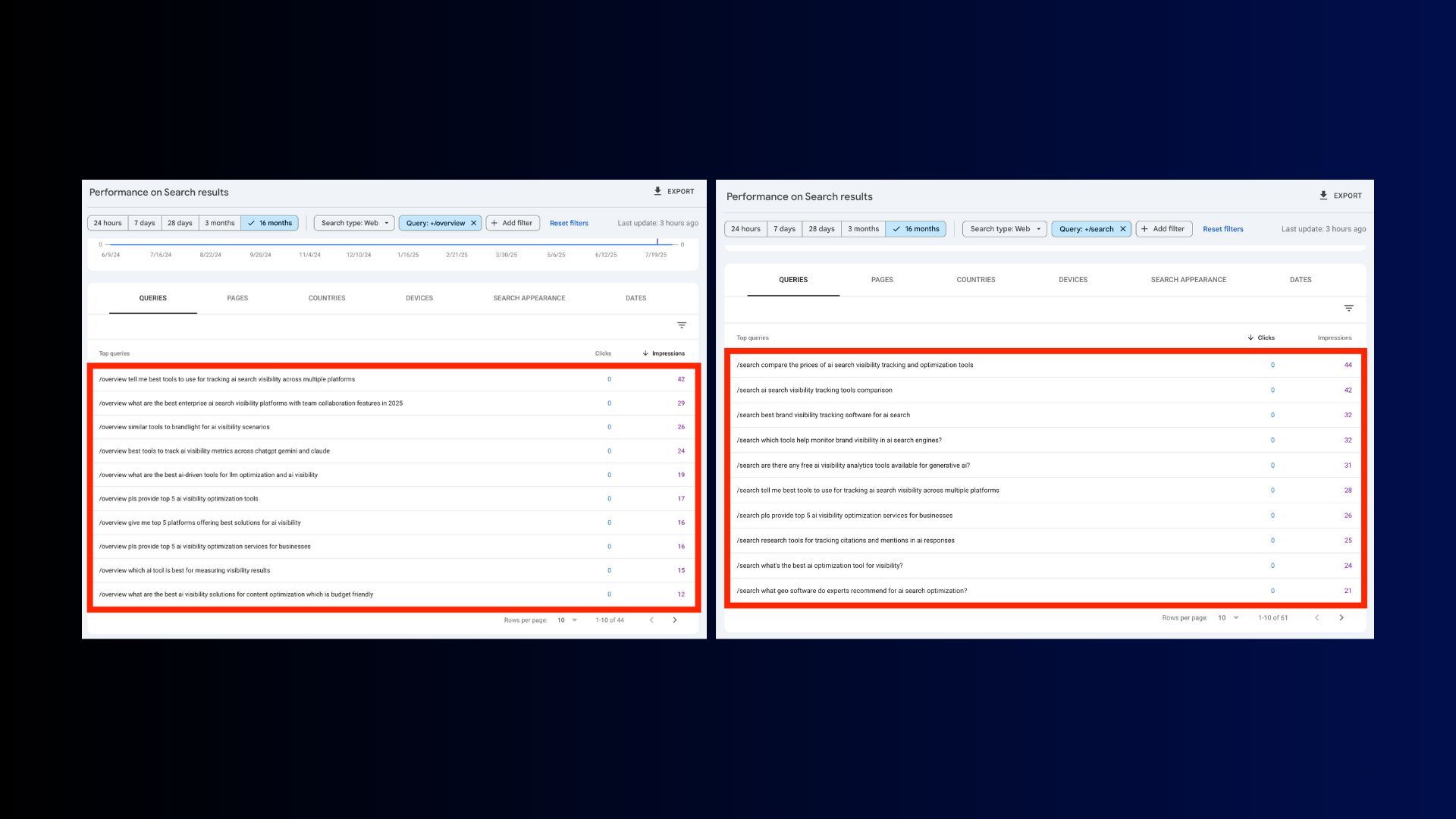

Una teoría de Nathan Gotch sugiere que los filtros de consulta en GSC que contienen /overview o /search revelan palabras clave de cola larga realizadas por los usuarios en el Modo IA, por lo que esta es otra fuente potencial de ideas de contenido de cola larga.

Crear contenido para servir a palabras clave de cola larga es inteligente. Pero lo que es aún más importante es construir clústeres de contenido que cubran todos los ángulos de un tema, no solo consultas individuales.

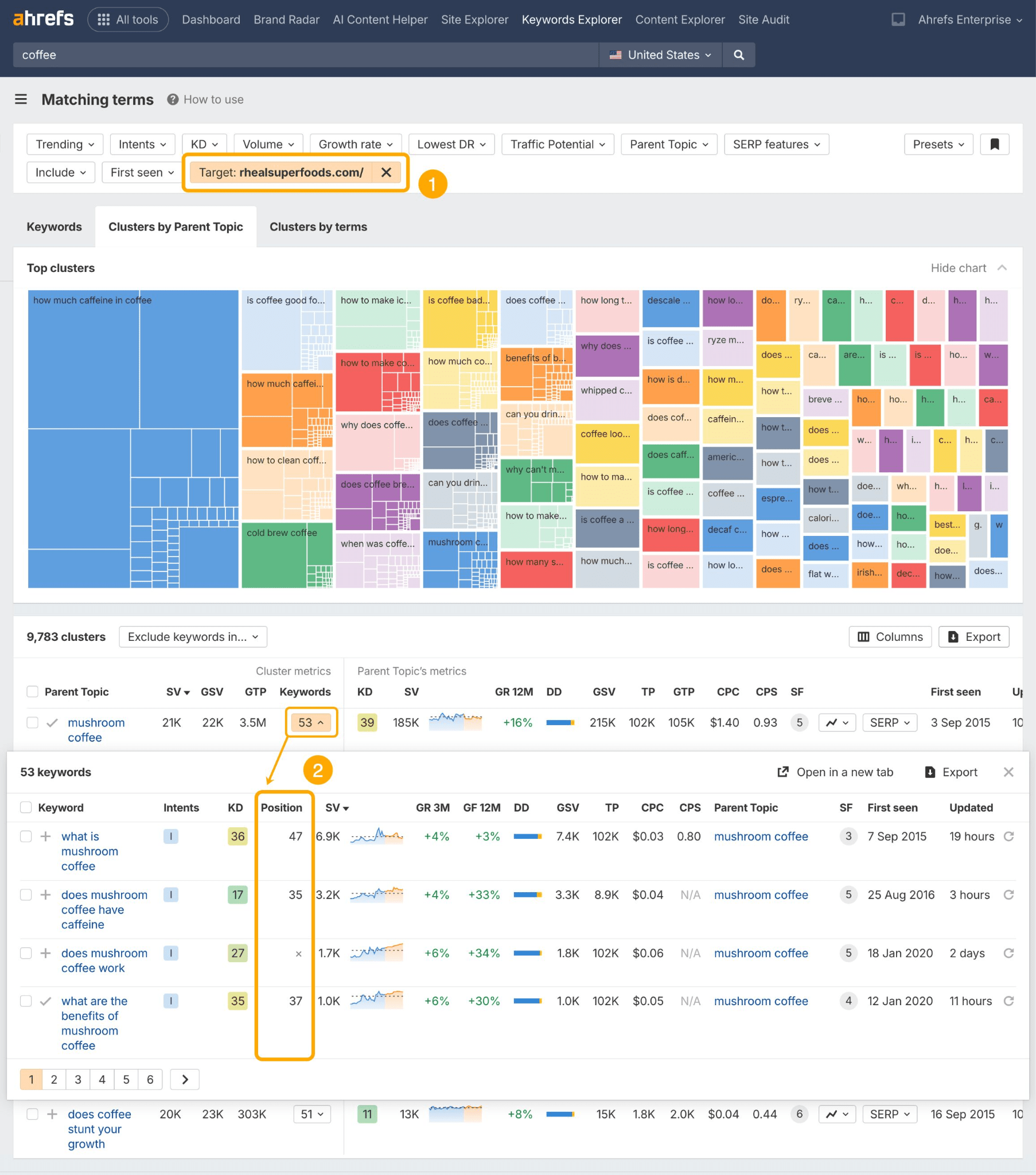

Para esto puedes usar herramientas como Also Asked o los Temas Principales de Ahrefs en Keywords Explorer de Ahrefs.

Simplemente busca una palabra clave, ve al informe de Términos coincidentes y echa un vistazo a la pestaña de Grupos por tema principal.

Luego, haz clic en la pestaña de Preguntas para obtener consultas de cola larga pre-agrupadas para atacar en tu contenido…

Para ver cuánta propiedad tienes sobre las permutaciones de consultas de cola larga existentes, añade un filtro de Objetivo para tu dominio.

Los clústeres de contenido no son nuevos. Pero la evidencia apunta a que son de mayor importancia en la búsqueda con LLM.

Todos los problemas que Google no pudo resolver ahora se están pasando a la IA.

La búsqueda con LLM puede manejar tareas de varios pasos, contenido multimodal y razonamiento, lo que la hace bastante formidable para la asistencia en tareas.

Volviendo a la investigación de ChatGPT mencionada anteriormente, Metehan Yeşilyurt descubrió que el 75% de los prompts de IA son comandos, no preguntas.

Esto sugiere que un número significativo de usuarios recurre a la IA para completar tareas.

En respuesta, es posible que quieras empezar a hacer un mapeo de acciones: considerar todas las posibles tareas que tus clientes querrán completar y que de alguna manera puedan involucrar a tu marca o sus productos.

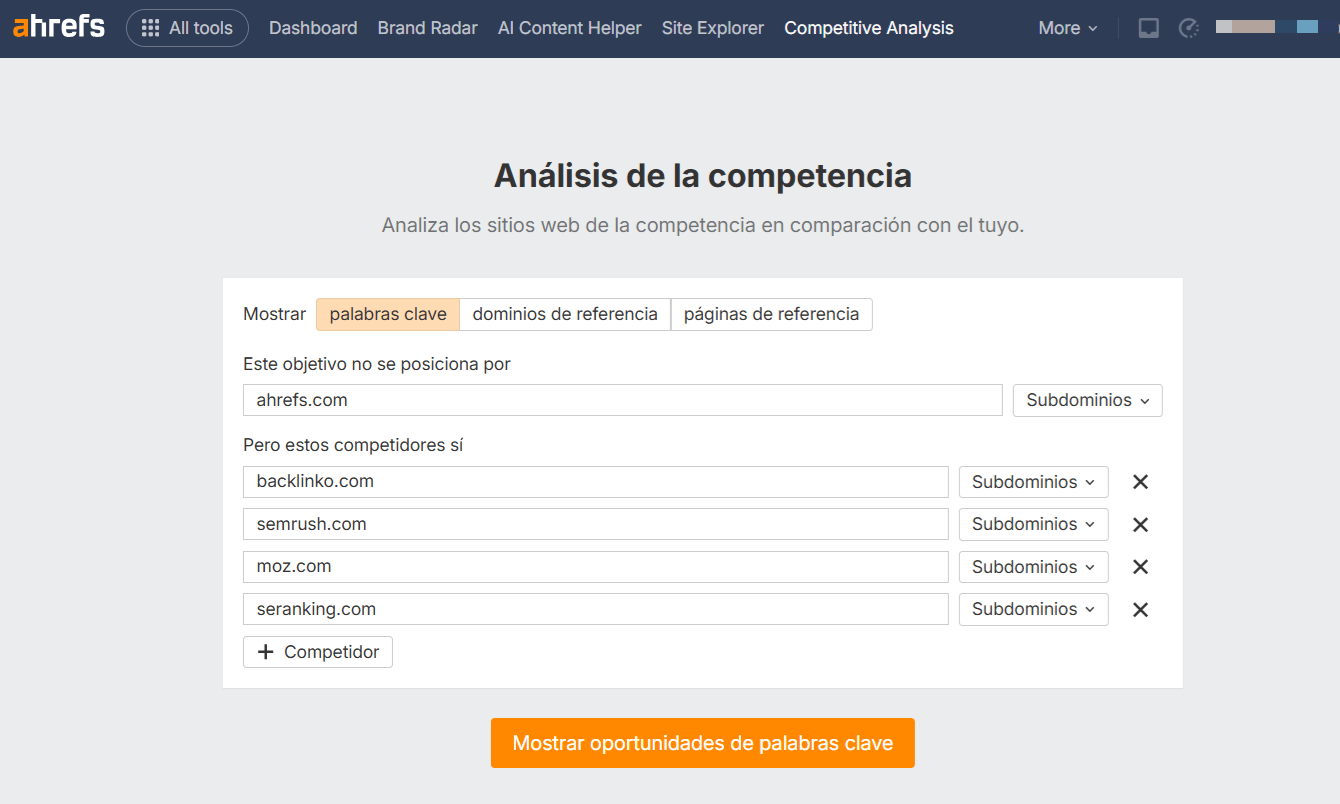

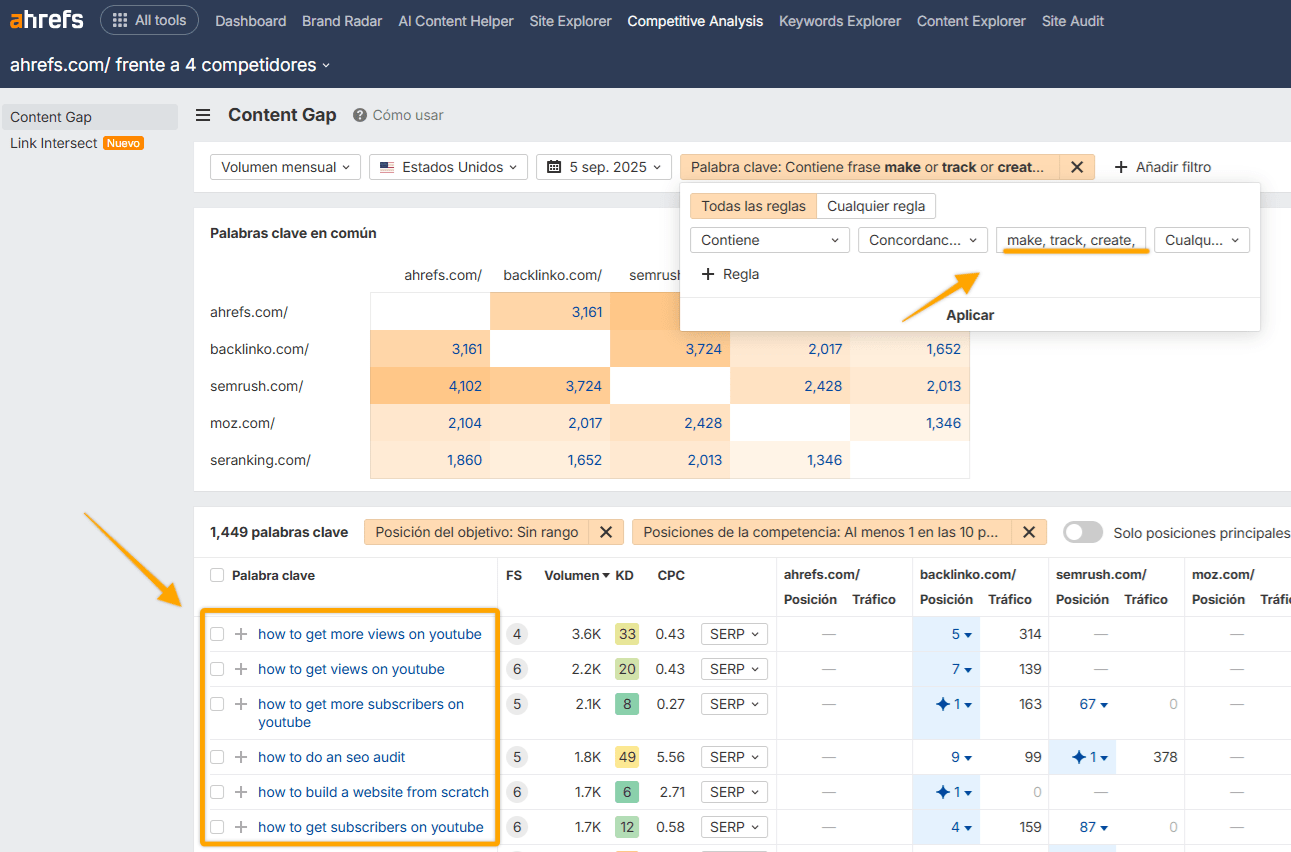

Para mapear las tareas de los clientes, ve al Análisis de la competencia de Ahrefs y configura una búsqueda para ver dónde son visibles tus competidores, pero tú no.

Luego filtra por palabras clave de acción relevantes (p. ej., “hacer”, “rastrear”, “crear”, “generar”) y palabras clave de pregunta (p. ej., “cómo” o “cómo puedo”).

Una vez que sepas qué acciones principales quiere realizar tu audiencia, crea contenido para apoyar esos trabajos por hacer.

Analizamos 17 millones de citas en 7 plataformas de búsqueda de IA y descubrimos que los asistentes de IA prefieren citar contenido más reciente.

El contenido citado en la IA es un 25,7% más reciente que el contenido en las SERP orgánicas, y los asistentes de IA muestran una preferencia del 13,1% por el contenido actualizado más recientemente.

ChatGPT y Perplexity en particular priorizan las páginas más nuevas y tienden a ordenar sus citas de la más nueva a la más antigua.

¿Por qué importa tanto la frescura? Porque el RAG (generación aumentada por recuperación) generalmente se activa cuando una consulta requiere información fresca.

Si el modelo ya “conoce” la respuesta a partir de sus datos de entrenamiento, no necesita buscar.

Pero cuando no la sabe, busca la información más reciente disponible, especialmente cuando se trata de temas emergentes.

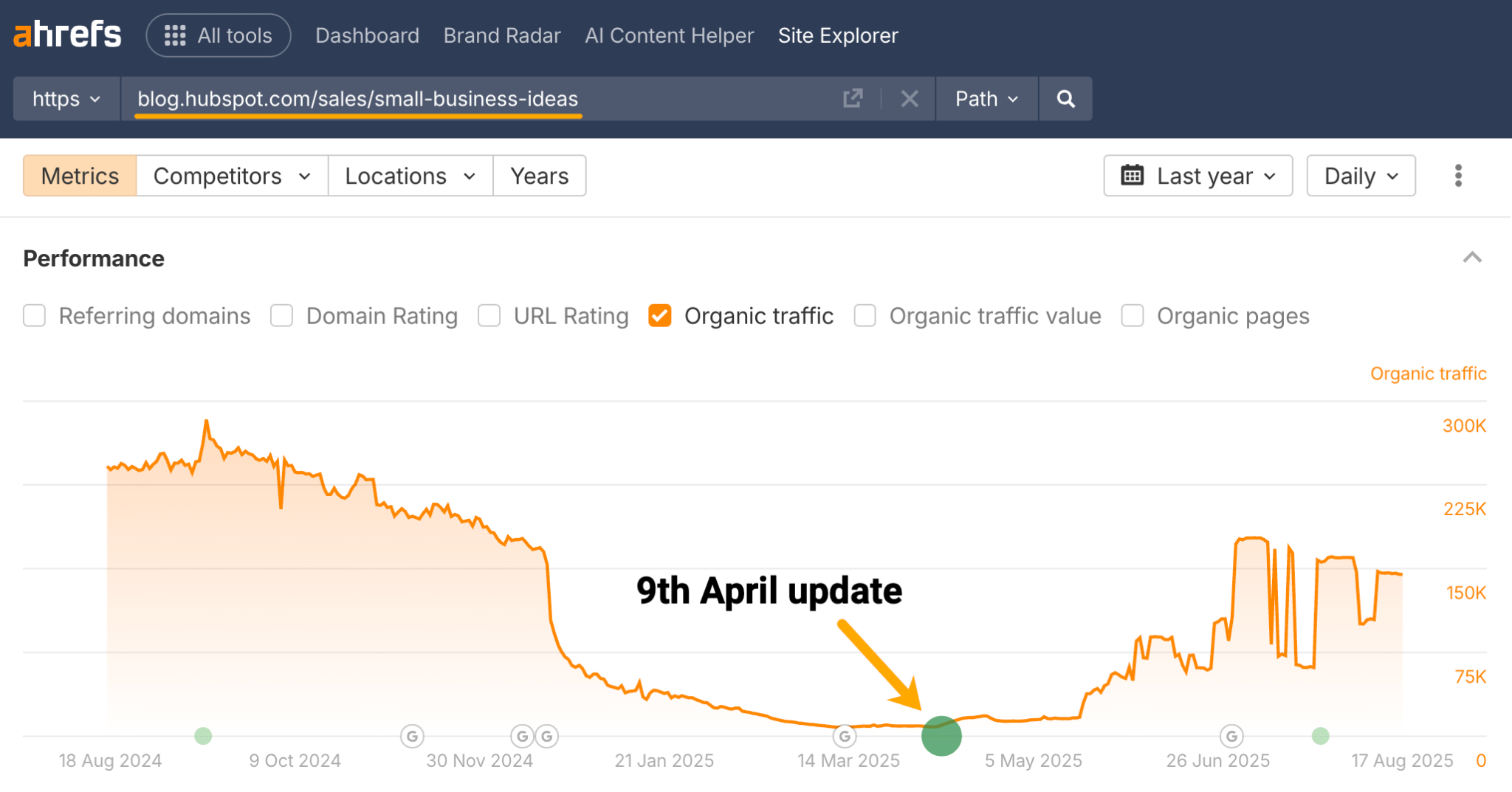

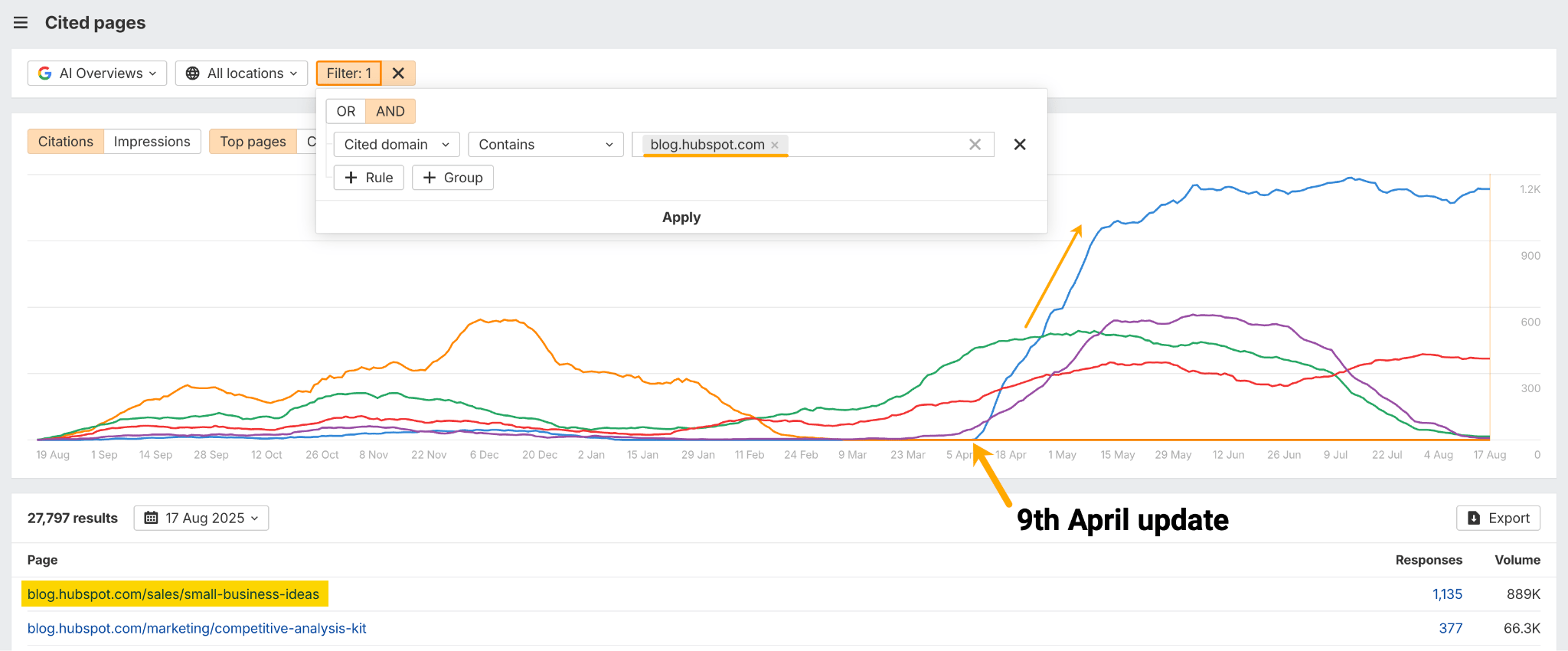

En el ejemplo siguiente, Hubspot realizó una actualización en un blog sobre “ideas para pequeñas empresas” el 9 de abril, según los datos de Cambios de Contenido en Site Explorer de Ahrefs.

El artículo es ahora su blog más citado en AI Overviews, según Brand Radar de Ahrefs. Esa única actualización de contenido ha generado 1.135 nuevas menciones en AI Overview.

Nuestra investigación sugiere que mantener tu contenido actualizado puede aumentar su atractivo para los motores de IA que buscan la información más reciente.

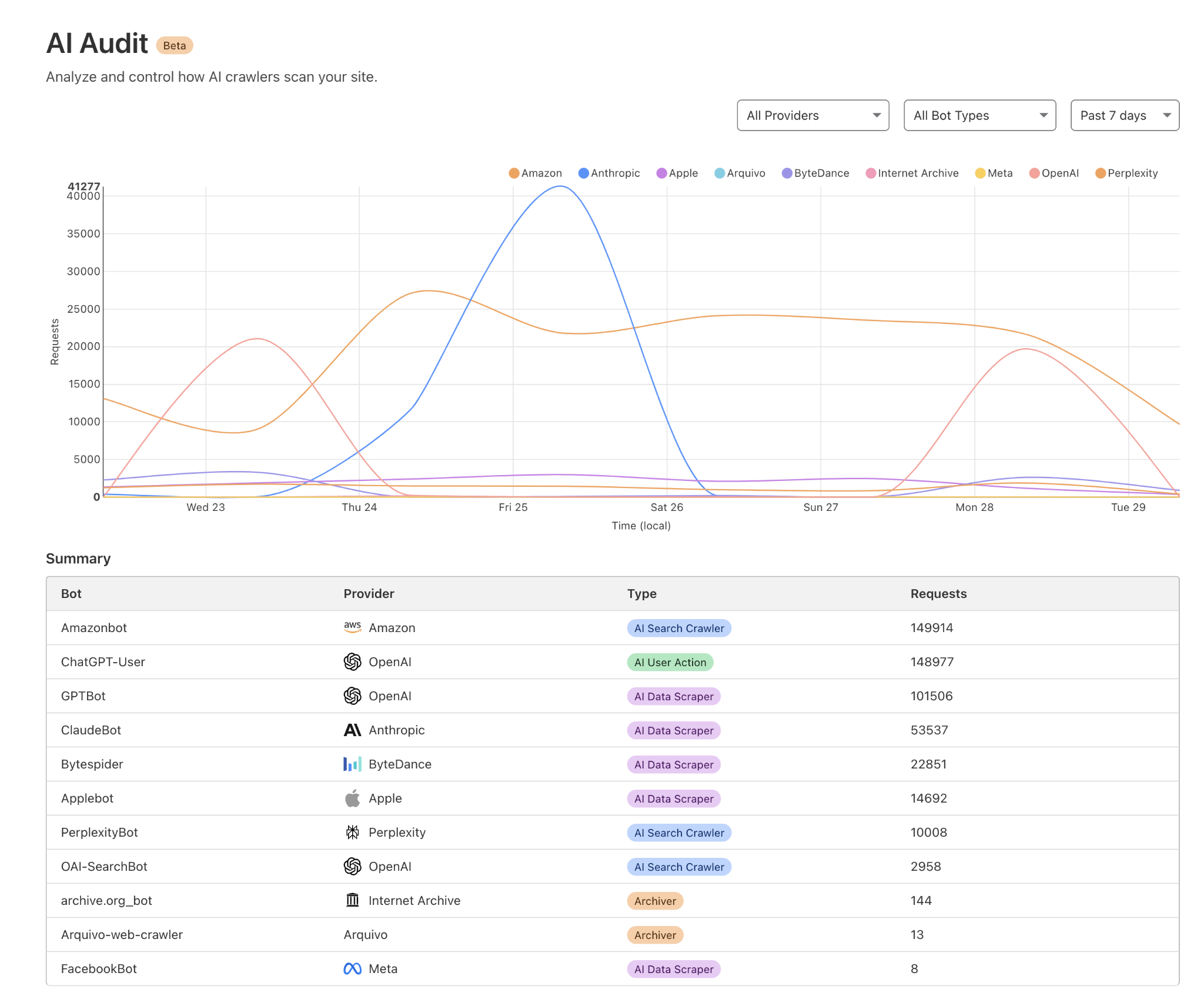

Para que tu contenido sea citado en las respuestas de la IA, necesitas permitir que los bots de IA lo rastreen.

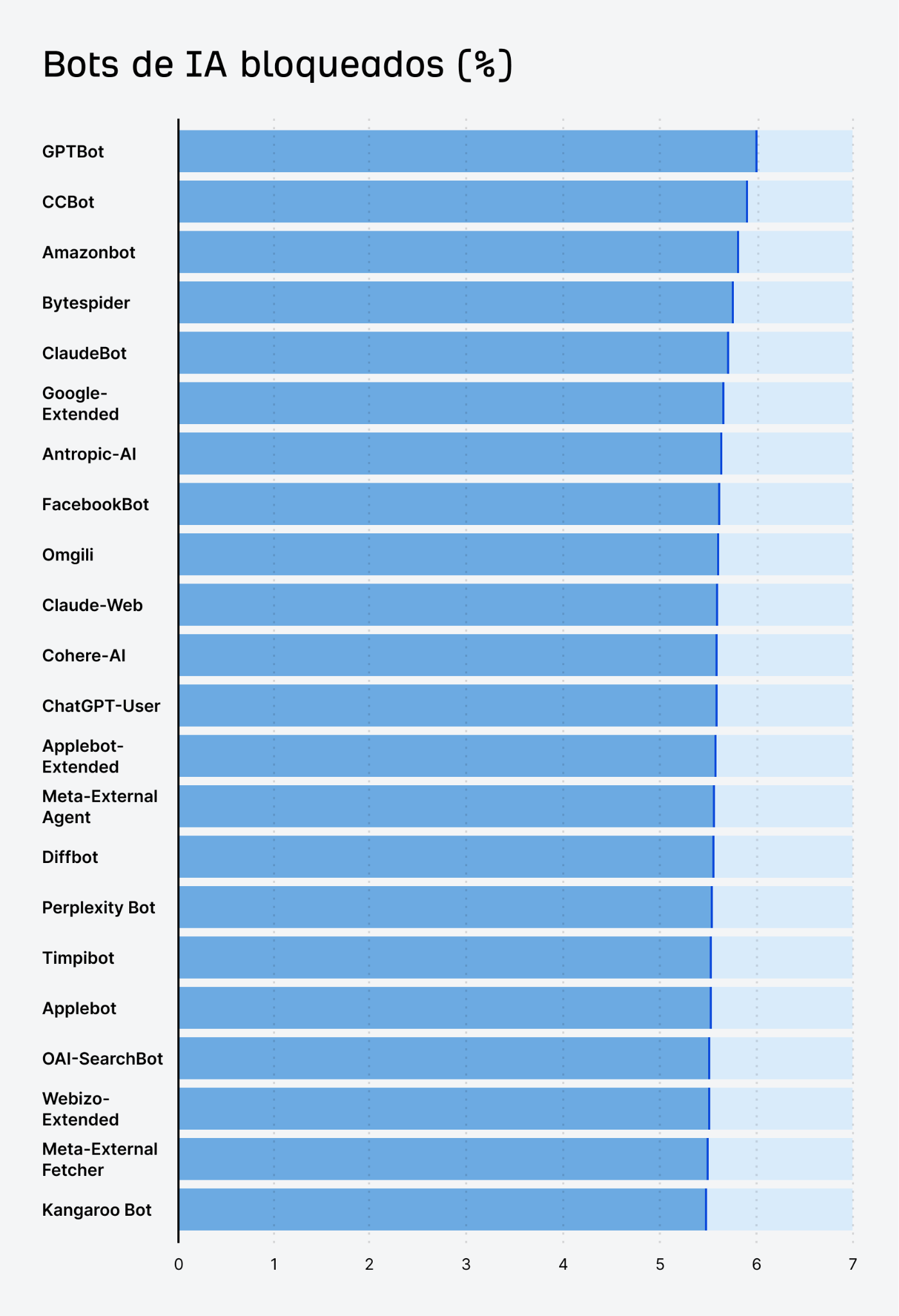

Un número creciente de sitios ha comenzado a bloquear los scrapers de IA.

Según nuestra propia investigación, ~5,9% de todos los sitios web no permiten el GPTBot de OpenAI por preocupaciones sobre el uso de datos o la sobrecarga de recursos.

Aunque eso es comprensible, el bloqueo también podría significar renunciar a la futura visibilidad en la IA.

Si tu objetivo es que ChatGPT, Perplexity, Gemini y otros asistentes de IA mencionen tu marca, revisa tu robots.txt y las reglas de tu firewall para asegurarte de que no estás bloqueando accidentalmente a los principales rastreadores de IA.

Asegúrate de permitir que los bots legítimos indexen tus páginas.

De esta manera, tu contenido puede ser parte de los datos de entrenamiento o de navegación en tiempo real que utilizan los asistentes de IA, dándote la oportunidad de ser citado cuando surjan consultas relevantes.

Puedes verificar qué bots de IA están accediendo a tu sitio revisando los registros de tu servidor o usando una herramienta como Cloudflare AI audit.

Los dominios más citados varían mucho entre las diferentes áreas de búsqueda con LLM. Ser un ganador en una no garantiza la presencia en otras.

De hecho, entre los 50 dominios más mencionados en Google AI Overviews, ChatGPT y Perplexity, encontramos que solo 7 dominios aparecían en las tres listas.

Eso significa que un asombroso 86% de las fuentes eran únicas para cada asistente.

Google se apoya en su propio ecosistema (p. ej., YouTube), además de contenido generado por usuarios, especialmente comunidades como Reddit y Quora.

ChatGPT favorece a los editores y las alianzas con medios, particularmente agencias de noticias como Reuters y AP, por encima de Reddit o Quora.

Y Perplexity prioriza fuentes diversas, especialmente sitios globales y de nicho, p. ej., sitios de salud o específicos de una región como tuasaude o alodokter.

No hay una estrategia de citación única para todos. Cada asistente de IA muestra contenido de diferentes sitios.

Si solo optimizas para los rankings de Google, podrías dominar en AI Overviews pero tener menos presencia en ChatGPT.

Por otro lado, si tu marca es recogida por noticias/medios, podría aparecer en las respuestas de ChatGPT, incluso si sus rankings en Google van a la zaga.

En otras palabras, vale la pena probar diferentes estrategias para diferentes LLM.

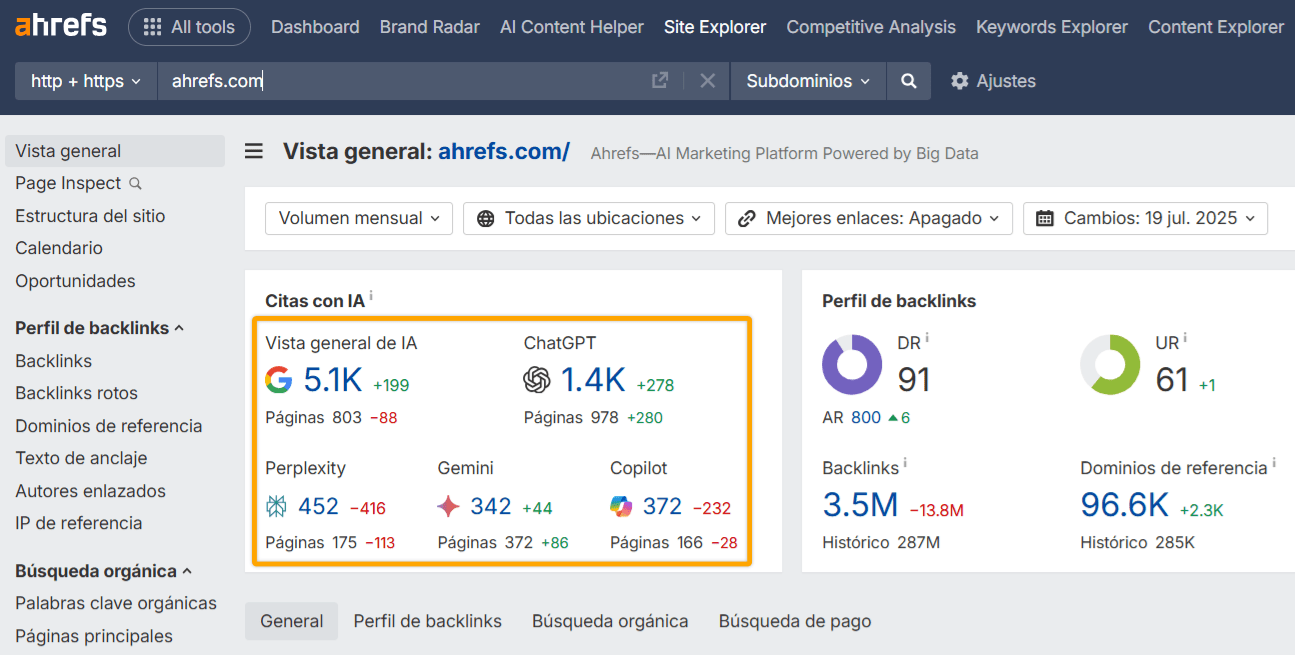

Puedes usar Ahrefs para ver cómo aparece tu marca en Perplexity, ChatGPT, Gemini y las funciones de búsqueda de IA de Google.

Simplemente introduce tu dominio en Site Explorer y mira el recuento de citas de IA de alto nivel en el informe de Vista general.

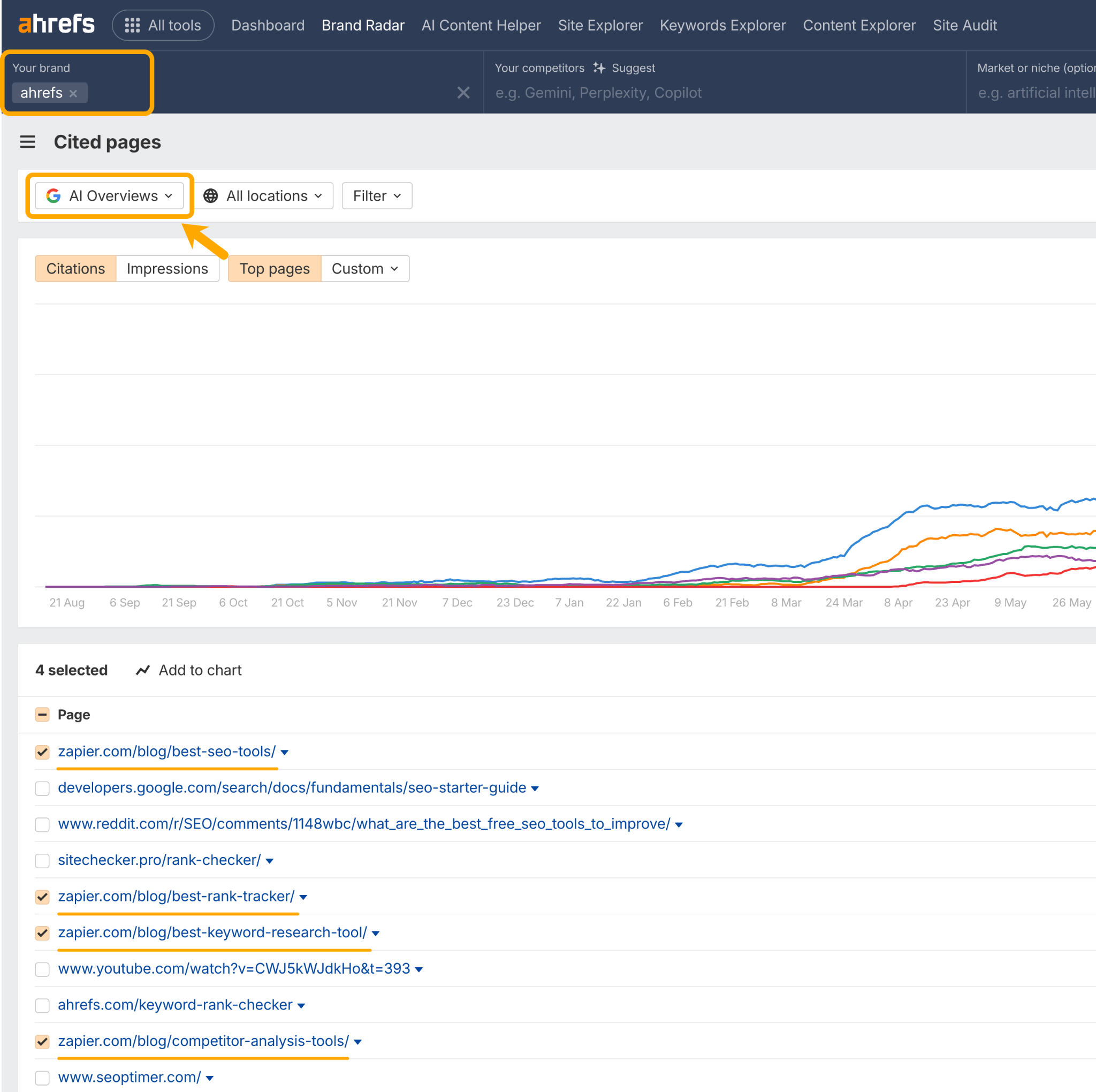

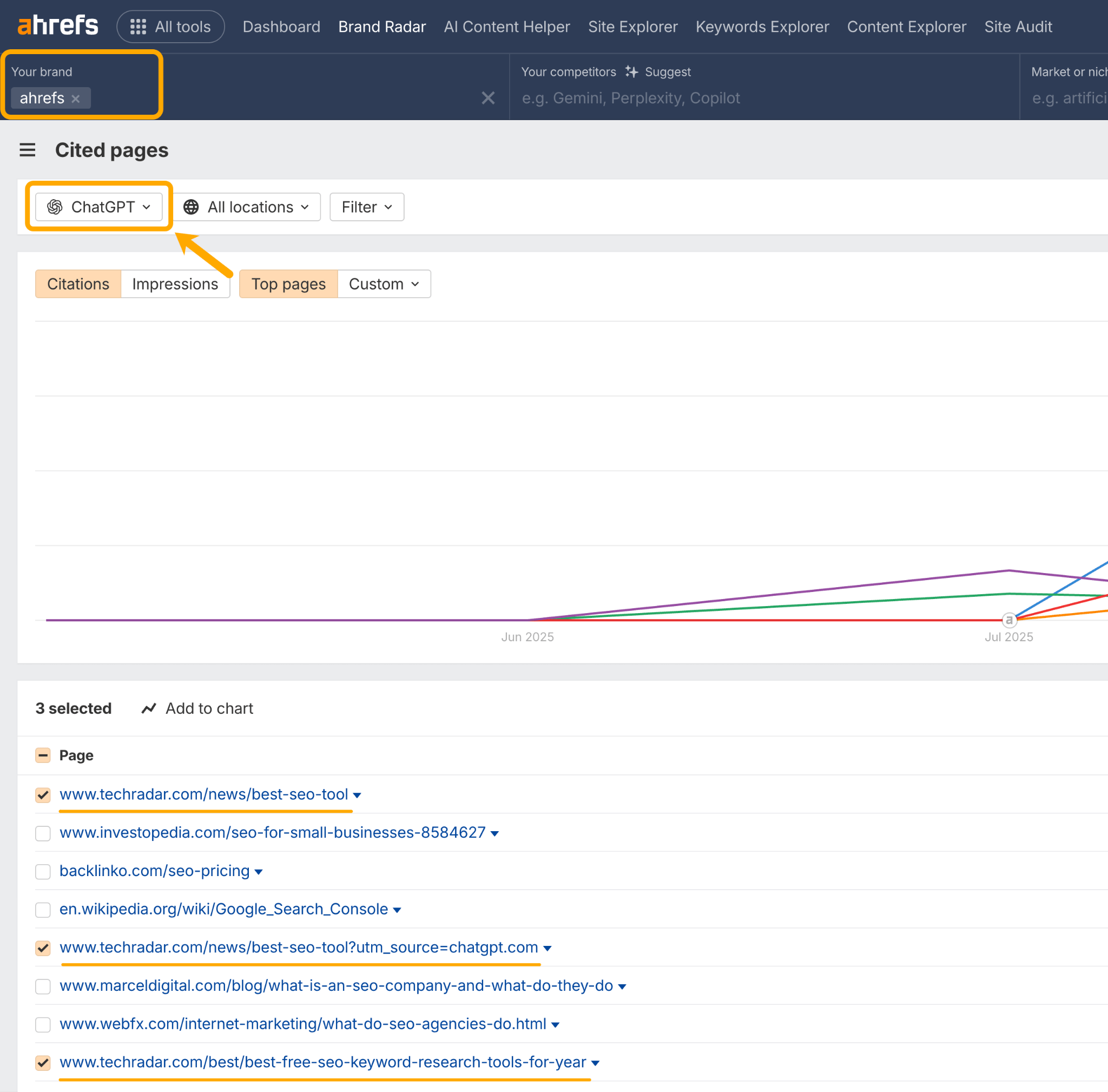

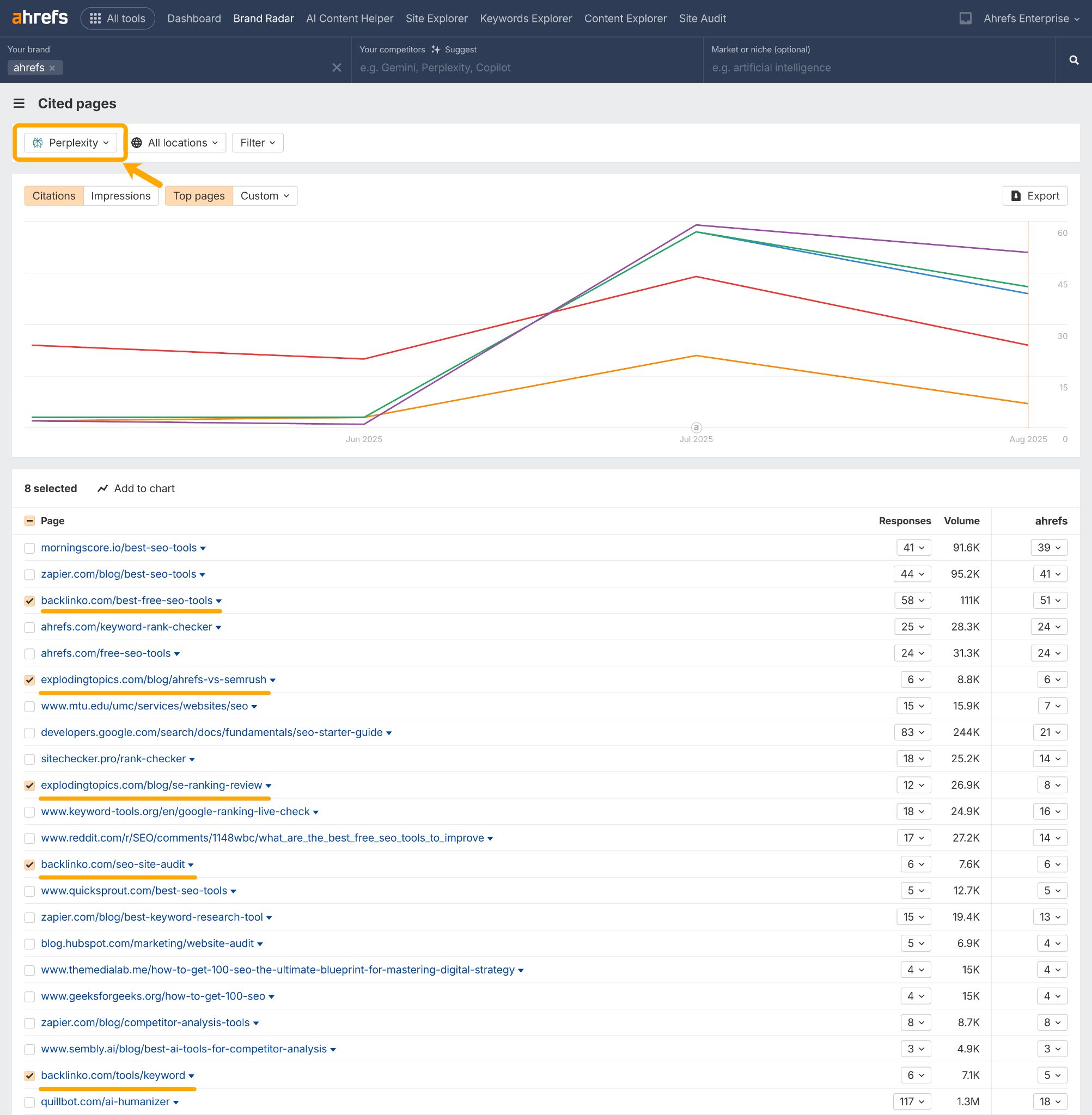

Luego, profundiza en el informe de Páginas Citadas de Brand Radar.

Esto te ayudará a estudiar los diferentes sitios y formatos de contenido preferidos por los diferentes asistentes de IA.

Por ejemplo, las menciones de Ahrefs in AI Overviews tienden a provenir de Zapier a través de listas de las “Mejores” herramientas.

Mientras que en ChatGPT, se nos menciona más en las listas de “Mejores” herramientas de Tech Radar.

Y en Perplexity, nuestros principales competidores están controlando la narrativa con contenido “vs”, “reseñas” y listas de “herramientas”.

Con esta información, podemos:

- Mantener a los redactores de Zapier al tanto de nuestros desarrollos de productos, con la esperanza de que sigamos siendo recomendados en futuras guías de herramientas, para impulsar la visibilidad en AI Overview.

- Lo mismo para Tech Radar, para ganar visibilidad consistente en ChatGPT.

- Crear/optimizar nuestras propias versiones del contenido de la competencia que se está mostrando en Perplexity, para recuperar el control de esa narrativa.

Reflexiones finales

Muchos de estos consejos pueden sonar familiares, porque en gran parte son solo SEO y marketing de marca.

Los mismos factores que impulsan el SEO (autoridad, relevancia, frescura y accesibilidad) son también los que hacen que las marcas sean visibles para los asistentes de IA.

Y toneladas de desarrollos recientes lo demuestran: ChatGPT ha sido recientemente descubierto raspando los resultados de búsqueda de Google, GPT-5 se está apoyando fuertemente en la búsqueda en lugar del conocimiento almacenado, y los LLM están comprando datos del gráfico de enlaces de los motores de búsqueda para ayudar a ponderar y priorizar sus respuestas.

Según esa medida, el SEO no está muerto en absoluto; de hecho, está haciendo gran parte del trabajo pesado.

Así que, la conclusión es: redobla los esfuerzos en las prácticas probadas de SEO y construcción de marca si también quieres visibilidad en la IA.

Genera menciones de marca de alta calidad, crea contenido estructurado y relevante, mantenlo actualizado y asegúrate de que pueda ser rastreado.

A medida que la búsqueda con LLM madure, estamos seguros de que estos principios fundamentales te mantendrán visible.

¿Tienes preguntas? Estamos en LinkedIn y en X.