自社調査によると、AI による概要の導入によりクリック率(CTR)は 34.5% 低下していることがわかりました。さらに Seer Interactive による最新の調査では、最大 61% の低下が報告されています。

また、Pew Research Center の調査では、AI による要約が表示された検索結果では、ユーザーが従来の検索結果をクリックする割合はわずか 8% にとどまり、要約が表示されない場合の 15% と比べて大きく低下しています。

vはあらゆる場面でトラフィックを奪っていますが、すでに検索環境の一部となっており、私たちはそれを前提に向き合わざるを得ません。

現在の SERP(検索結果画面)は、トラフィック獲得よりも認知(アウェアネス)の獲得が重視される場へと変化しています。

そして、AI による概要に表示されなければ、そもそも見られることはありません。それが現実です。

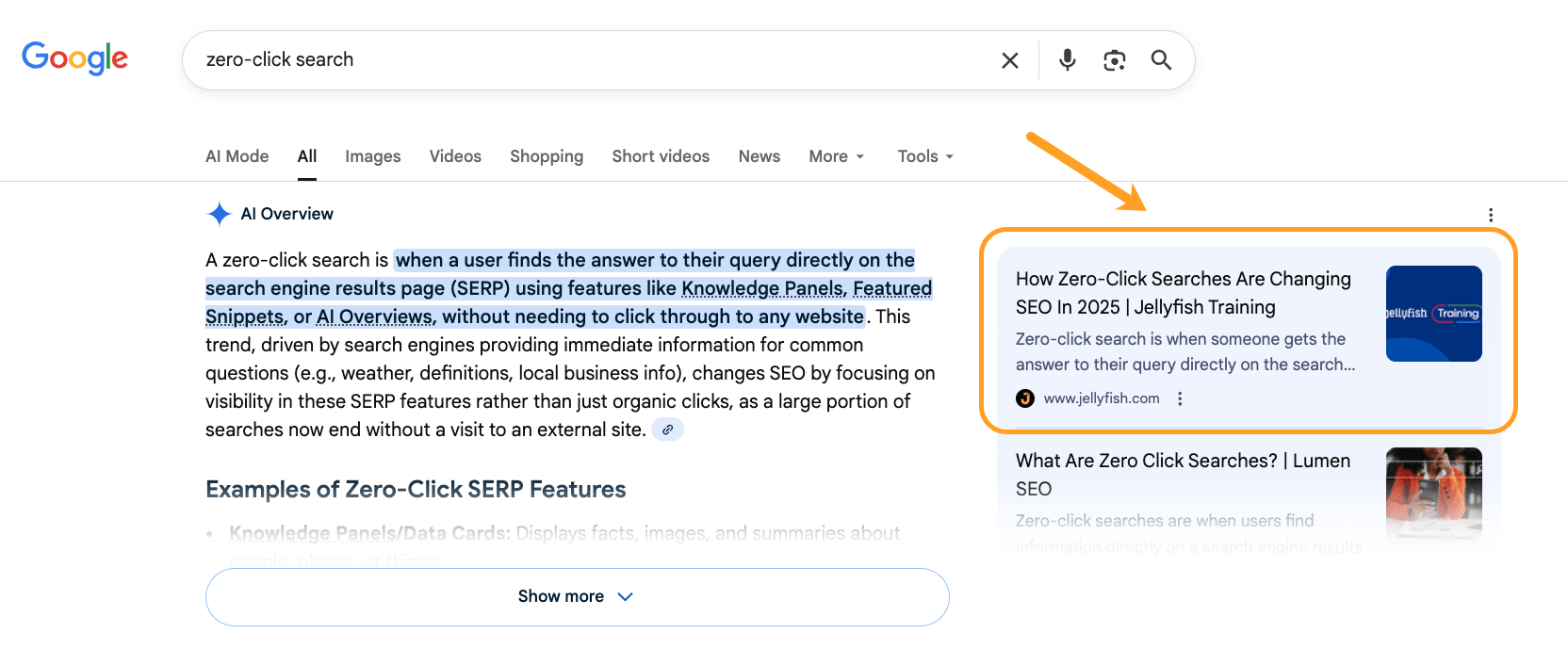

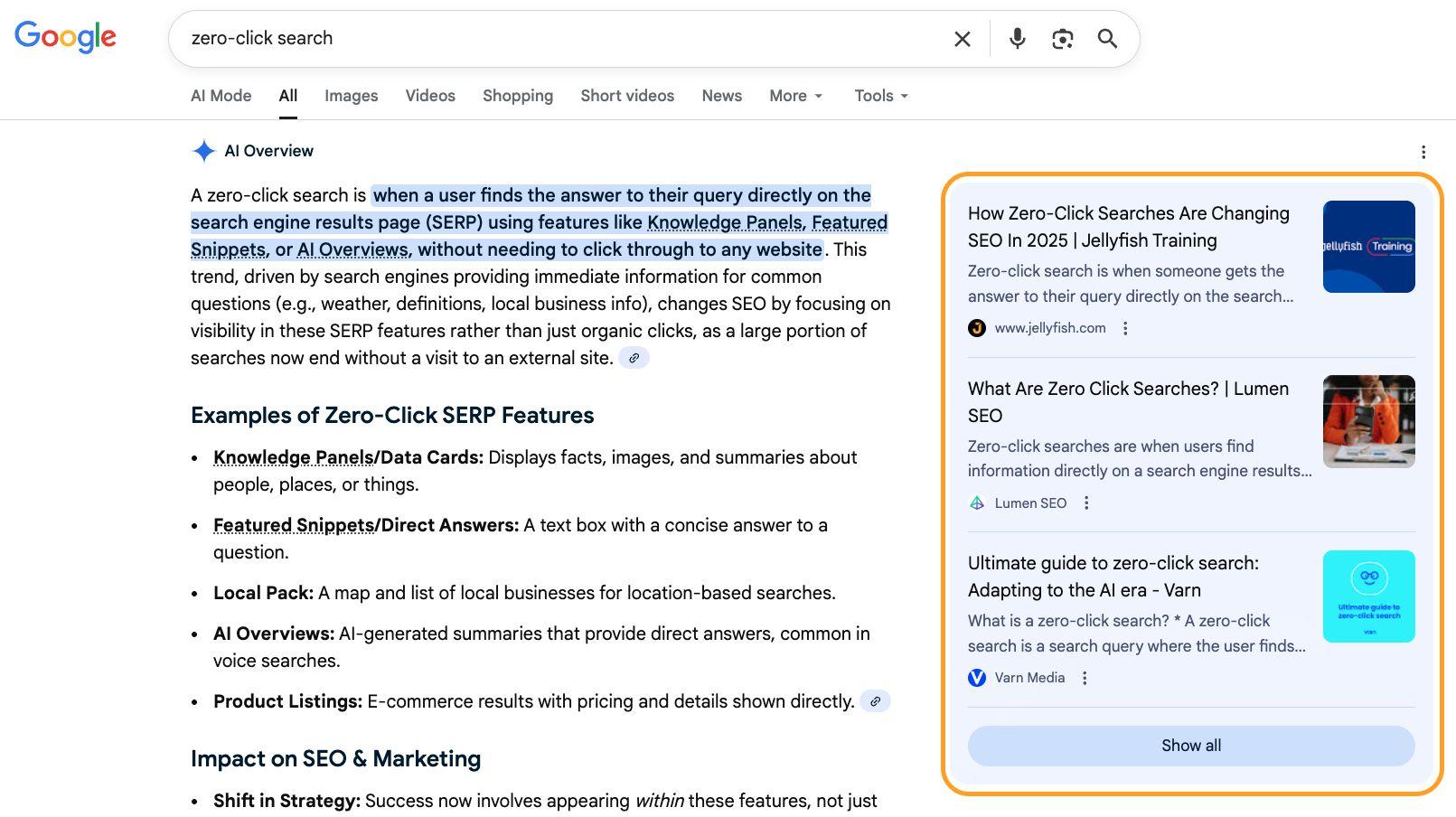

AI 検索の回答は通常 SERP の最上部に表示されます。そこで自社のページが引用されていれば、実質的に AI による概要で「上位表示」されている状態だと言えます。

最上位で引用されている URL は、デスクトップ検索において、ユーザーが操作を行わなくても視認できる位置に表示されます。

ユーザーが「もっと見る」をクリックすると上位 3 つの URL が表示され、「すべて表示」をクリックすると、引用元の一覧がすべて表示されます。

これらの「ランキング」は確定的なものではないため、従来の検索順位と同じものとして捉えるべきではありません。

Google の AI による要約は非決定的(non-deterministic)であり、ページを更新するたびに内容が変わります。それに伴い、引用される URL も毎回変化します。

以下では、Ahrefs のデータに基づき、AI による概要で上位表示されるために分かっていることを整理していきます。

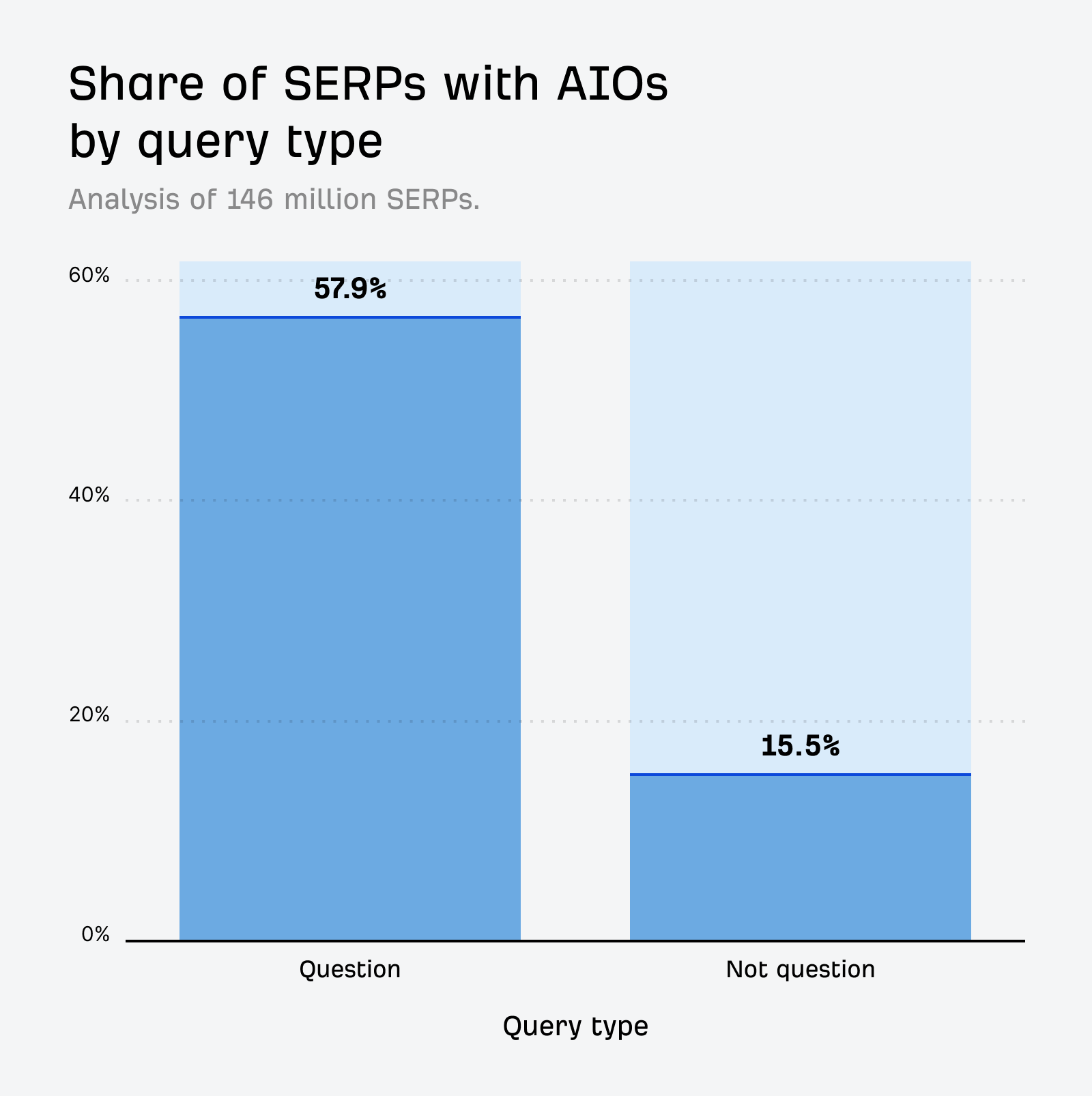

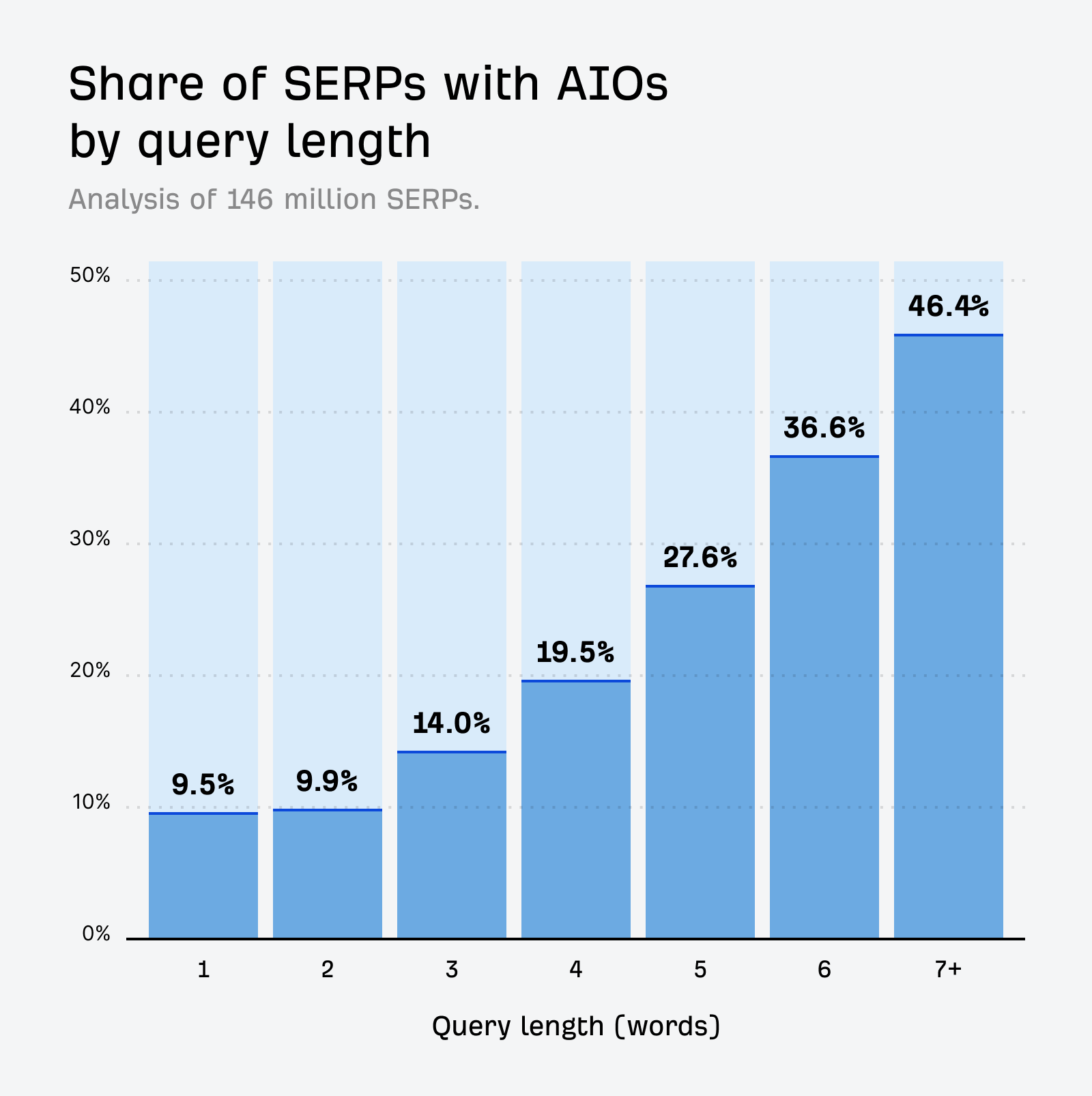

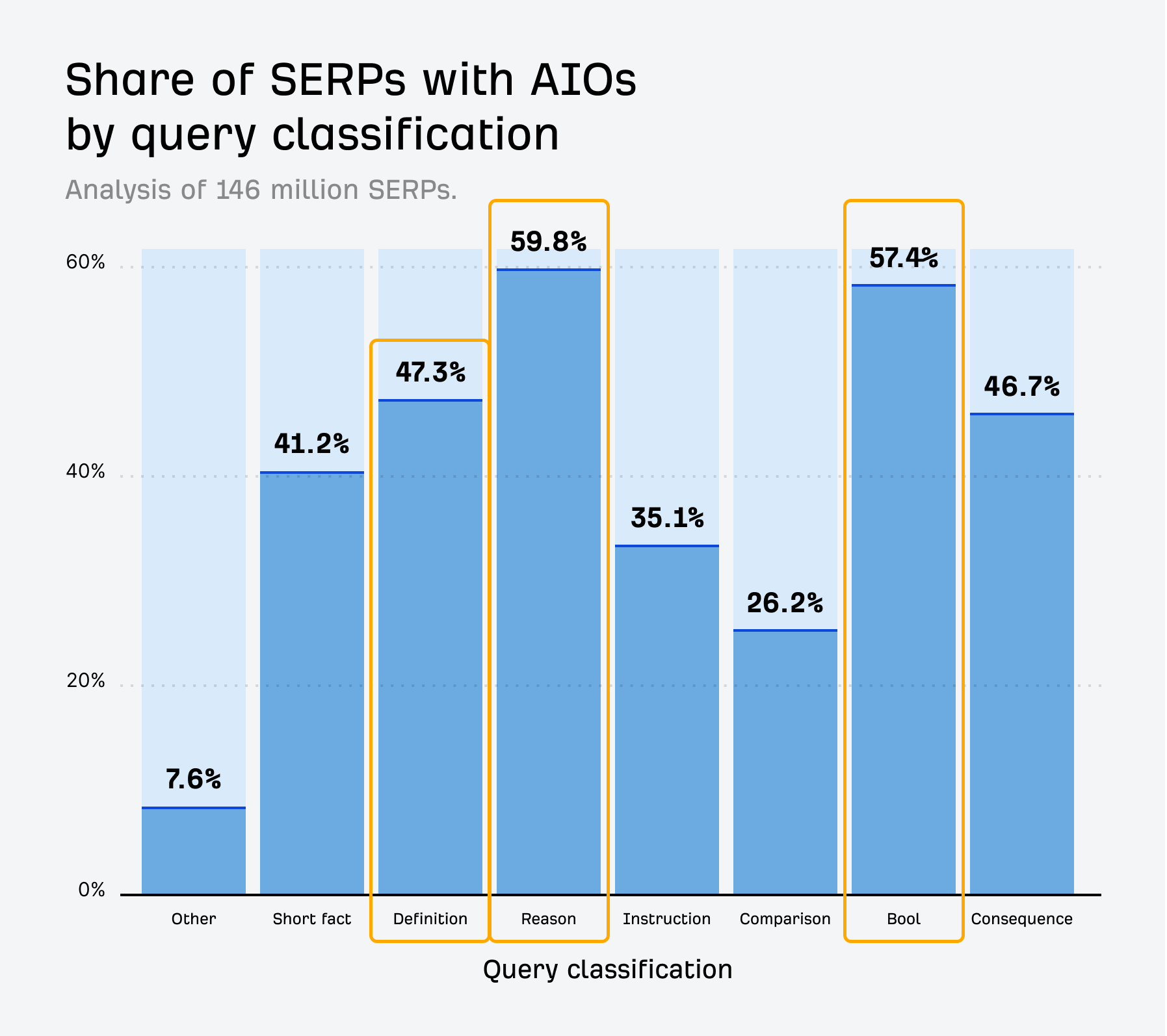

1 億 4,600 万件の SERP を分析したところ、AI による概要は全キーワードの 21% で表示されていることが分かりました。ただし、クエリの種類によって表示されやすさには大きな差があります。

たとえば、質問形式のクエリでは、AI による概要が 57.9% の割合で表示されています。

そして、7 語以上のクエリでは 46.4% です。

質問の種類も結果に影響します。なかでも「なぜ」を問う理由系のクエリは、59.8% という最も高い割合で AI による概要が表示されました。

さらに、「はい/いいえ」で答えられる質問(Bool 型)や「定義」を求めるクエリでも、AI による概要 の表示率は平均を大きく上回っており、それぞれ 57.4%、47.3% となっています。

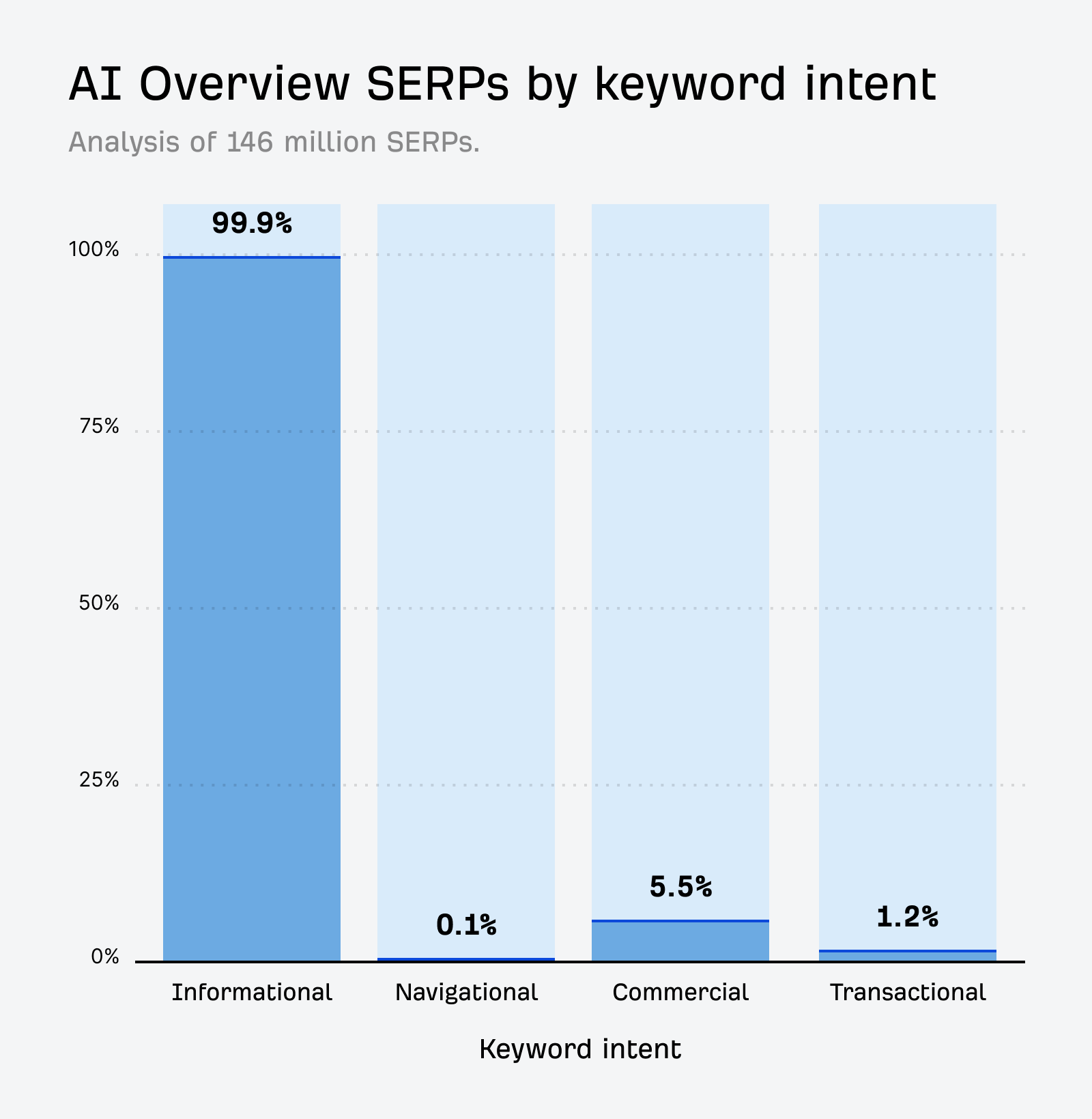

一方で、AI による概要が表示されるキーワードの 99.9% は情報収集目的(インフォメーショナル)なものです。

では、なぜこれが重要なのでしょうか。それは、どのようなクエリで AI による概要が表示されるのかを理解することで、上位表示を狙う際に、どのコンテンツタイプやトピックを狙うべきかが見えてくるからです。

たとえば、注力しているトピックがすべて情報提供型であれば、AI による概要との競合は増えますが、その分、引用される機会も多くなります。

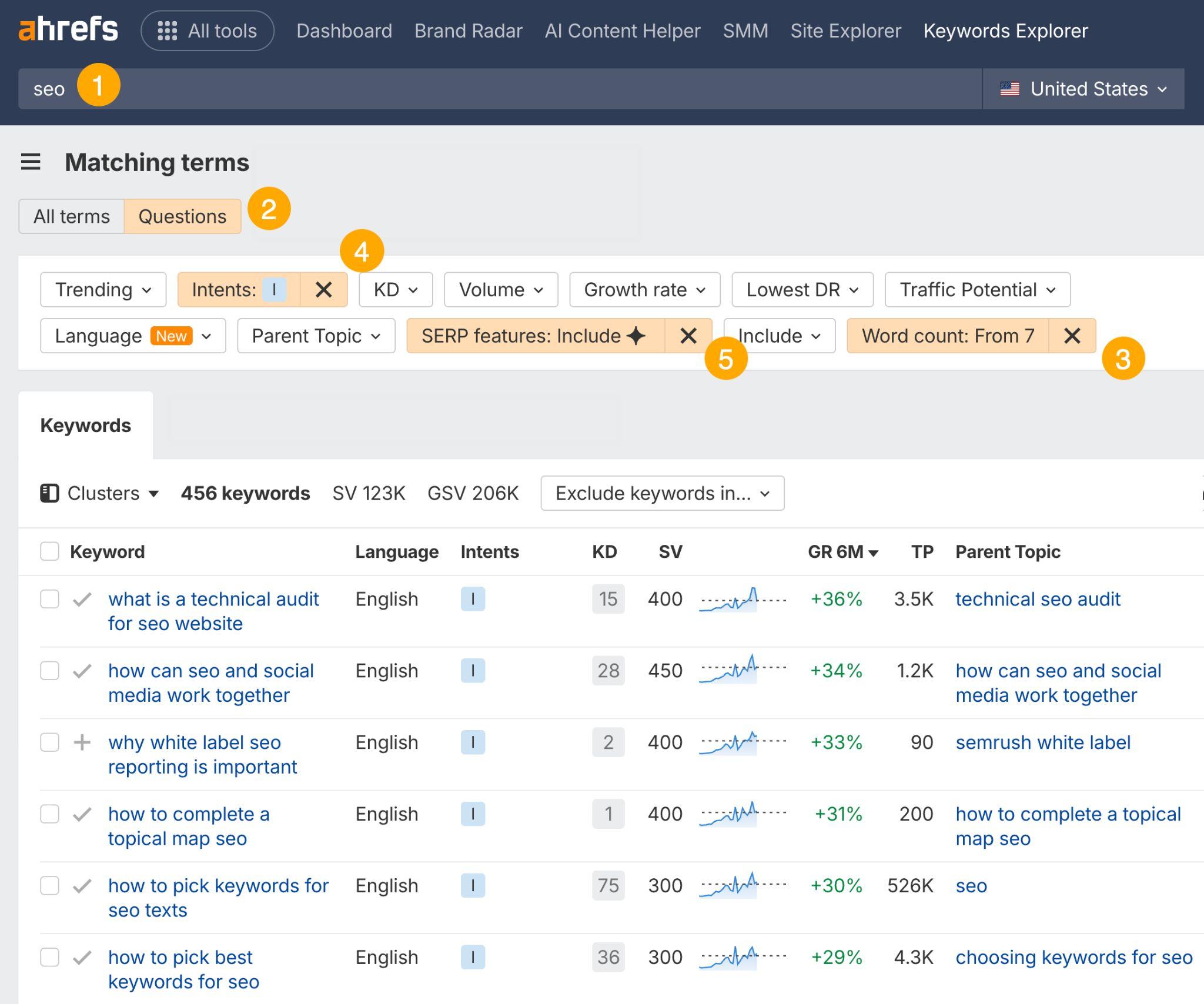

まずは Ahrefs の キーワードエクスプローラーを使用して、自社の業界(①)における質問形式のキーワード(②)を調べることから始めてみましょう。

次に、7 語以上のクエリ(③)と情報収集の意図(④)でフィルタリングし、どれがすでに AI による概要 を発動させているか(⑤)を確認します。

こうした情報収集目的の質問型トピックを多く押さえるほど、AI による概要内での可視性は高まります。

従来の検索結果で表示されていなければ、AI による概要に表示される可能性は低くなります。

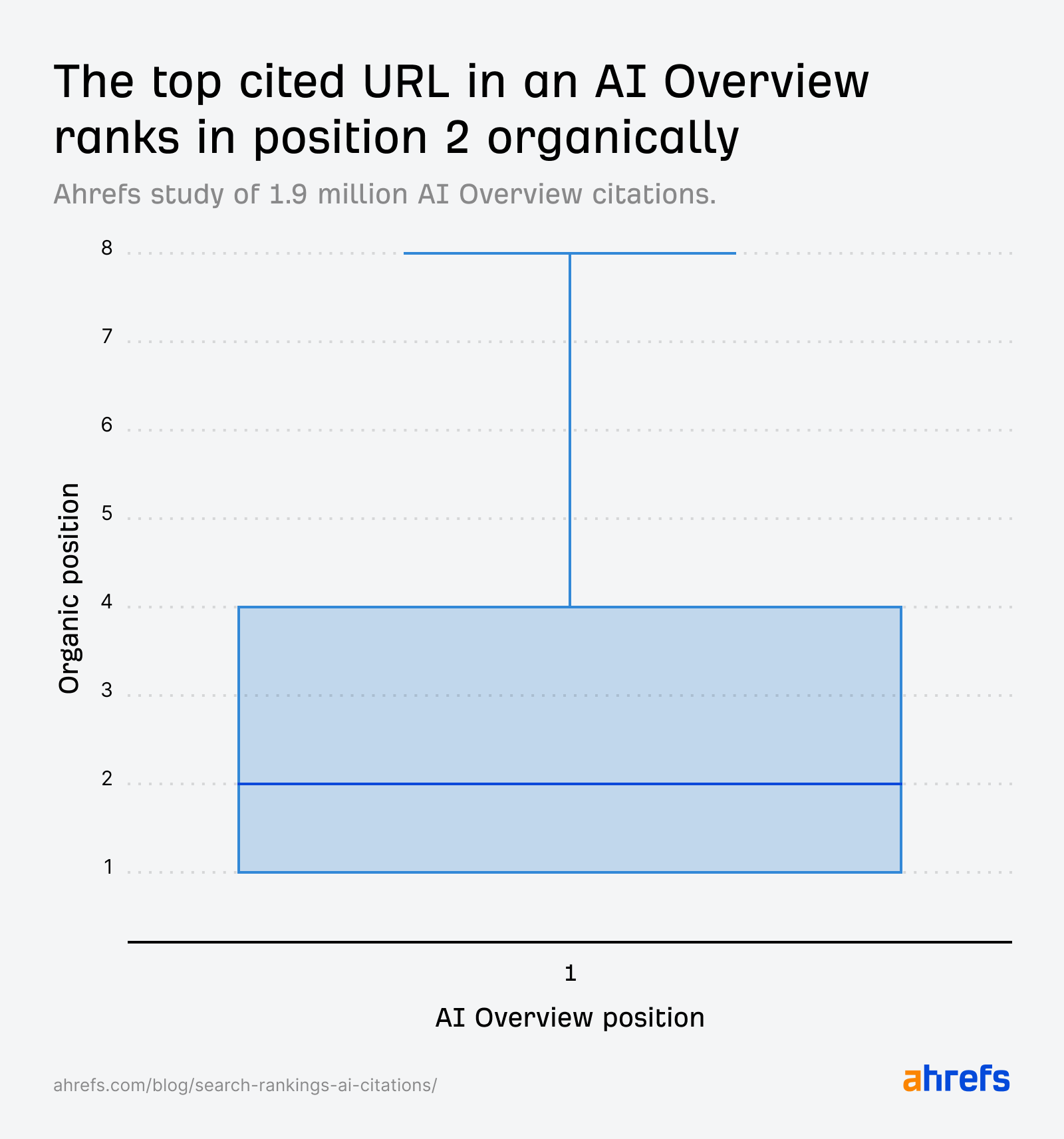

Ahrefsが 190 万件の AI による概要における引用データを分析したところ、その 76% は従来の検索結果でも上位 10 位以内にランクインしており、最も多く引用されている URL の中央値は 2 位でした。

これは AI システムの仕組みを考えれば理にかなっています。AI は検索エンジンのインデックスから情報を引き出し、学習データを補完する検索拡張生成(RAG)を利用しているからです。

Google の従来の検索でコンテンツが表示されていなければ、AI による概要に表示される可能性も低くなります。

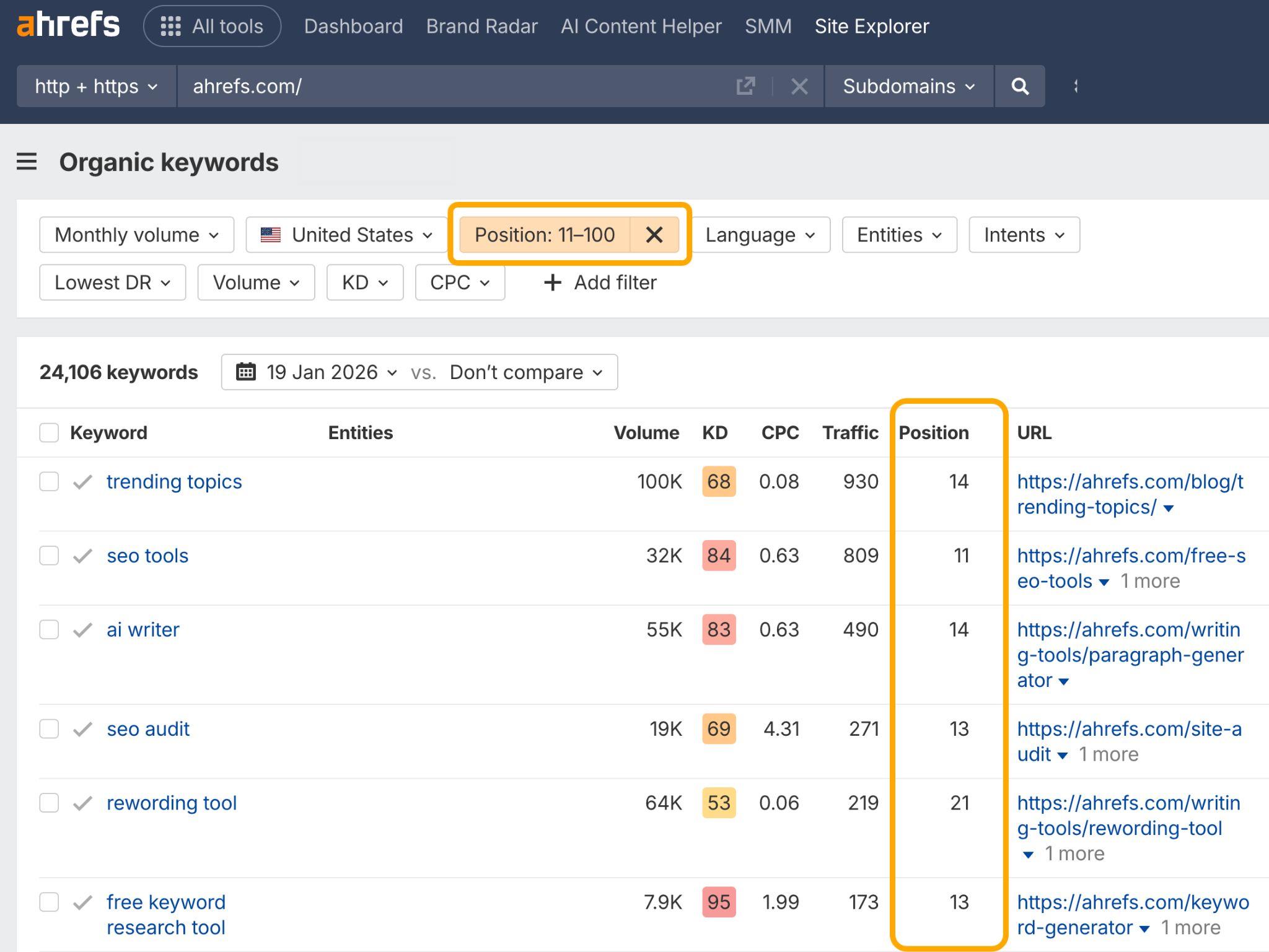

Ahrefs の サイトエクスプローラー内にある「オーガニックキーワード」レポートを使って、対象ページが関連キーワードで何位にランクインしているかを確認してください。

もしトップ 10 圏外であれば、まずはそれらの順位を上げることに集中しましょう。

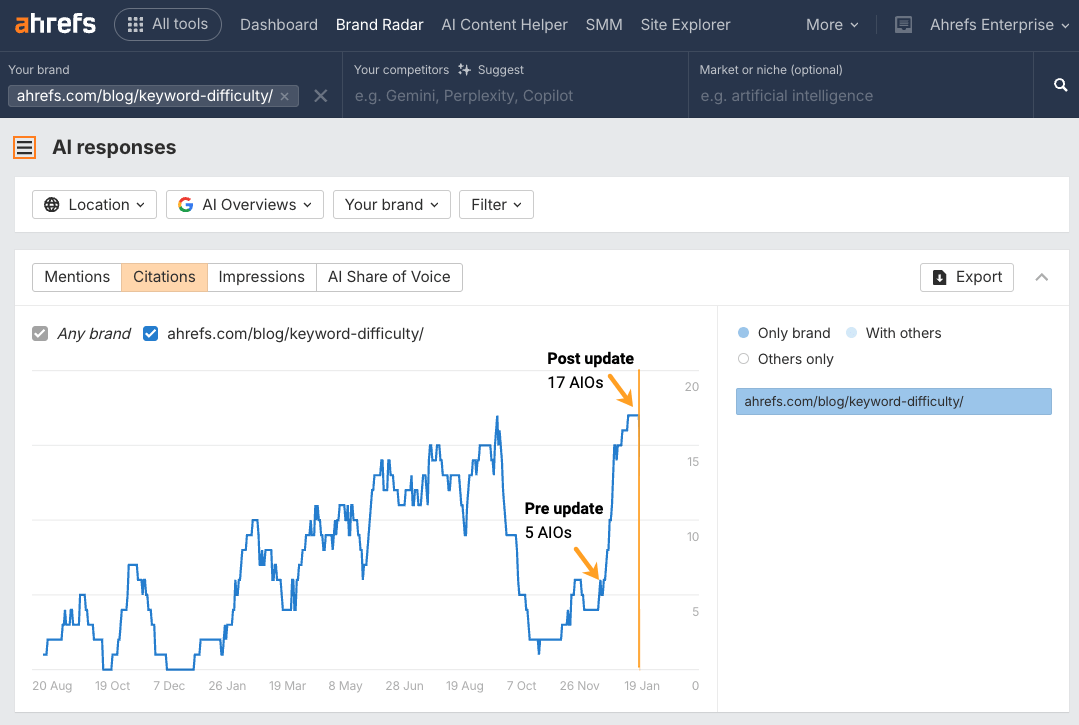

次に、Ahrefsのブランドレーダーを使って対象ページを追跡し、検索で行った最適化が AI による概要での可視性にも波及効果をもたらしているかを確認しましょう。

たとえば、あるブログ記事を更新し、最適化を見直したところ、12 件の AI による概要への掲載を再び獲得することができました。

AI による概要は、ブログの長さを気にしているわけではありません。重視しているのは、コンテンツが検索クエリにどれだけ的確に答えているかです。

Ahrefs の調査では、文字数と AI による引用との間に相関はほとんど見られませんでした(スピアマン相関係数は約 0.04)。

重要なのは、ユーザーの疑問に対する答えを、できるだけ早い段階で、直接的に提示することです。結論を後回しにすると、LLM(大規模言語モデル)がコンテンツの意味を理解するまでに余計な時間がかかってしまいます。

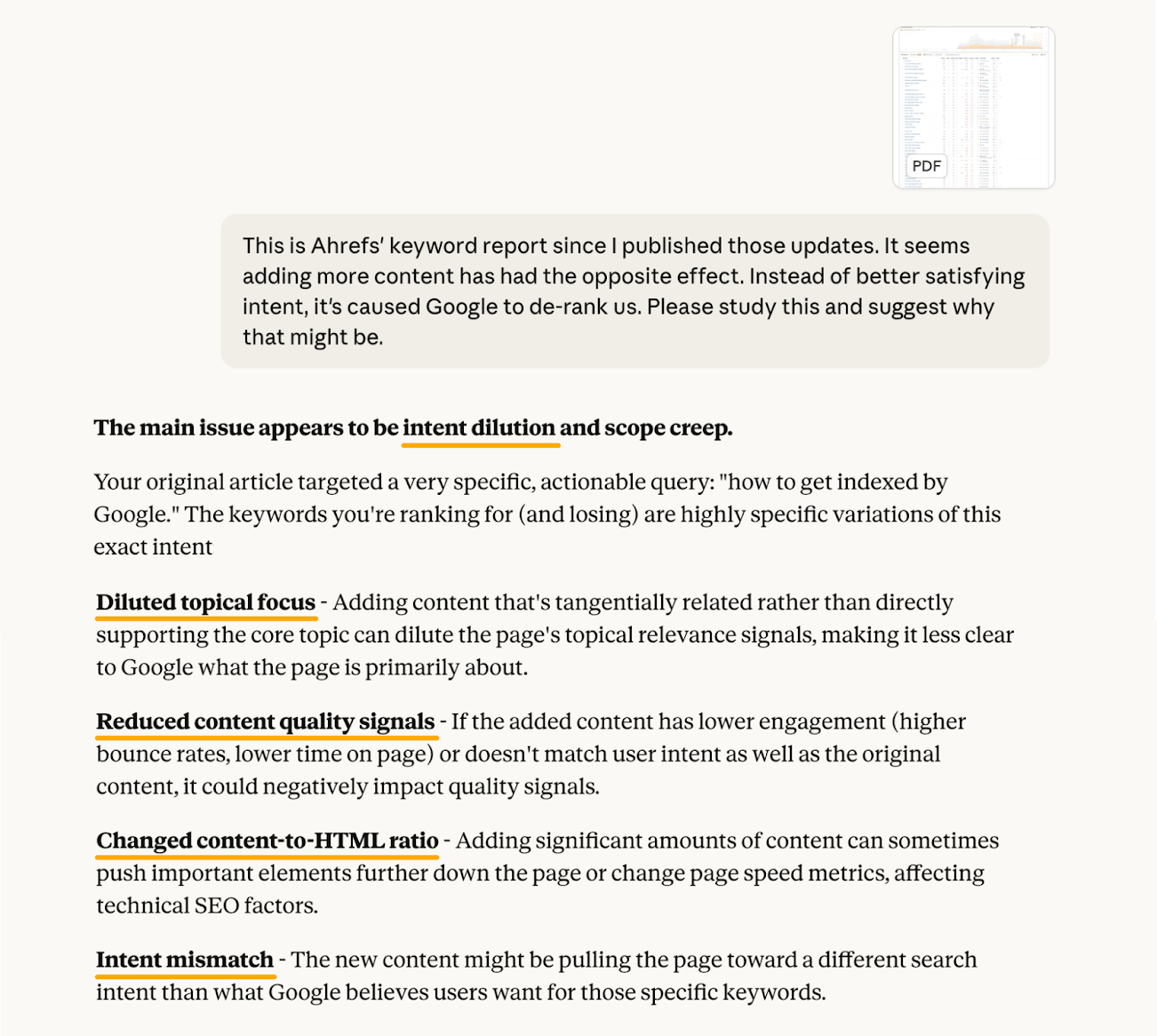

たとえば数か月前、パフォーマンスが落ちていたある記事を更新しました。情報を追加し、トピックの抜けを埋め、全体としてより網羅的にしたつもりでした。

しかし、後で確認すると、トラフィックは以前よりもさらに減少していました。

Ahrefs のページ検査、キーワードエクスプローラーのデータ、そして Claude の助けを借りて分析した結果、不要な情報を追加しすぎたことで、元々のコンテンツが持っていた強みや切れ味を薄めてしまっていたことに気づきました。

クエリにより的確に答えるつもりでブログを編集した一方で、関連はしているものの本筋からは少し外れたトピックについても新たなセクションを追加していました。

しかし、比較的シンプルな質問に対して、それが結果的に情報過多になってしまいました。

意図せずフォーカスを弱め、検索意図とのズレを生み、重要な情報をページの下のほうに埋もれさせてしまっていたのです。

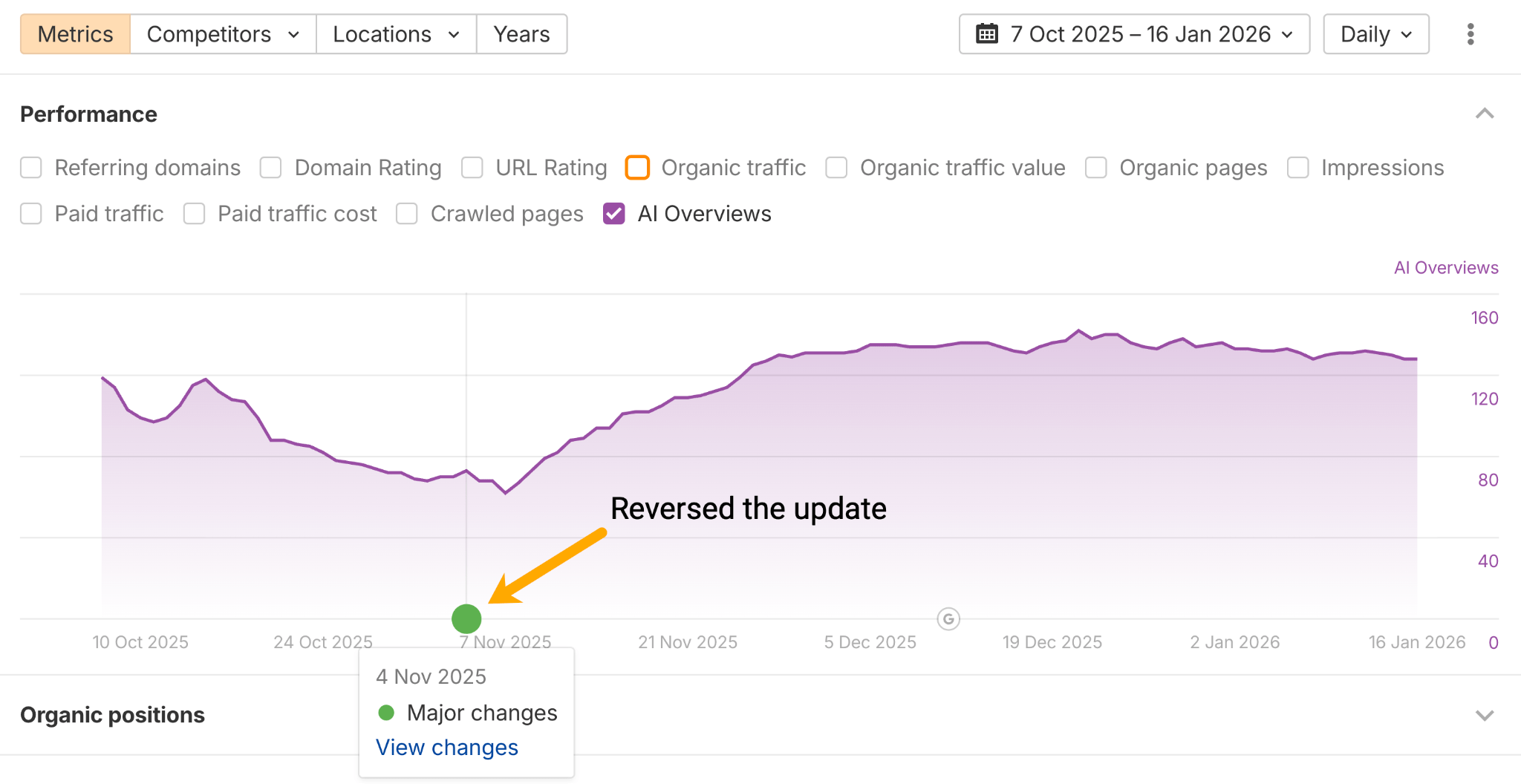

更新内容を元に戻したところ、すぐに AI による概要での可視性はすぐに回復し始めました。

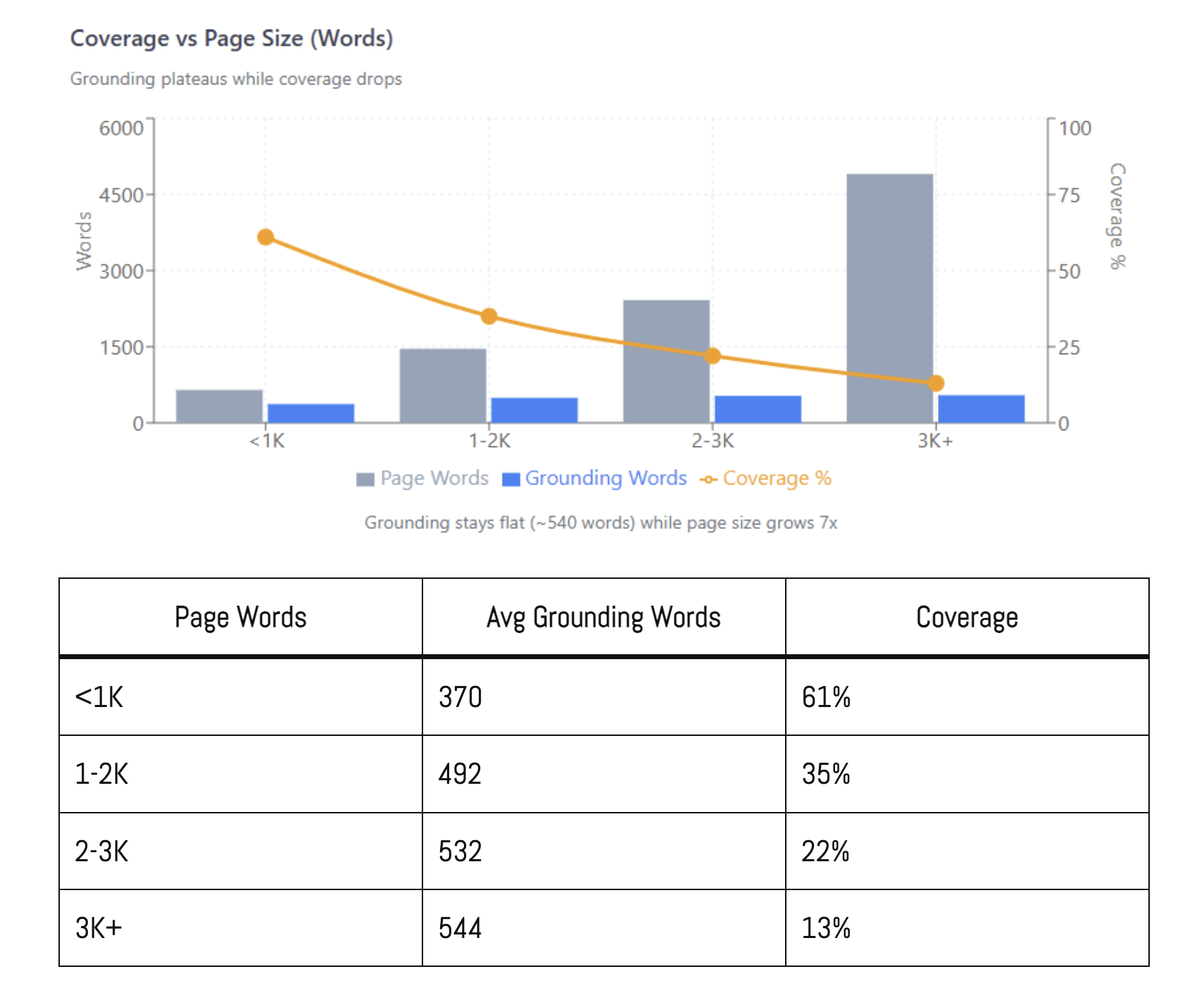

ダン・ペトロヴィックさんによる Google の「グラウンディング」(AI による概要を生成する際に Google が参照する SERP 上の参照コンテンツ)に関する最新の調査では、検索意図の希薄化が現実的な問題であることが指摘されています。

7,000 件以上のクエリを分析した結果、グラウンディングの効果は約 540 語で頭打ちとなり、2,000 語を超えるページでは、文字数を増やしても効果が次第に薄れていくことが分かりました。

「コンテンツを追加すればするほど、選ばれる情報量が増えないまま、カバー率だけが薄まっていきます。この結果から導かれるコンテンツ戦略は明確です。重要なのは長さではなく密度。最も長いページを目指すのではなく、特定のクエリに対して最も関連性の高い情報源になることに集中すべきです。」

この話の教訓は、特定の文字数を目標にしたり、単に保険としてコンテンツを増やしたりするべきではない、ということです。トピックと検索意図に基づいて、書くべき分量を決めましょう。

適切な検索意図に合わせて最適化するための代表的なアプローチが 3 つあります。

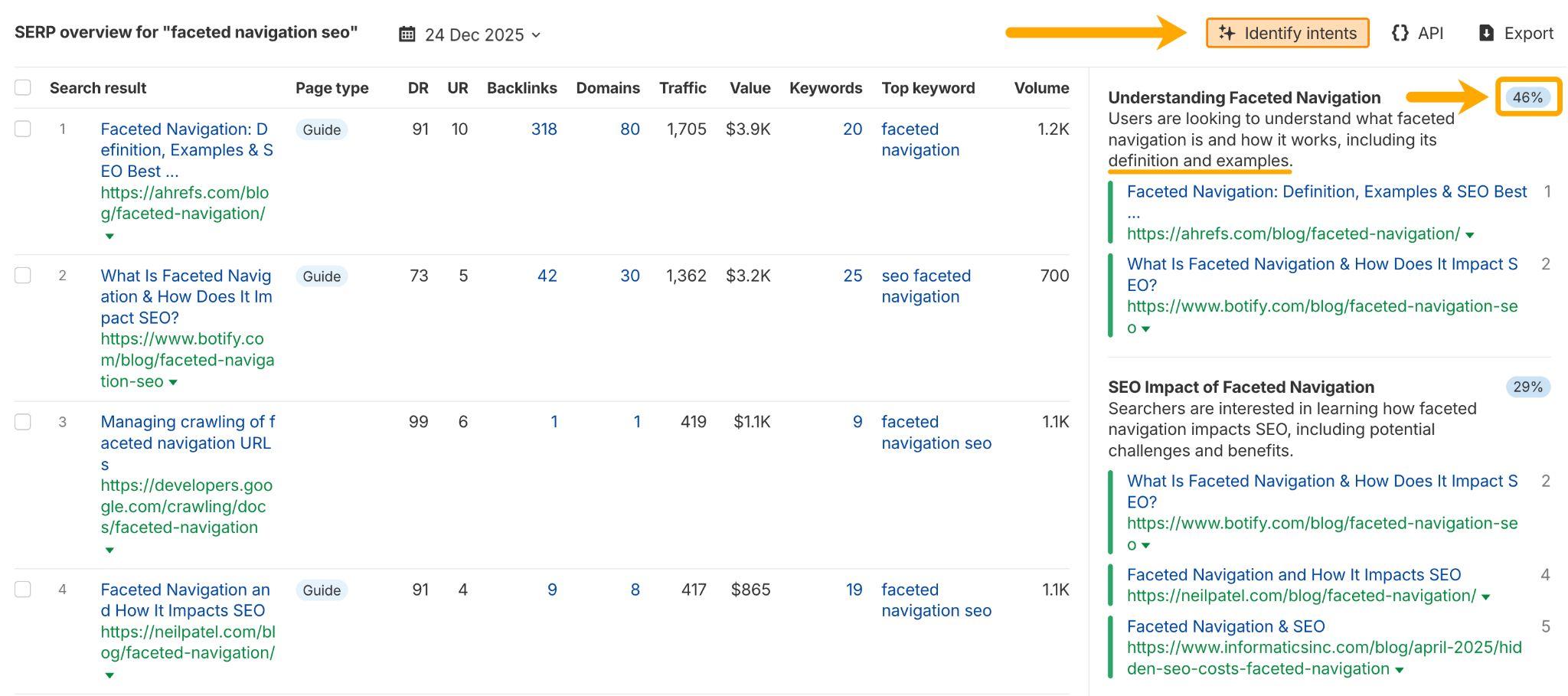

1. キーワードエクスプローラー の「意図を特定する」ツールを使って、SERP における検索意図の内訳を確認します。たとえば、「ファセットナビゲーション SEO」というクエリの検索結果の 46% は、ユーザーがファセットナビゲーションを理解するのに役立つ定義解説や事例ガイドです。そのため、上位表示を狙い、AI による概要に掲載されるチャンスを得るには、こうしたタイプのコンテンツを作成するのが適切です。

2. Ahrefs の AI コンテンツヘルパーで主要な検索意図を選び、トピックの提案に沿って執筆します。

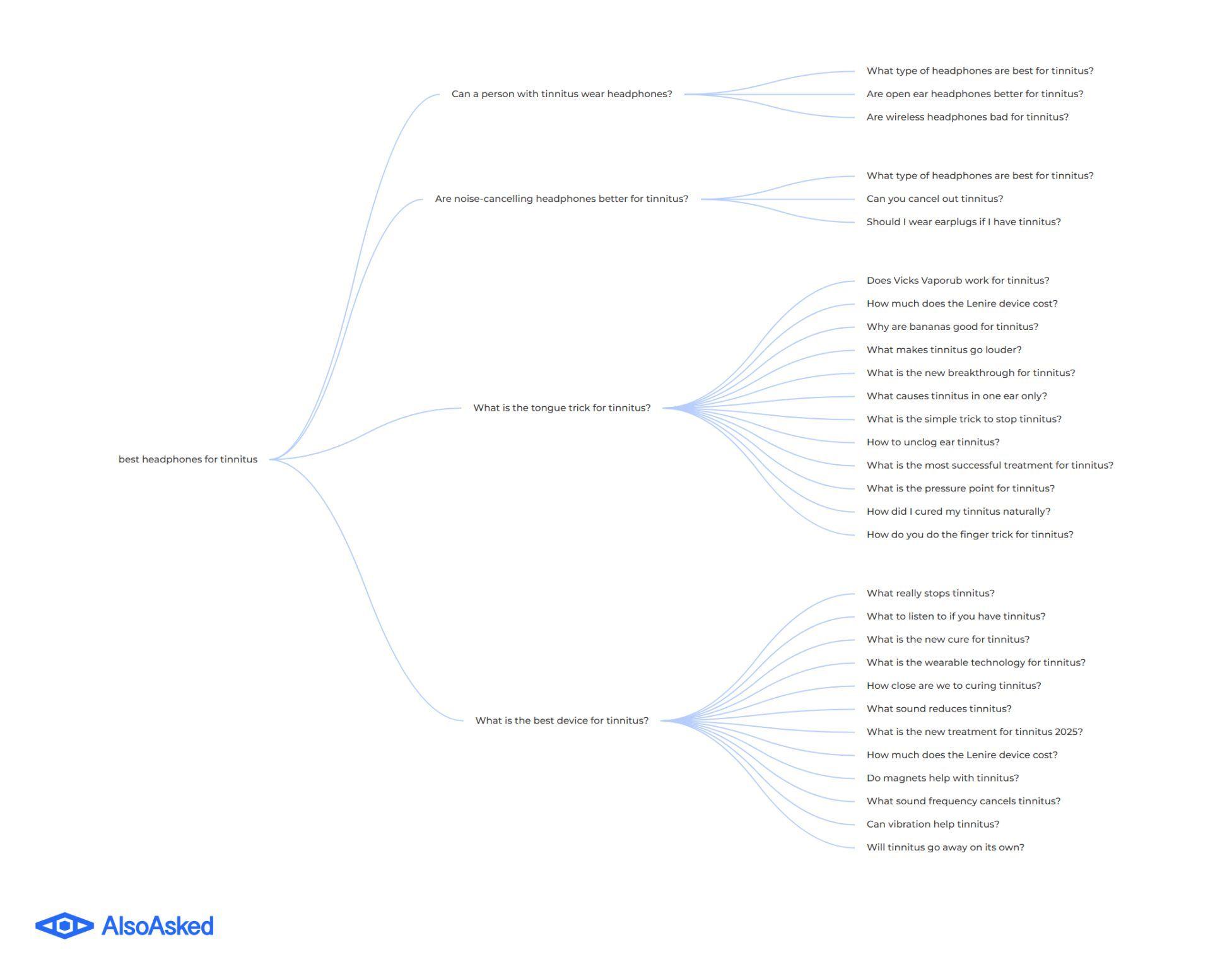

3. AlsoAsked や AnswerThePublic などのツールを使って、ショートテールキーワードの背後にある質問を見つけ、検索時にユーザーが本当に知りたいことをより深く理解します。

ある研究結果によると、「ファンアウトクエリ(fan-out query)」の SERP により多く表示されることで、AI による概要での上位表示を改善できる可能性があります。

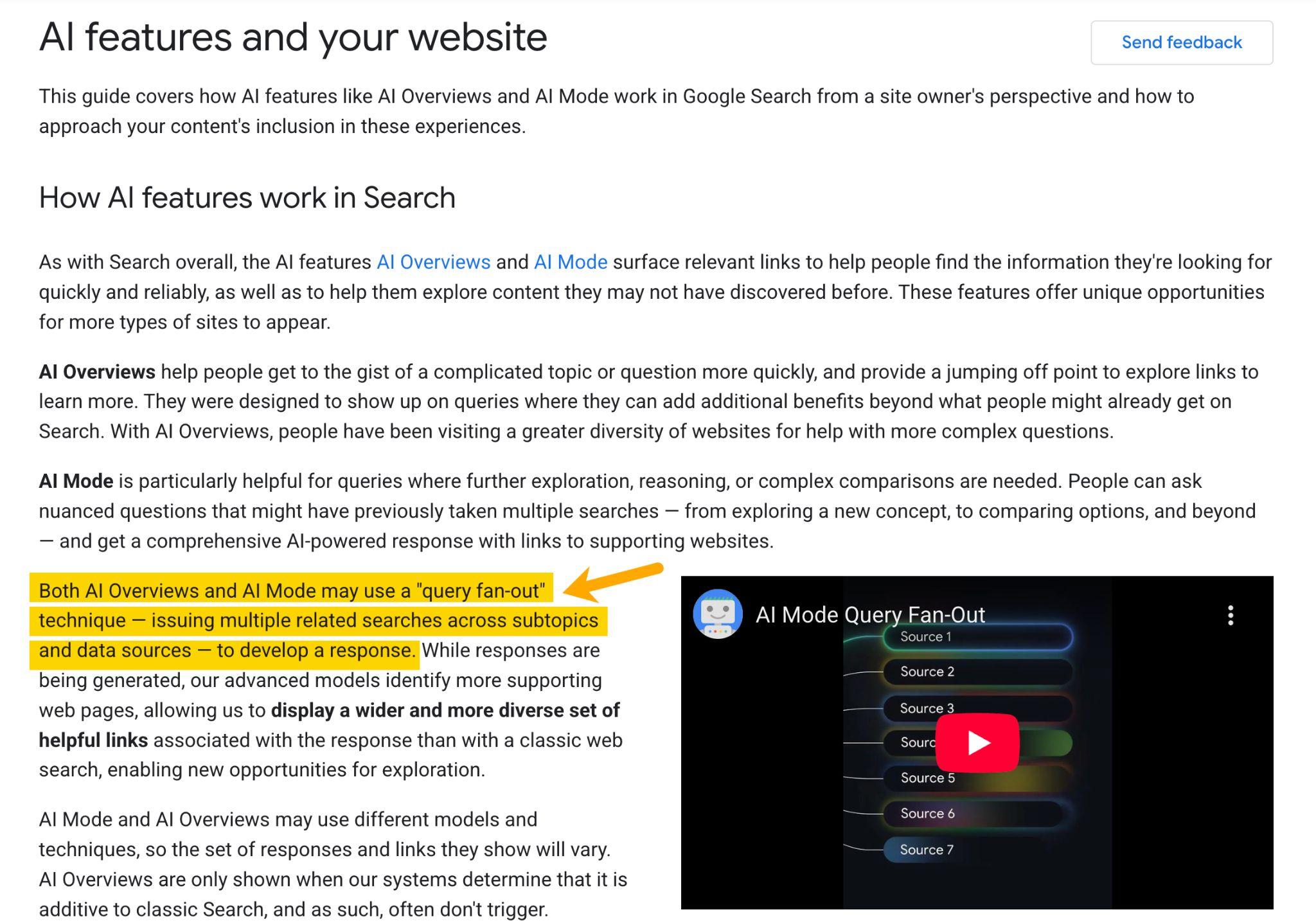

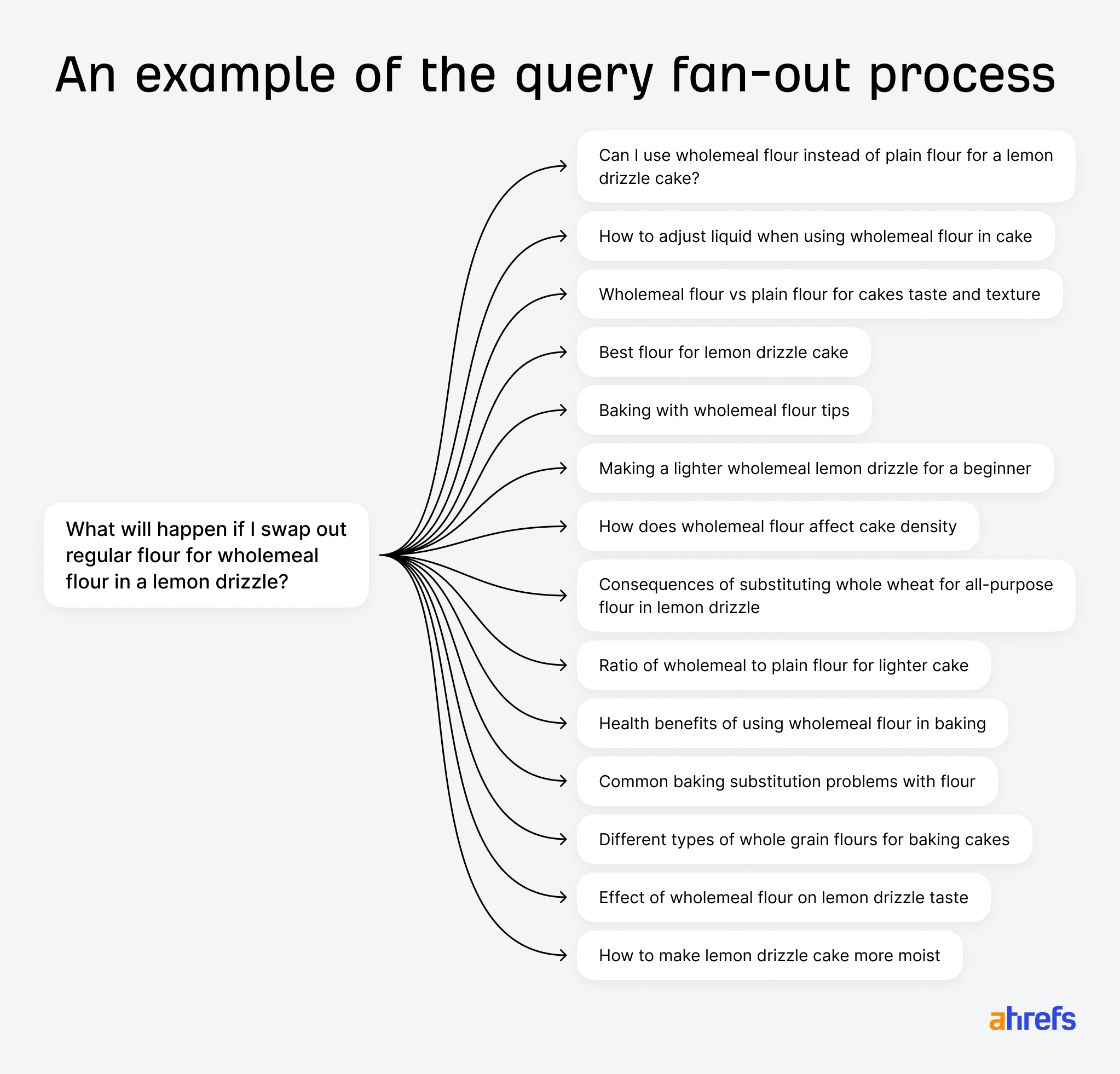

では、ファンアウトクエリとは何でしょうか。 Google の公式ドキュメントによると、ユーザーが Google で検索を行い AI が作動した場合、システムは「クエリのファンアウト(Query fan-out)」を実行し、1 つの検索クエリを複数の関連するサブクエリに分解します。

例えば「レモンドリズルケーキを作る際、薄力粉を全粒粉に置き換えたらどうなるのか」といいったユーザーの質問に対して、AI は「レモンドリズルケーキに最適な粉」「全粒粉がケーキの触感や密度に与える影響」「全粒粉でお菓子を焼く際のコツ」といった複数のファンアウトクエリを生成する可能性があります。

これにより、AI Overviews を支えるモデルである Gemini は、トピックのさまざまな切り口を検討し、複数のサイトから関連する記述を取得して回答を構成できるようになります。

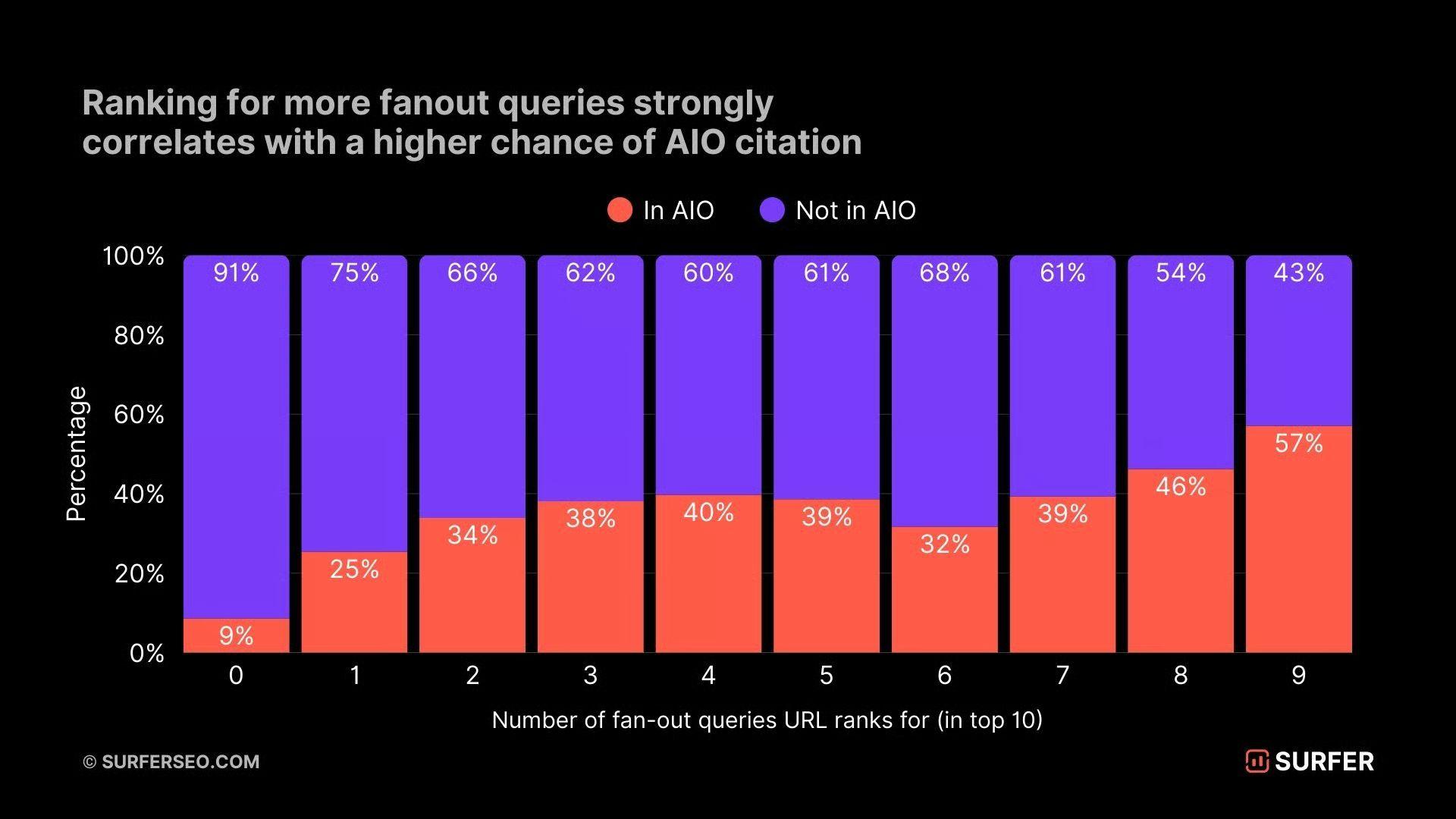

Ahrefs の元メンバーであるジョシュア・ハードウィックさんは、SurferSEO と共同で AI による概要におけるファンアウトクエリの挙動を調査しました。その結果、こうしたファンアウトクエリ全体で上位表示されているページは、主要な検索語句だけで上位表示されているページに比べて、最終的な AI Overview で引用される可能性が 161% 高いことが分かりました。

さらにこの調査では、ファンアウトクエリでの順位と AI による概要で引用されることとの間に、スピアマン相関係数 0.77 という非常に強い相関があることも示されています。

明らかなのは、AI による概要で上位表示されるかどうかは、特定のキーワードではなく、トピックに対する深い専門性や権威性、いわゆるトピックオーソリティを構築できているかにかかっています。

個々のキーワードや単発の引用に過度にとらわれる必要はありません。狙っているトピックの複数の側面を網羅するコンテンツを書くことで、ファンアウトクエリの SERP に表示される可能性を高めることができます。

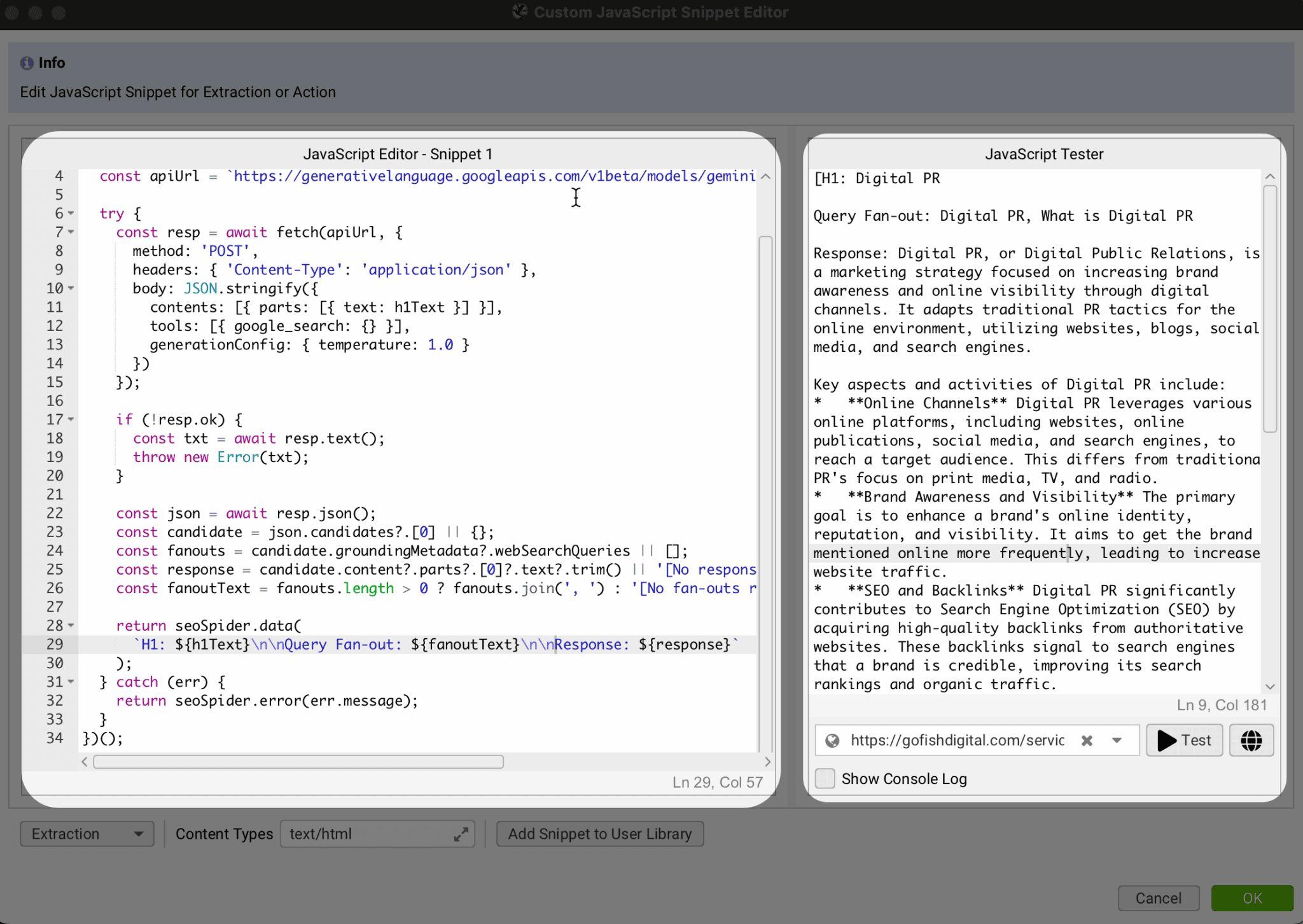

その実践的な方法のひとつが、ファンアウトクエリを直接最適化することです。これは GoFish Digital のダン・ヒンクリーさんが実際に行っているアプローチでもあります。

Gemini API と Screaming Frog を使って Google のファンアウトクエリを抽出することで、ヒンクリーさんは以下の処理を行う Python スクリプトを作成しています。

- サイトの特定のページ(例:

/blog/サブフォルダー)をクロールする - Screaming Frog を使用して各ページの H1 を抽出する

- 抽出した H1 を Gemini に送信する

- 各 H1 について、AI による概要の回答と関連するファンアウトクエリの一覧を取得する

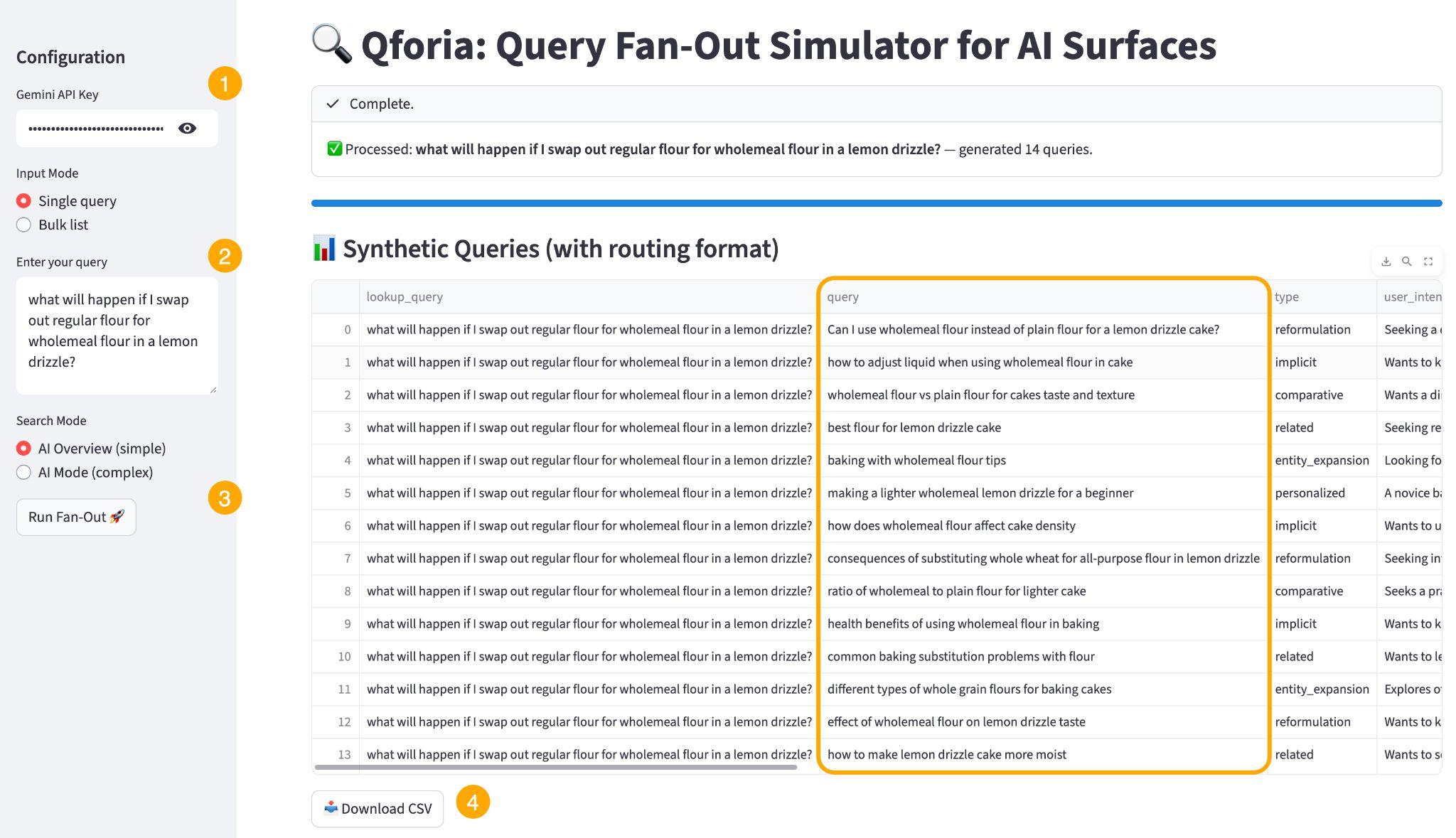

AI による概要のファンアウトを抽出する方法は、他にもあります。なかでも、より簡単に試せるのが Qforia です。

Qforia は、AI エキスパートであり iPullRank の創設者であるマイク・キングさんが開発した無料ツールです。

このツールは、Google の公式な情報取得に関する特許に基づいてモデル化されており、Gemini 自身を使ってファンアウトクエリを生成するという点で、Gemini のファンアウトプロセスを実質的に再現しています。

最適化したいキーワードを入力し(①)、無料の Gemini API キーを貼り付けて(②)、「Run fan-out」をクリックするだけです(③)。

次に「Download CSV」をクリックし(④)、取得したより詳細なサブクエリをもとにコンテンツの最適化を進めます。

ファンアウトクエリを既存のコンテンツに紐づけることで、トピックの抜け漏れを見つけやすくなり、Gemini が探索しうるあらゆる切り口をカバーしながら、関連クエリ全体にわたってトピックの権威性を構築できます。

ここからは、トピックレベルでの専門性と権威性を高めるためのポイントを、もう 3 つ紹介します。

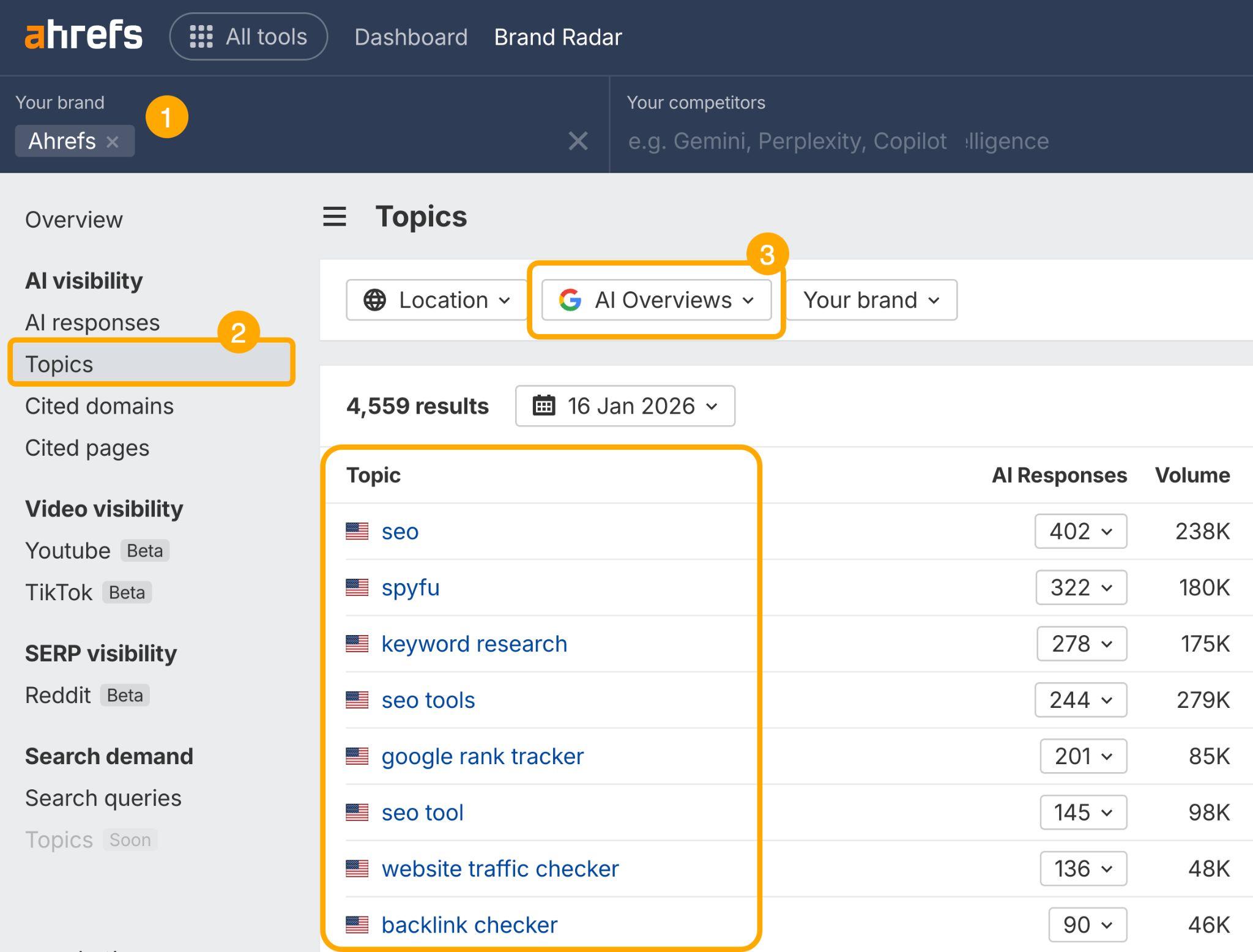

1. AI による概要が現在、自社ブランドをどのトピックに関連付けているかを確認する

ブランドレーダーに自社ブランドを登録し、「トピック」レポートに移動して、AI による概要が現在どのようなテーマとブランドを関連付けているかを確認できます。

次に、狙っているトピックにおける専門性や権威性と、AI の認識とのギャップを洗い出します。

2. AI による概要におけるトピックとエンティティのギャップを確認する

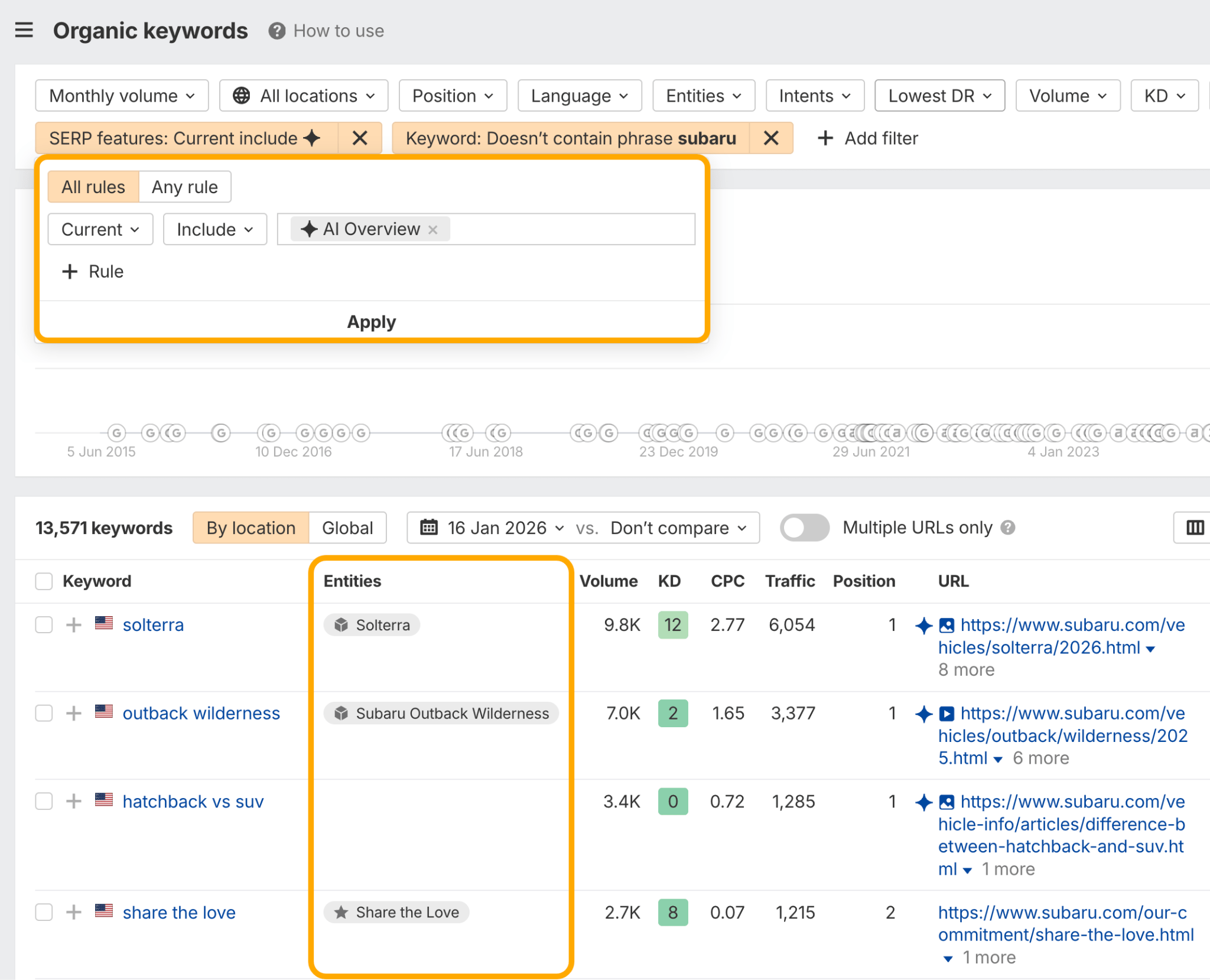

ここでは、Entain のグローバル SEO ヘッドであり、元 NASA の SEO ヘッドでもあるロドリゴ・ストックブランドさんによる実用的なワークフローを紹介します。

まず、サイトエクスプローラーの「オーガニックキーワード」レポートを使い、ブランド名を含まない AI による概要キーワードとエンティティをエクスポートします。

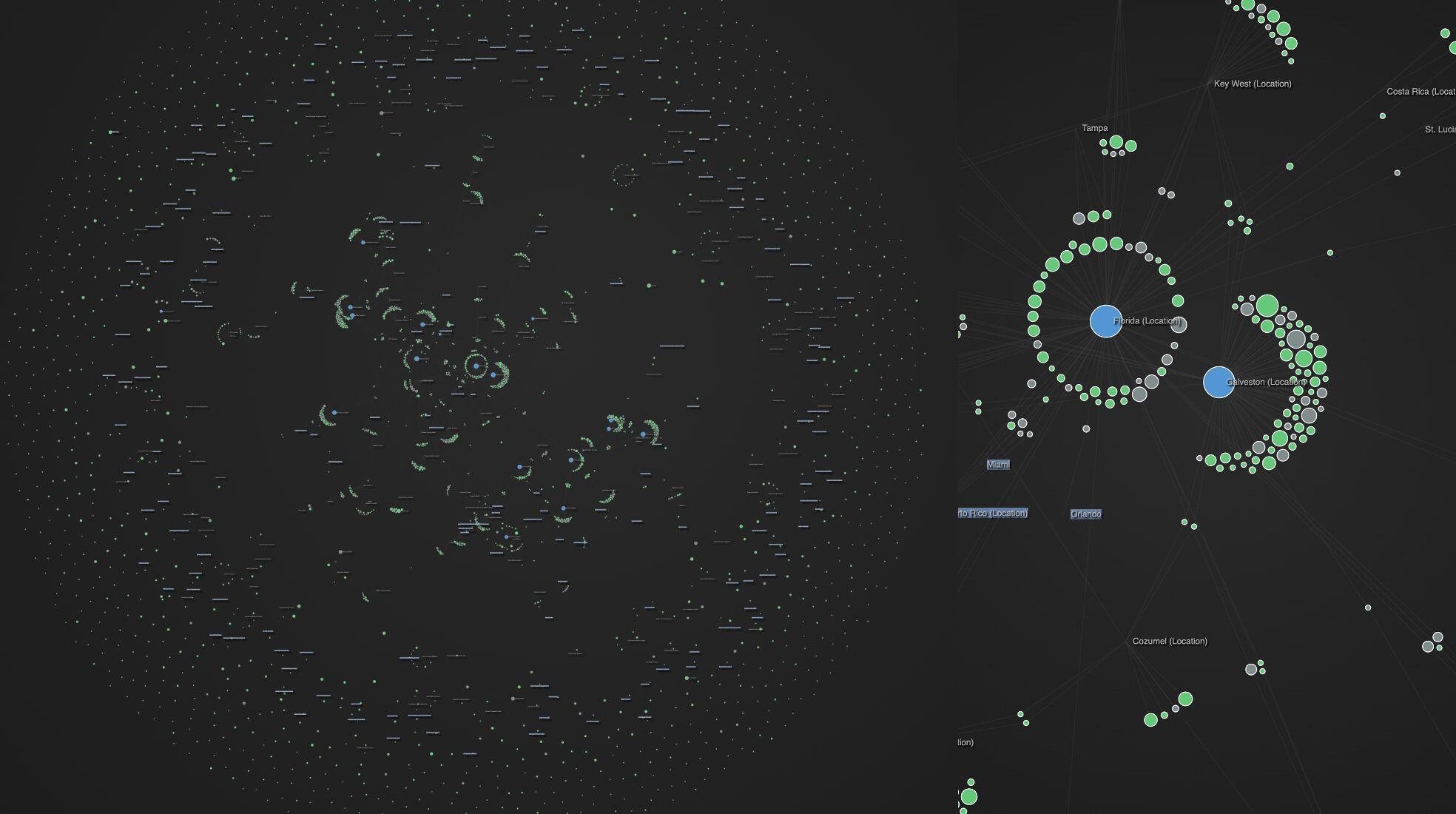

次に、Poe や AI Studio を使ってネットワークグラフを作成し、AI による概要に表示されているエンティティのクラスターと、表示されていないクラスターを可視化します。

- 青い円:他のキーワードがつながっている主要エンティティ

- 灰色の円:AI による概要では言及または引用されていない関連キーワード

- 緑の円:AI による概要で言及または引用されている関連キーワード

- 円のサイズ:該当キーワードの月間検索ボリューム

ストックブランドさんは現在、このエンティティ監査を通じて、灰色の円を緑の円へと変えていく取り組みを進めています。そのワークフローを再現する方法は以下の通りです。

3. コンテンツクラスターを構築する

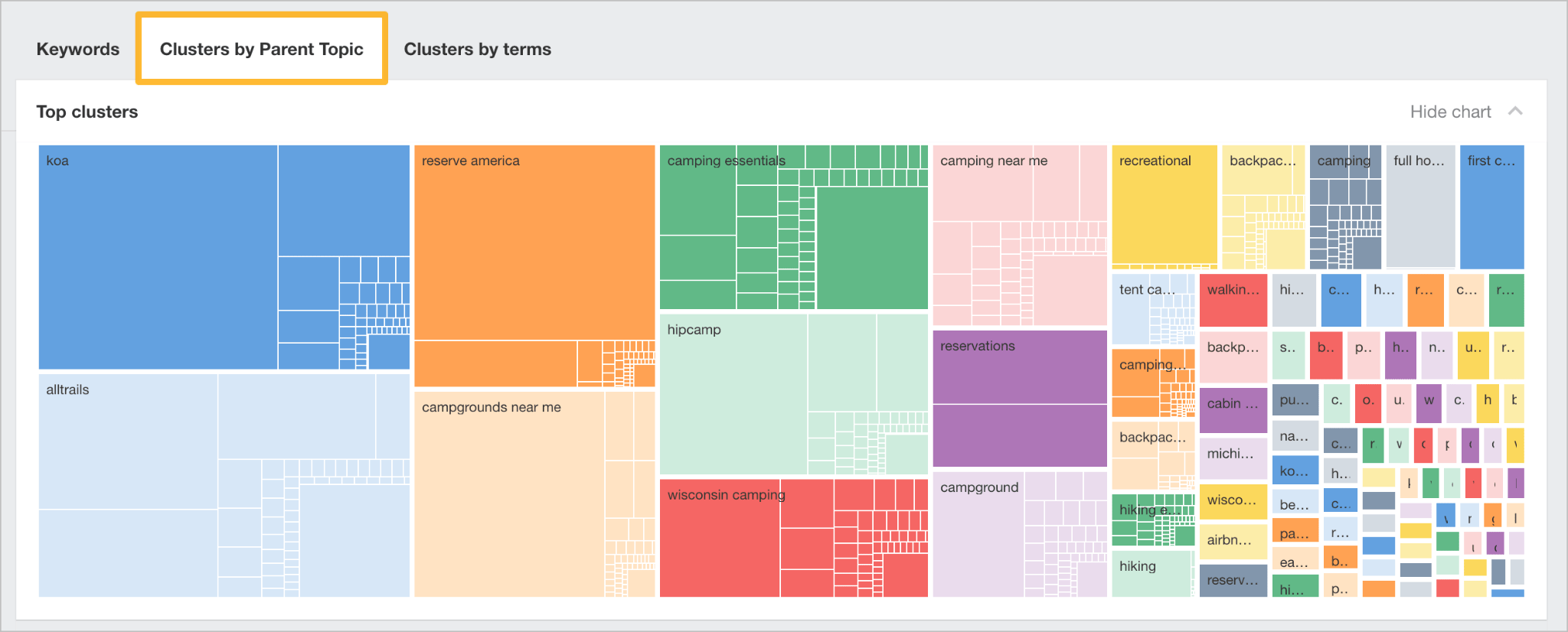

キーワードエクスプローラーの「親トピック」は、1 つのコンテンツでまとめて狙える可能性のあるキーワードを把握できます。

これを活用して、単一のキーワードではなく、関連するテーマごとにコンテンツを見つけ、クラスター化します。

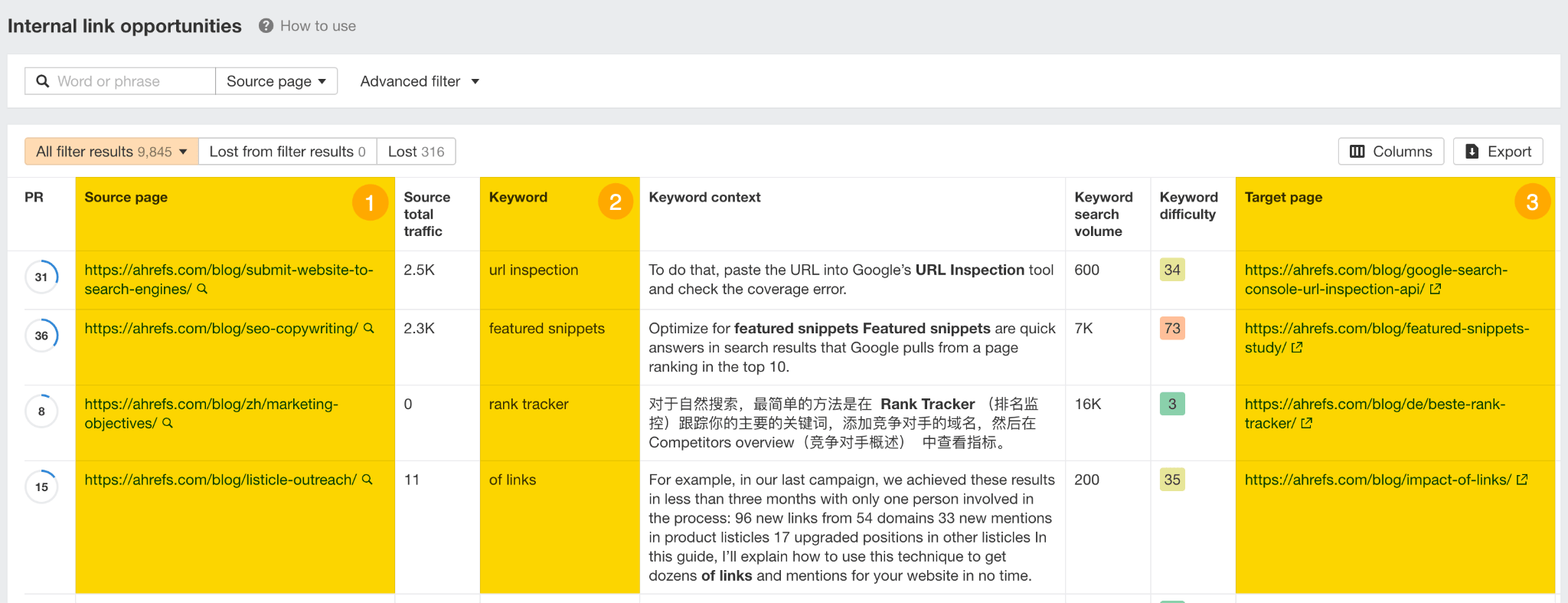

コンテンツクラスターを構築し、既存のクラスターも最適化できたら、サイト監査の「内部リンクの機会」レポートを使用して、各ページ同士の関連性をさらに強化します。

このレポートは、各ページの上位 10 キーワードをもとに、それらが他のページ内で言及されている箇所を見つけ、すぐに使える内部リンクの候補を提示してくれます。

AI による概要は、記事、動画、フォーラムなど、ウェブ上の様々な場所で広く認知されているブランドを好む傾向があります。

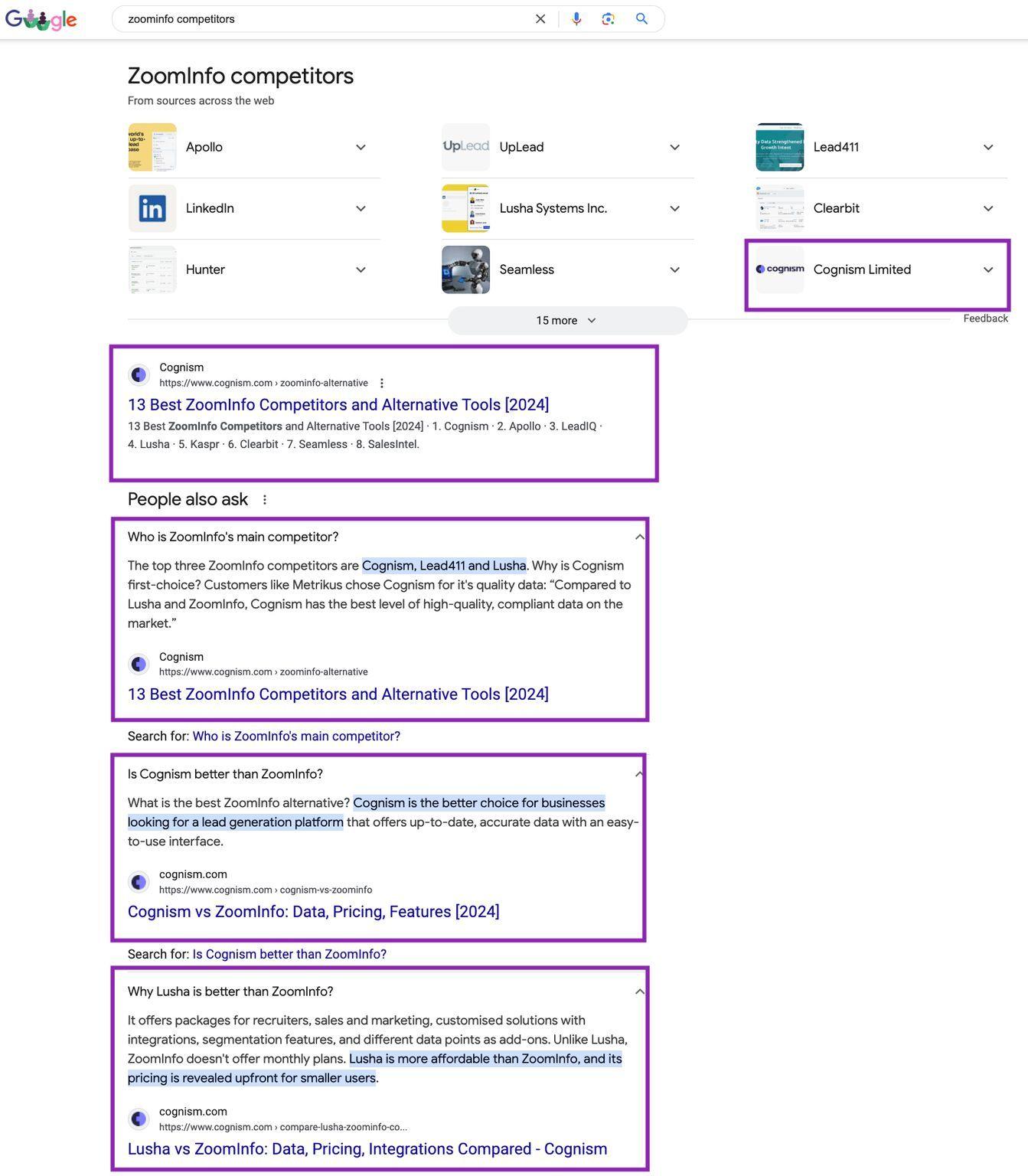

だからこそ「サラウンドサウンド SEO」が重要になります。高い検索意図を持つ検索結果ページ(SERP)における自社の表示領域を最大化するためです。

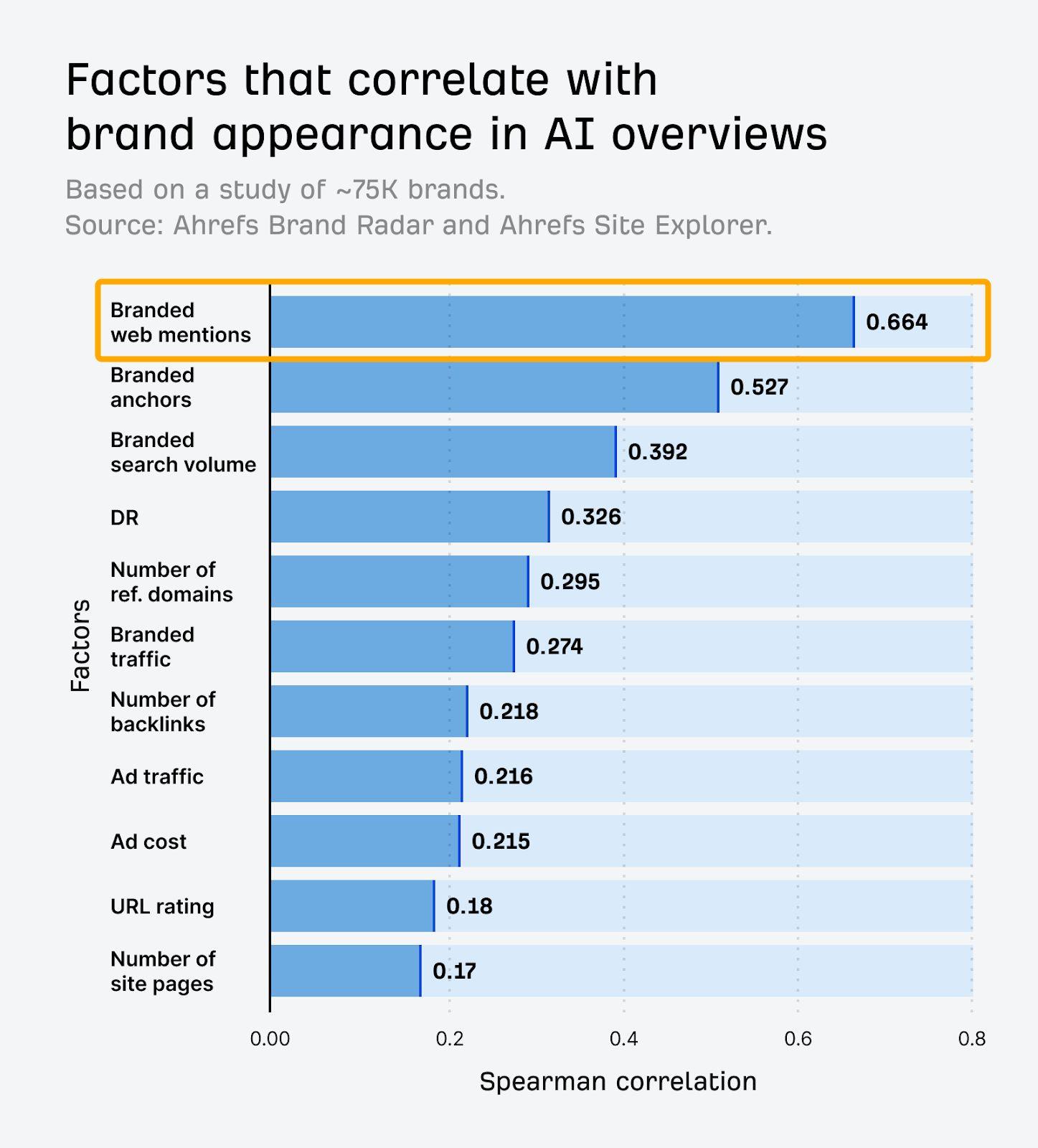

自社ブランドにメンションしている媒体が多ければ多いほど、AI による概要でメンションまたは引用される可能性も高まります。

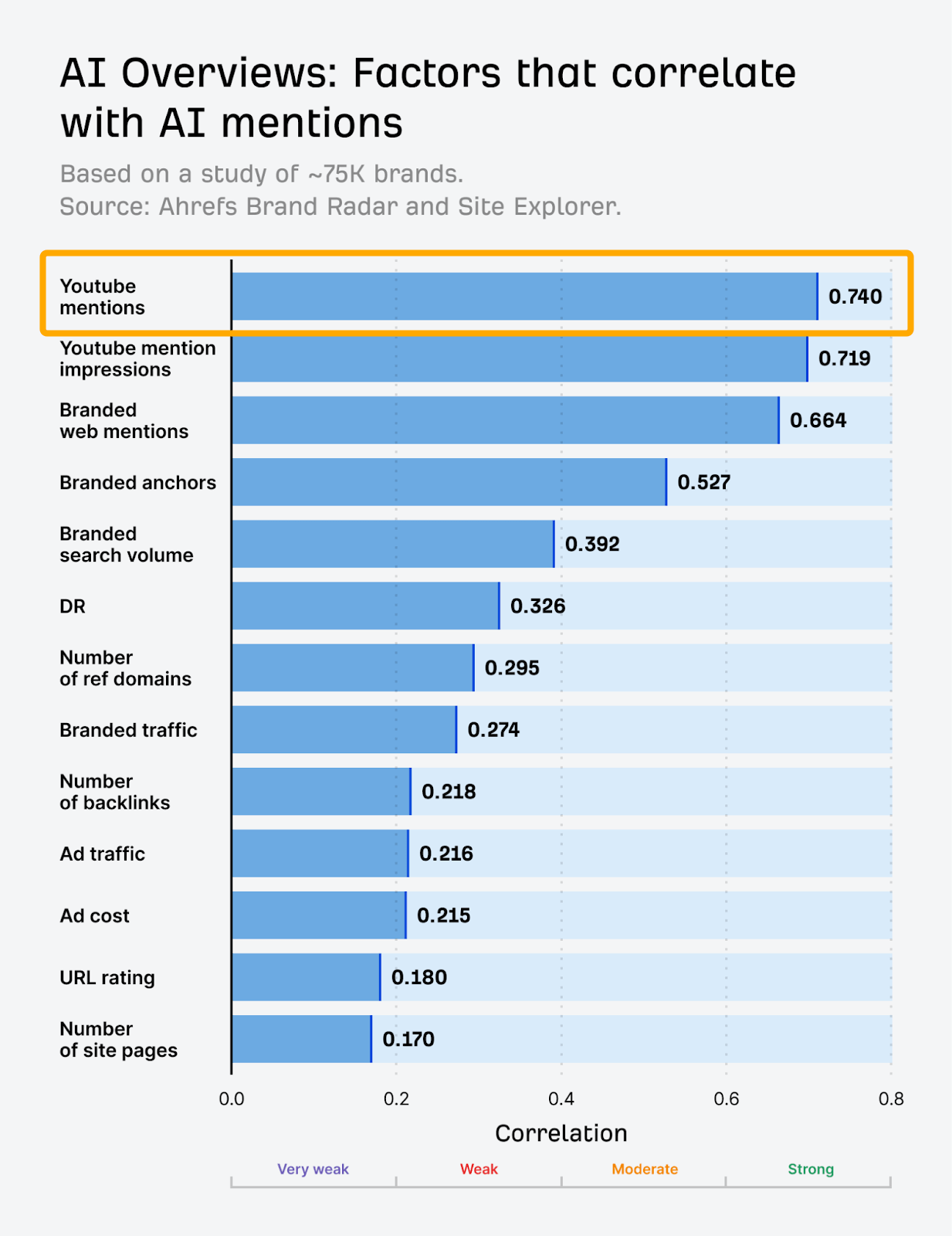

Ahrefs の調査では、ブランドメンションは AI による概要での可視性と最も強く相関する要因であることが分かっています。

では、オフサイトでのブランドメンションを、どのようにして能動的に増やしていけばよいのでしょうか。

「ベスト〇〇」系記事でのメンションを狙ったアウトリーチ

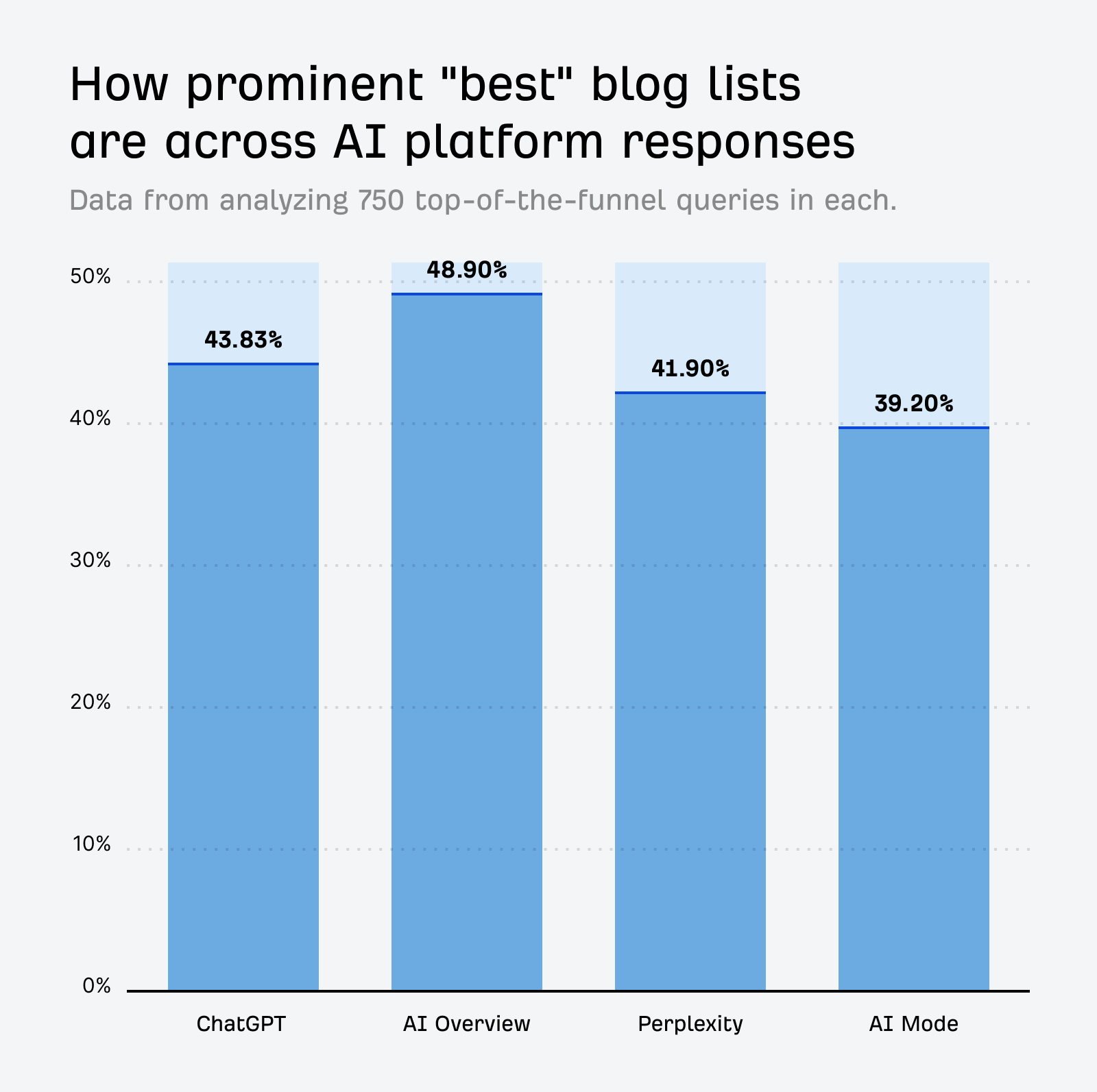

Ahrefs のマーケティング戦略・リサーチ責任者であるグレン・アルソップによる調査では、「ベスト〇〇」系の記事の有効性が明らかになっています。

調査の結果、Google の AI による概要が「ベスト〇〇」系の記事を強く優遇しており、AI による概要における引用の約 50% がこのカテゴリに該当しています。

「ベスト◯◯」系の記事に掲載されることで可視性は高まりますが、その推薦が不自然に感じられる場合、肯定的なブランド認知やユーザー体験、最終的な ROI にはつながらないという点を忘れてはいけません。

そのため、こうしたリストでの露出を狙ったアウトリーチは、慎重に行う必要があります。デモや短期間のトライアルを提供する場合は、その旨をきちんと明示し、ライターが正直なレビューを書けるようにしましょう。

また、すでに公開されている記事に自社ブランドを売り込んだり、メンションを追加してもらうために交渉したりするのではなく、まだ「ベスト〇〇」記事を書いていない、業界内で権威あるサイトを狙うのも有効な手段です。

そうしたサイトに対して、「◯◯のベスト製品」のレビュー記事を検討してもらえないか打診してみましょう。さらに、次のようなサポートを提供することもできます。

- キーワード調査を代行して行う

- トラフィックの可能性を提案する(例:「競合は、同様の記事から具体的な数値で示せるレベルの安定したトラフィックを獲得しています」)

- 自社製品を紹介し、試用機会を提供する

そうすることで、単にお願いをするのではなく、価値を提供して掲載してもらう理由を作ることができます。

製品紹介で YouTube クリエイターと提携する

Ahrefs 最新のブランド要因調査では、YouTube でのメンションが AI による概要の可視性と最も強い相関関係にあることがわかりました。

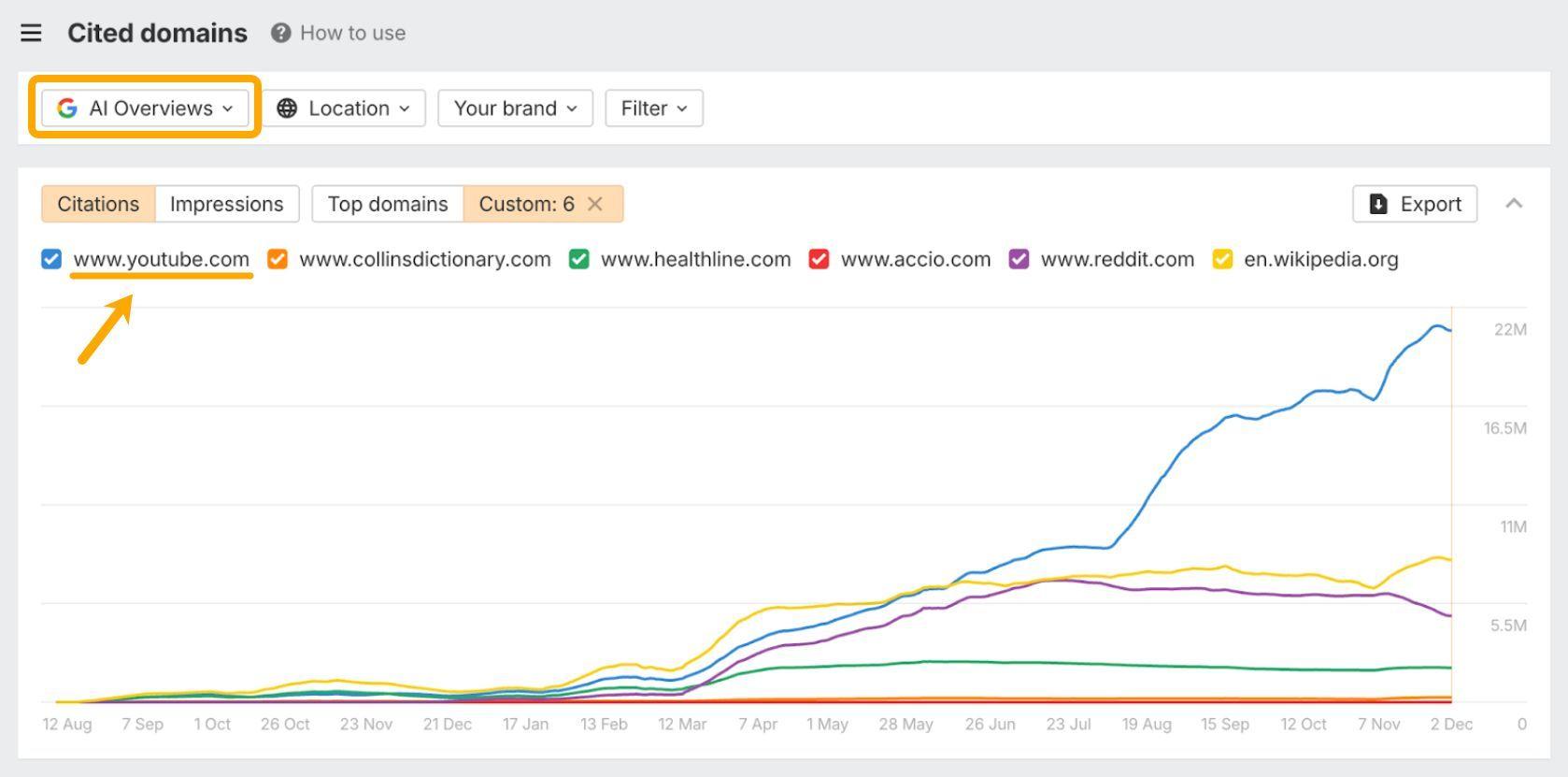

ブランドレーダーのデータを見ると、YouTube は AI による概要で最も多く引用されているドメインです。こうした点からも、この結果は理にかなっています。

YouTube でパートナーシップを構築し、AI による概要への掲載を増やす方法は以下の通りです。

- チュートリアル、比較、解説系など、自社製品が自然にフィットするコンテンツを発信しているチャンネルを探す

- 単にレビューを依頼するのではなく、相手の視聴者にとって価値のある具体的な動画企画を提案する(例:プロジェクト管理ツールであれば「リモートチームのためのワークフロー設定」など)

- 新機能への早期アクセス、独占データ、または十分なデモなどを用意し、自社製品を自然に動画へ組み込めるようにする

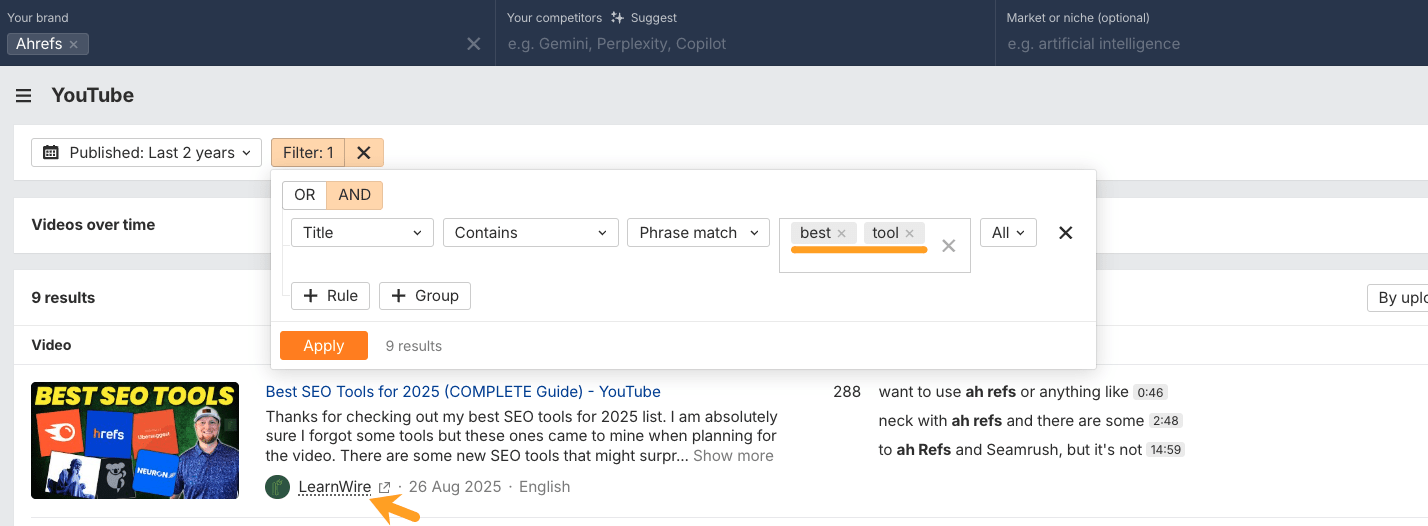

そして何より重要なのは、すでに AI による概要に表示されている YouTuber を見つけることです。もしその中で、すでに自社ブランドへのメンションがあるチャンネルがあれば、なおさら有望な機会と言えるでしょう。

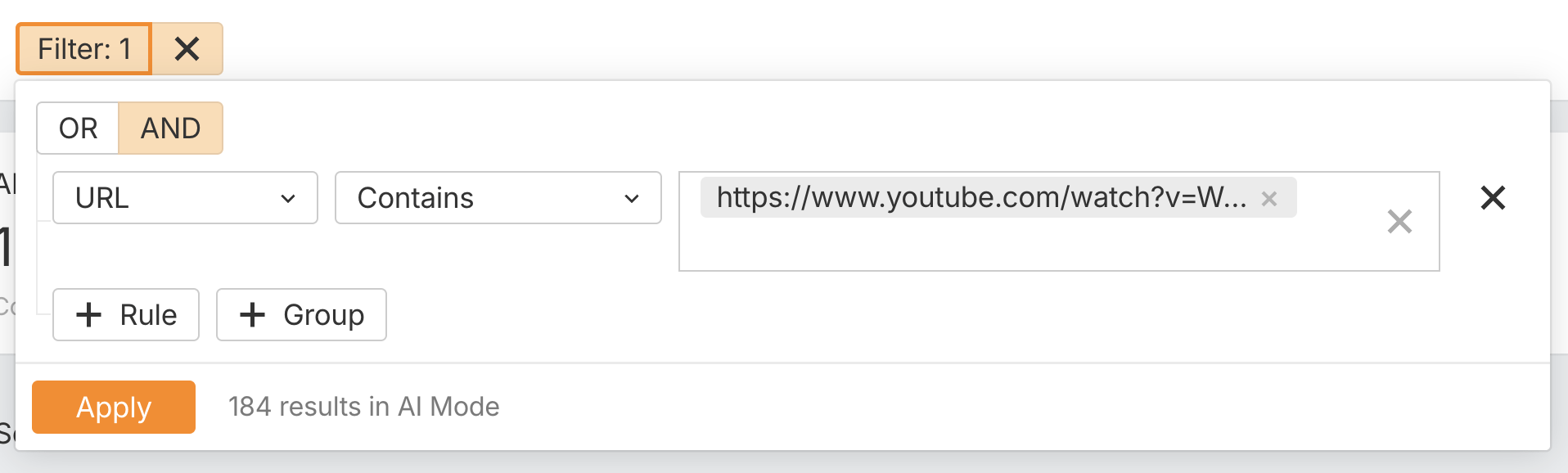

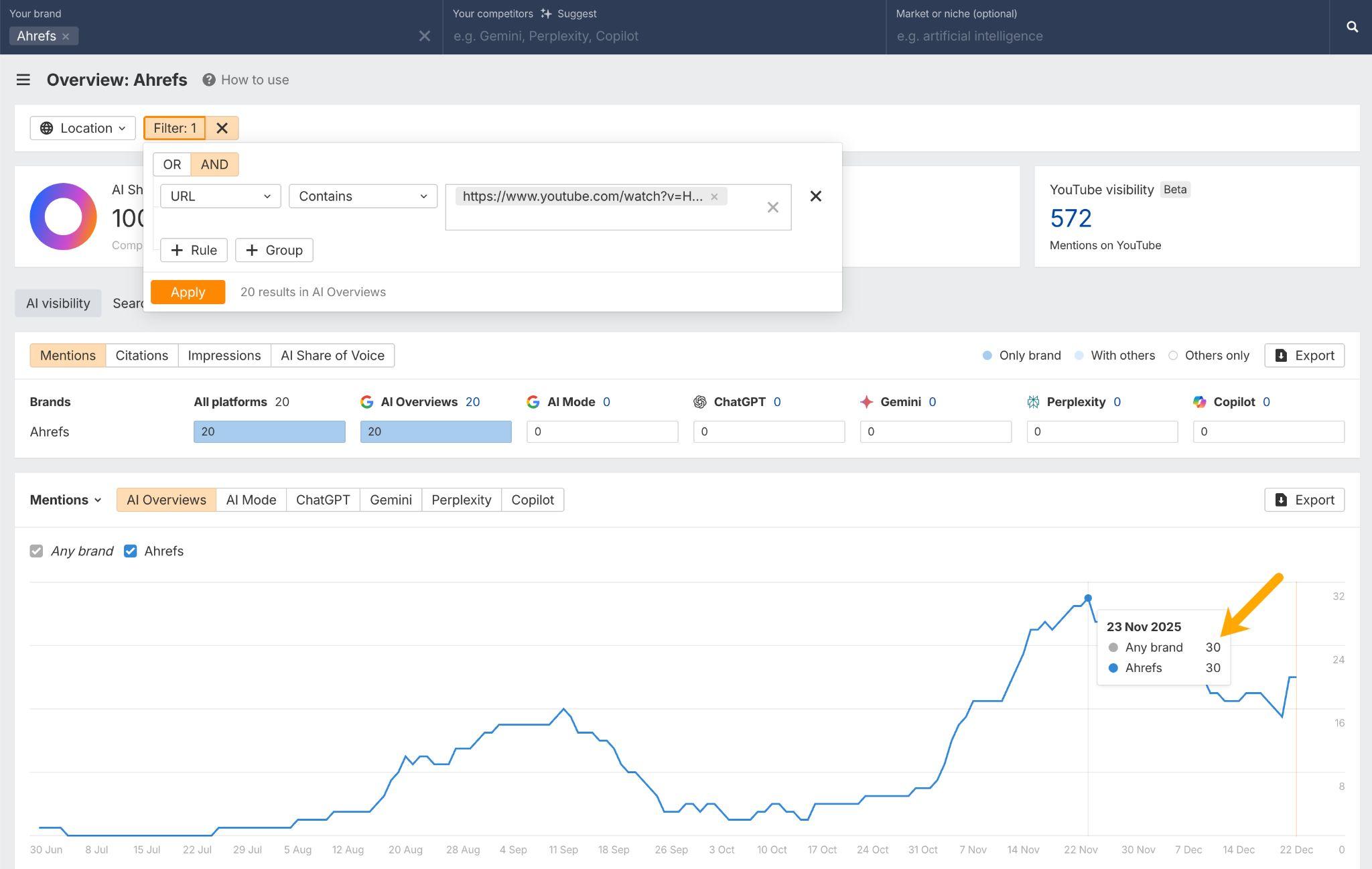

どの動画が AI での可視性につながっているかを追跡する

ブランドレーダーを使って、自社ブランドへのメンションがある YouTube 動画のうち、実際に AI による概要に表示されているものを確認します。

1. YouTube モニタリングレポートを確認し、関連するキーワードでフィルタリングします。

自社ブランドへのメンションがある動画の URL をコピーし、ダッシュボード上の「チャンネル URL > 含む」フィルターに貼り付けます。

3.どの動画が AI による概要の引用を発生させているかを確認します。たとえば、ある 1 本の動画によって、AI による概要内で Ahrefs が最大 30 回もメンションされていました。

こうした情報をもとに、成功パターンを参考にして類似の動画を自社で制作するか、同様のコンテンツを制作しているクリエイターに自社を売り込むという選択肢があります。

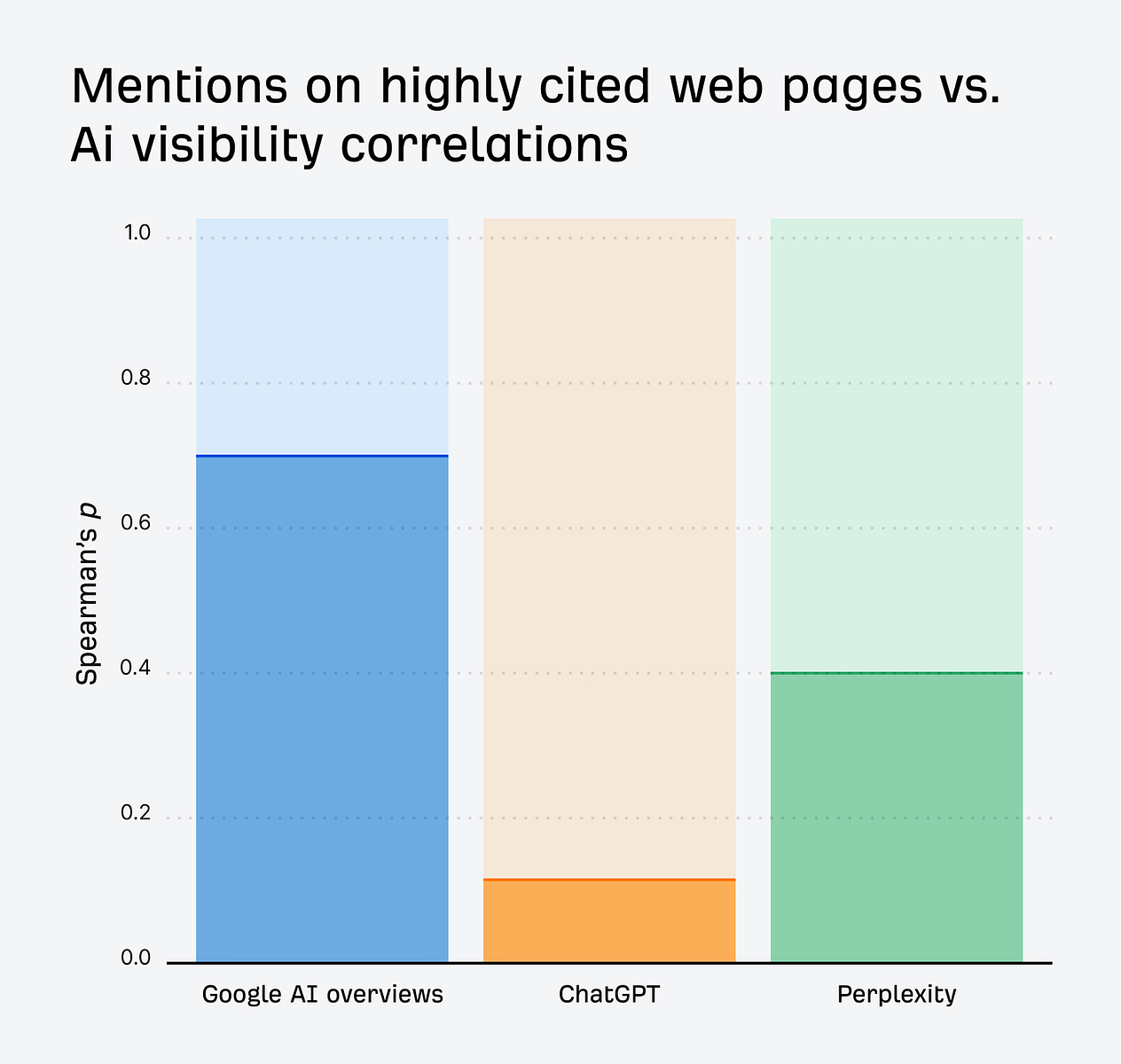

Ahrefs は、7,670 万件の AI による概要を対象に、言及されている上位 50 サイトを分析しました。その結果、被リンクの多いページで言及されていることと、AI による概要での可視性との間には、相関係数 0.70 という強い相関があることが分かりました。

他のウェブサイトからリンクする価値があると判断されているページは、それだけ影響力も大きくなります。そうした権威性の高い情報源に自社ブランドが掲載されることで、AI による概要でメンションされる可能性は大きく高まります。

重要なのは、単にメンションされることではなく、すでに強力な被リンクプロファイルを持っているページでのメンションを獲得することです。

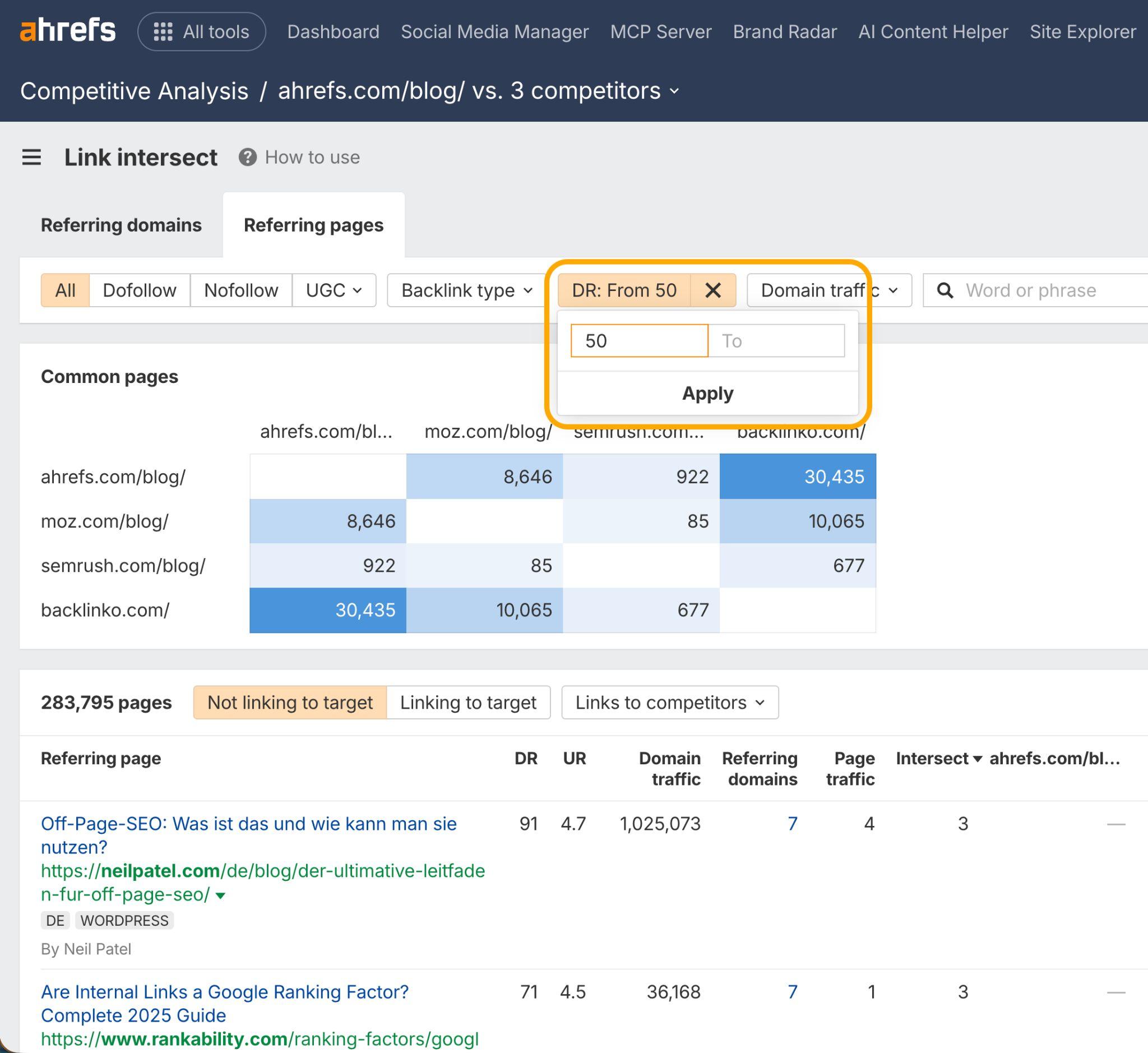

このようなページを見つけるには、Ahrefs の「競合分析」内にある「リンク交差」レポートを開きます。

そして「参照ページ」タブを選択し、DR(ドメイン評価) 50 以上のページでフィルタリングします。

これにより、競合には言及しているものの、自社にはまだ触れていない業界内の権威性の高いページを見つけることができます。

そうしたページに対して、ゲスト投稿を提案したり、専門家のコメントを提供したり、他サイトがトップページで言及したくなるようなコンテンツを作成して提供しましょう。

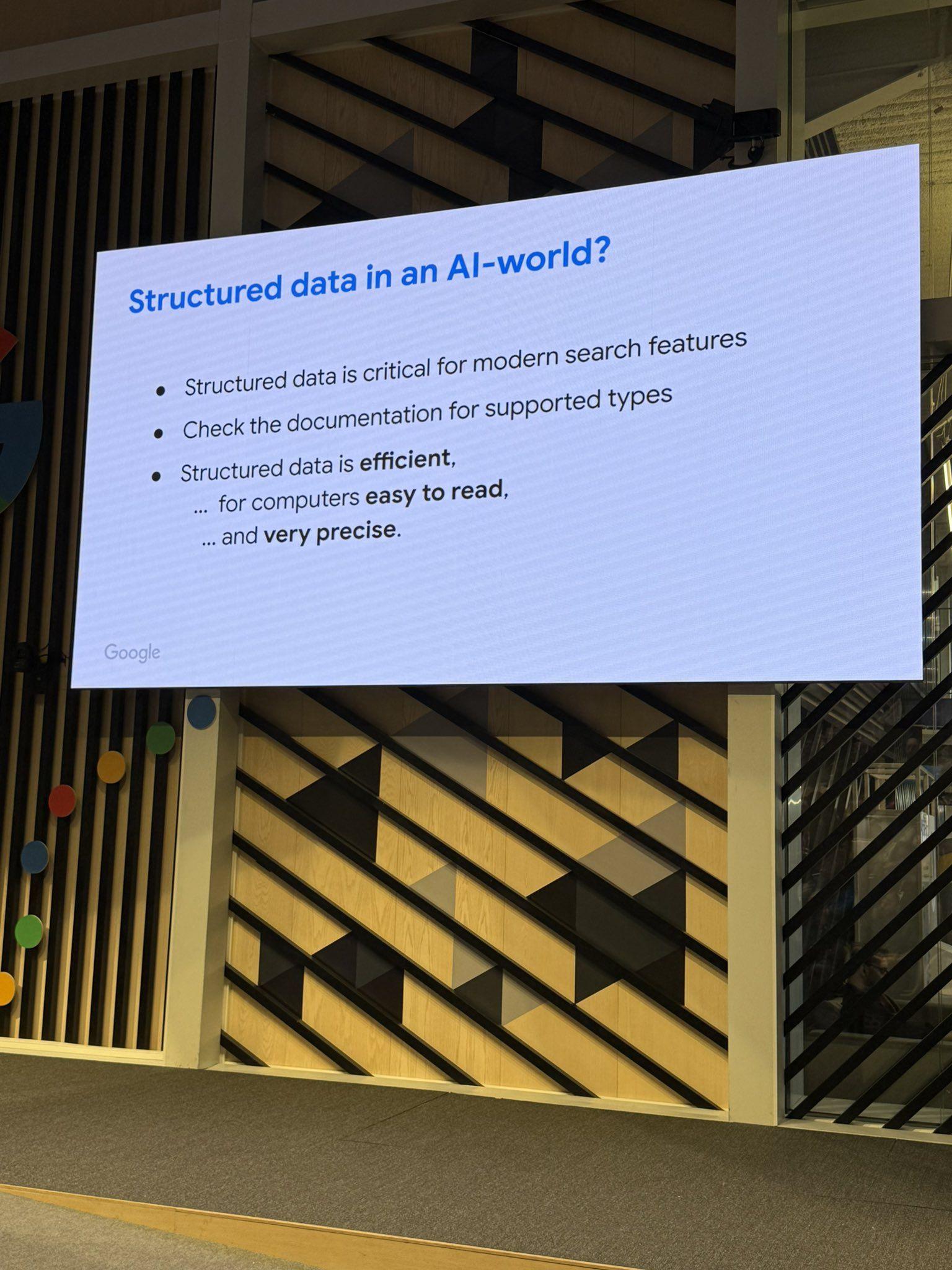

構造化データはAI 検索での表示機会を高めるのに役立つ、という考えは広く浸透しています。

しかし、Google の AI モデルである Gemini がどの程度スキーマを認識しているかについては、まだ結論が出ていません。

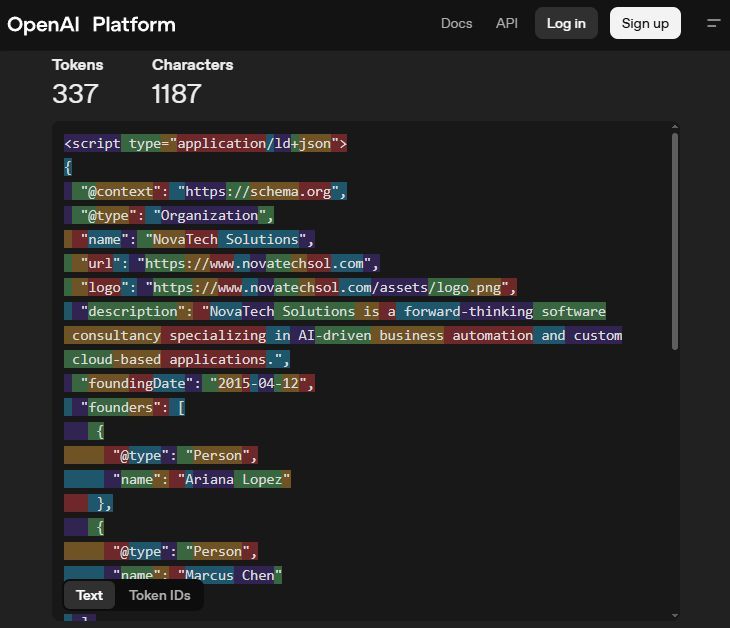

大規模言語モデル(LLM)は、学習の過程で単語を数値表現に変換するため、コンテンツ内に含まれるスキーママークアップは、結果的にランダム化されてしまいます。

さらに、多くの AI クローラーは、スキーマがクライアントサイドでレンダリングされている場合、たとえば JavaScript 経由では、そのデータにアクセスできません。実際、数多くのサイトがこの構成を採用していますが、AI クローラー側は十分に対応できていないのが現状です。

その結果、AI クローラーはページを完全に読み込むのではなく、生の HTML を参照したり、基本的なスナップショットを利用したりする傾向があります。少なくとも現時点では、こうした挙動が一般的です。

サイトが JavaScript に大きく依存している場合でも、対処方法はあります。prerender.io などのツールを使えば、スキーマや本文、リンクを含んだ完成済みの HTML をボットに見せることができます。

とはいえ、構造化データは、AI 検索での可視性に間接的な影響を与えると考えられています。

実際、Google Search Central Live カンファレンスでは、シニアサーチアナリストのジョン・ミューラーさんが、構造化データは AI 検索にとって重要であると明言しています。

これは、RAG(検索拡張生成)の仕組みにより、AI の可視性が検索での可視性に大きく依存しているためです。

RAG では、AI プラットフォームが SERP(検索結果ページ)を参照し、既存の学習知識に新しい情報を補完します。このプロセスは、先ほど触れた「グラウンディング」と呼ばれています。

AI クローラーとは異なり、構造化データは Google の検索エンジンボットによって比較的適切に処理されます。また、検索エンジンが基盤としているナレッジグラフの構築にも寄与するため、検索での可視性にとって重要な要素でもあります。

言い換えれば、構造化データを実装することで SERP に表示されやすくなり、その結果、RAG の過程で AI による概要に選ばれる候補に入りやすくなるということです。

現時点では、スキーママークアップが AI による概要での順位向上に直接寄与するという決定的な証拠はありません。ただし、Google と Microsoft の双方が、構造化データは AI システムがコンテンツを正しく解釈する助けになると明言しています。

Ahrefs は現在、スキーマが AI の可視性に与える影響についての調査を行っており、近いうちにその結果を追って報告する予定です。

それまでの間、Article や HowTo、FAQPage などの関連性の高いスキーマタイプを実装しておくことは、従来の SEO の観点でも推奨されており、AI システムに対するコンテンツの機械可読性を高める、比較的取り組みやすい施策と言えます。

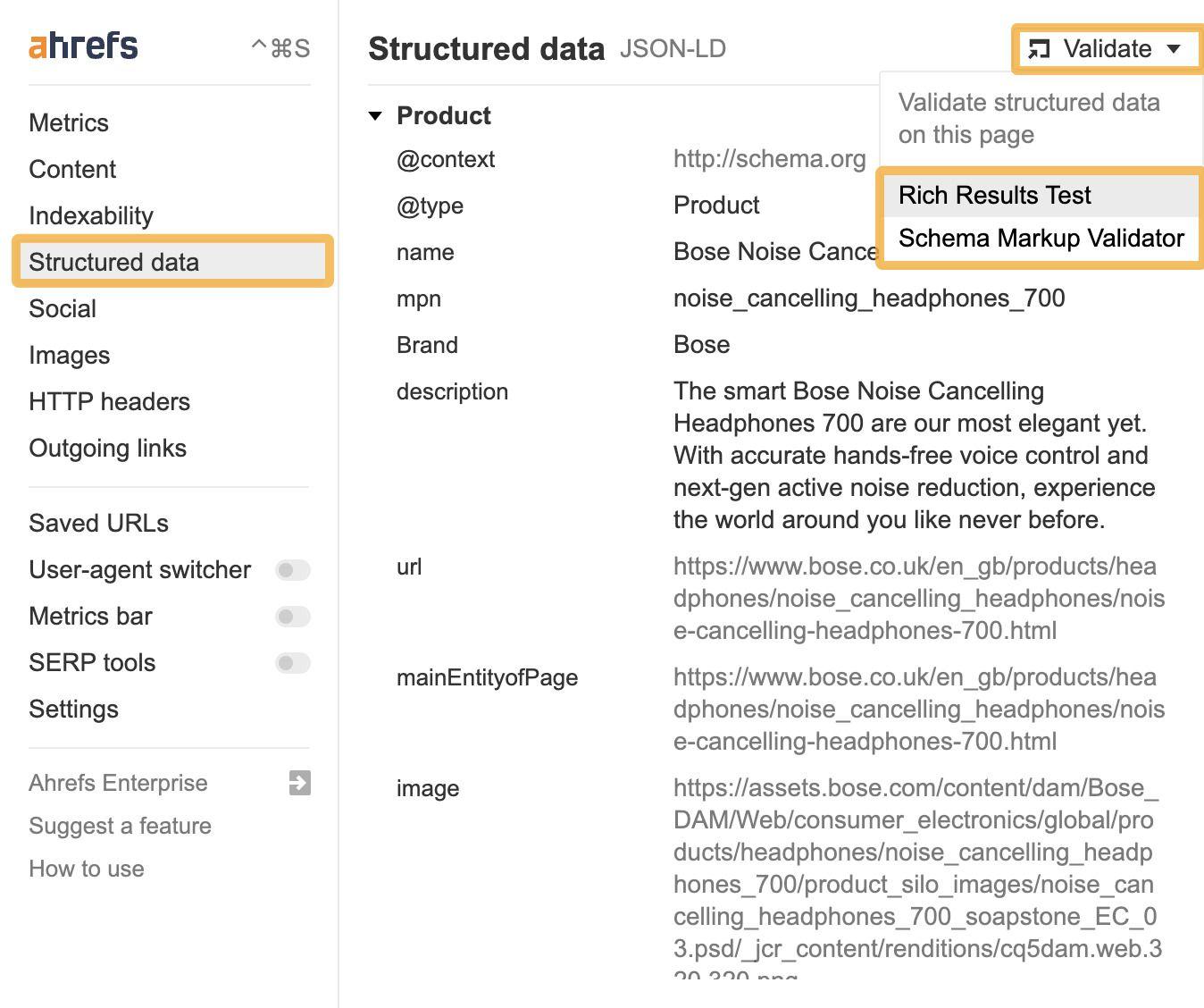

既存のスキーママークアップを確認する際は、Schema Validator や Google の Rich Results Test ツールを利用できます。

これらのツールは、Ahrefs SEO ツールバーの「Structured data(構造化データ)」タブからもアクセス可能です。

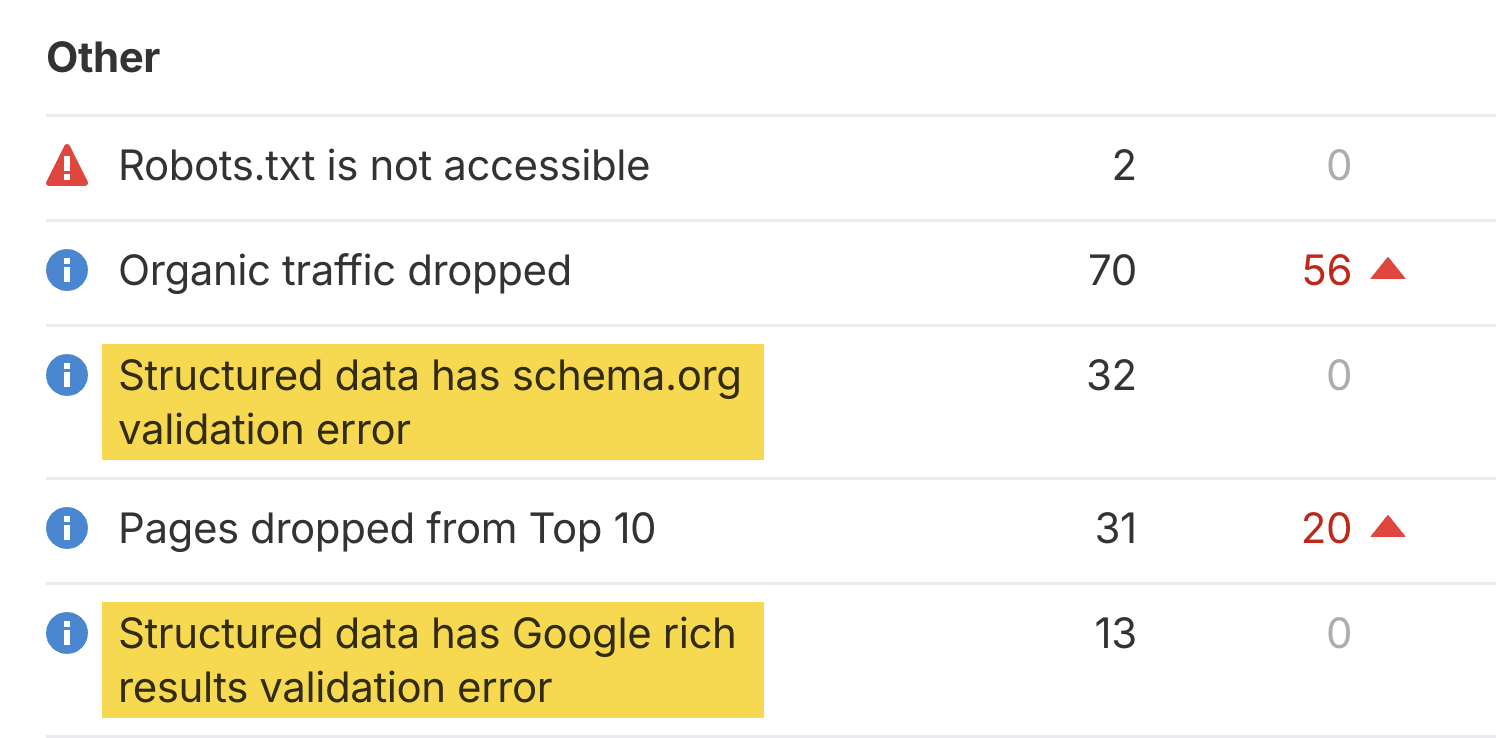

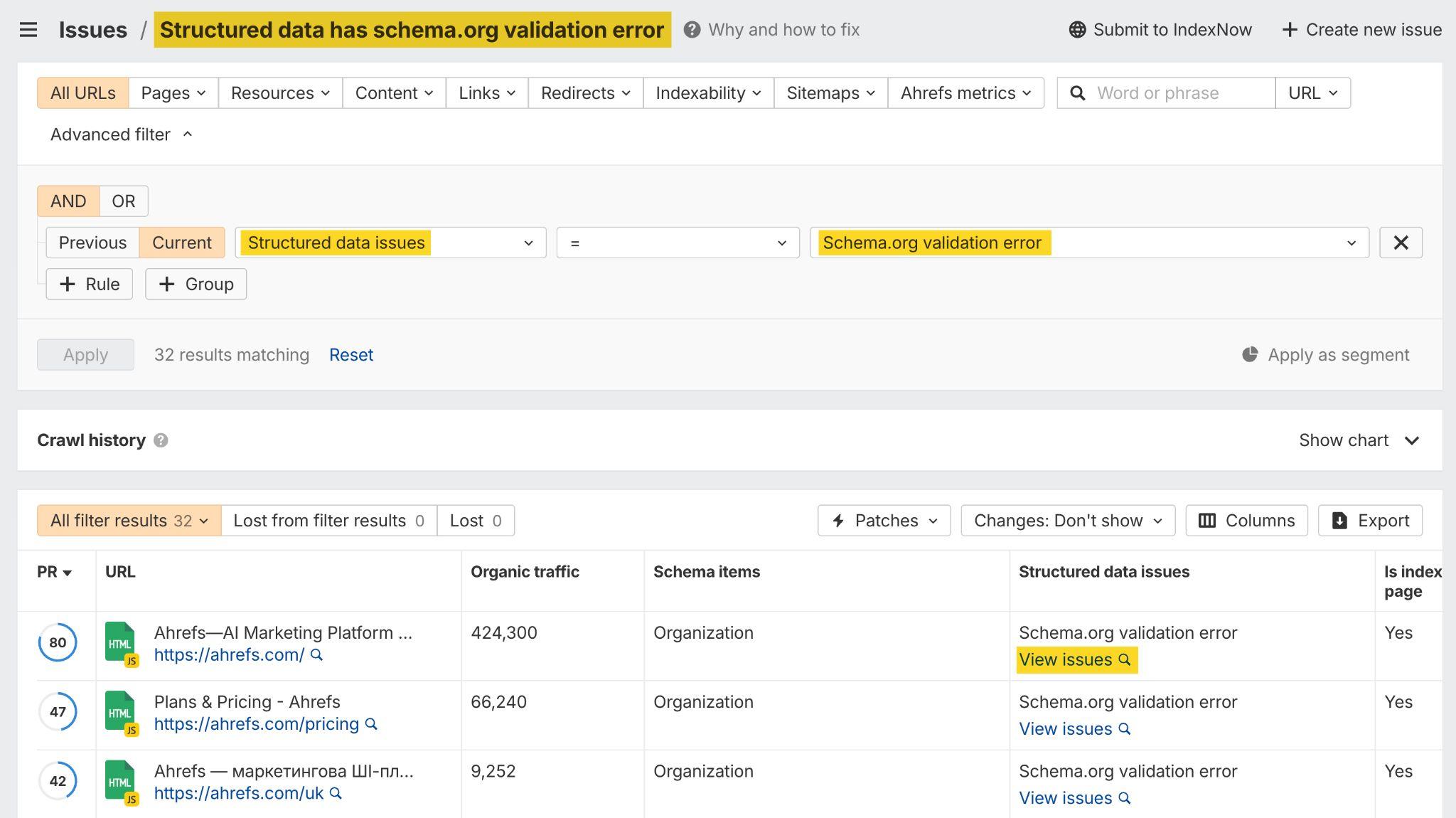

コンテンツの完全なスキーマ監査を行いたい場合は、Ahrefs の サイト監査でサイトまたはブログのクロールを設定し、「Issues(問題点)」レポートに移動してください。これにより、構造化データの問題点が表示されます。

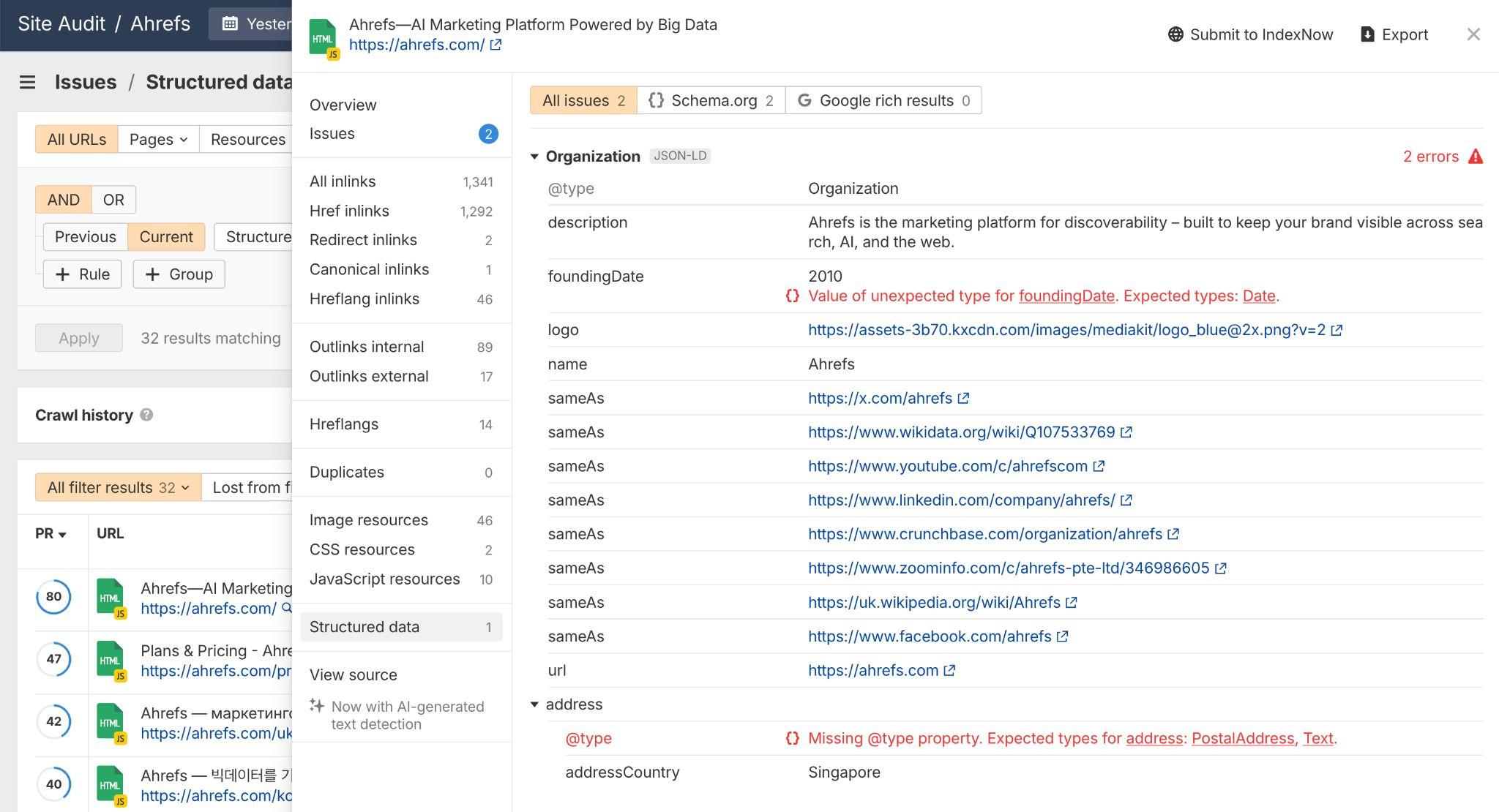

各行をクリックすると、ページエクスプローラーのレポートに移動し、影響を受けているすべてのページを確認できます。

次に「View issues(問題点を確認する)」を展開して、具体的に何が不足しているのかを確認したうえで、修正を行います。

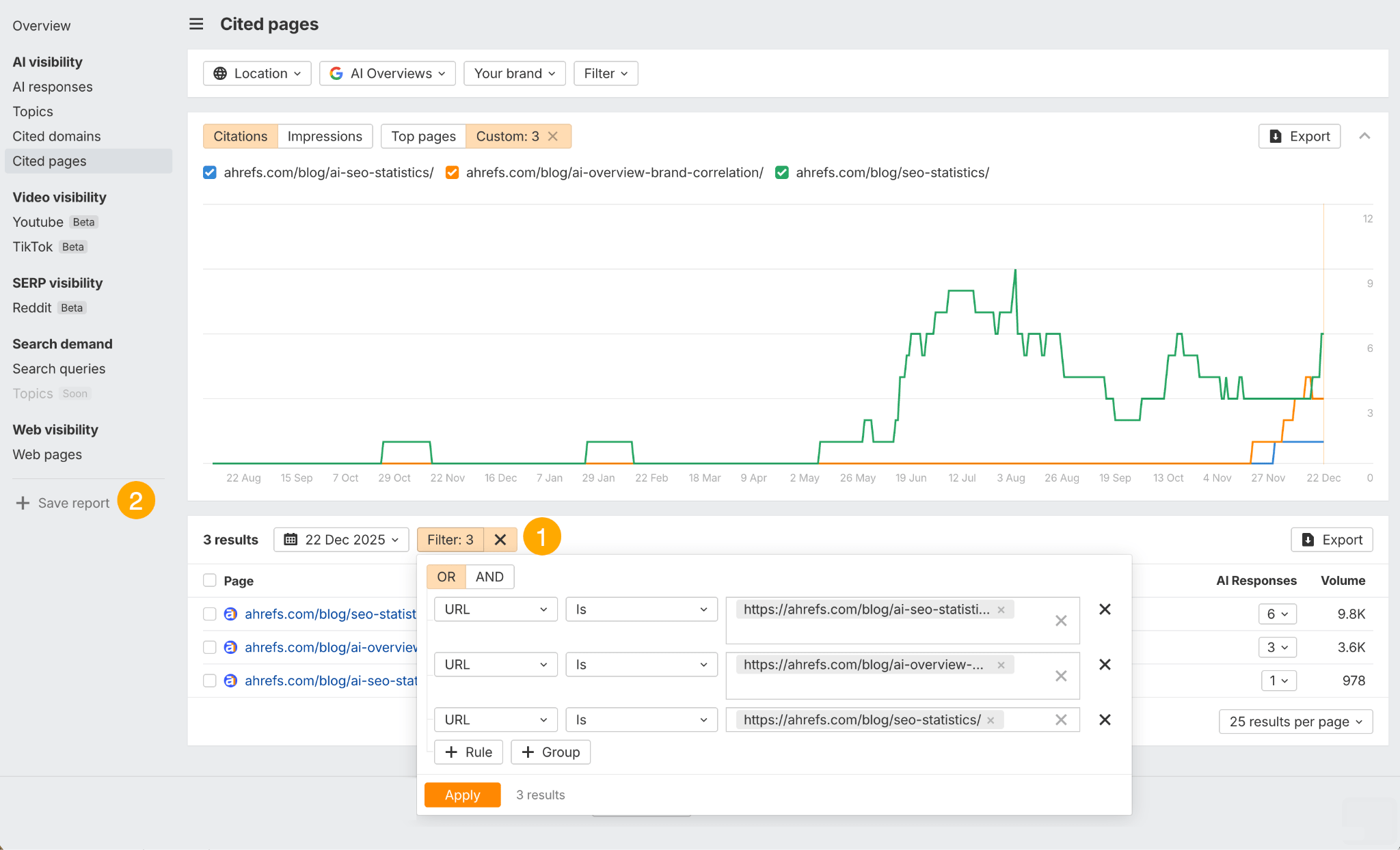

最後に、Ahrefs のブランドレーダーで影響を受けた URL をモニタリングし、修正内容が AI による概要での可視性向上につながっているかを確認します。「引用されたページ」レポートで引用フィルターを設定し(①)、「レポートを保存」をクリックする(②)だけです。

まとめ

AI による概要 は今後もなくなることはなく、そこで評価されるためのルールは、いままさに形作られている最中です。

本記事で紹介してきたすべての戦略は、トピックに対する専門性と権威性の構築から検索意図との適切な一致に至るまで、憶測ではなく、数百万件に及ぶ AI の回答分析、信頼できる第三者調査、そして Google からの公式なガイダンスに基づいています。

まずはトピックレベルでの最適化と、実態を伴ったブランドメンションの獲得から始め、そこに技術的な改善を段階的に重ねていきましょう。